Elkeid - Bytedance Cloud Workload Protection Platform

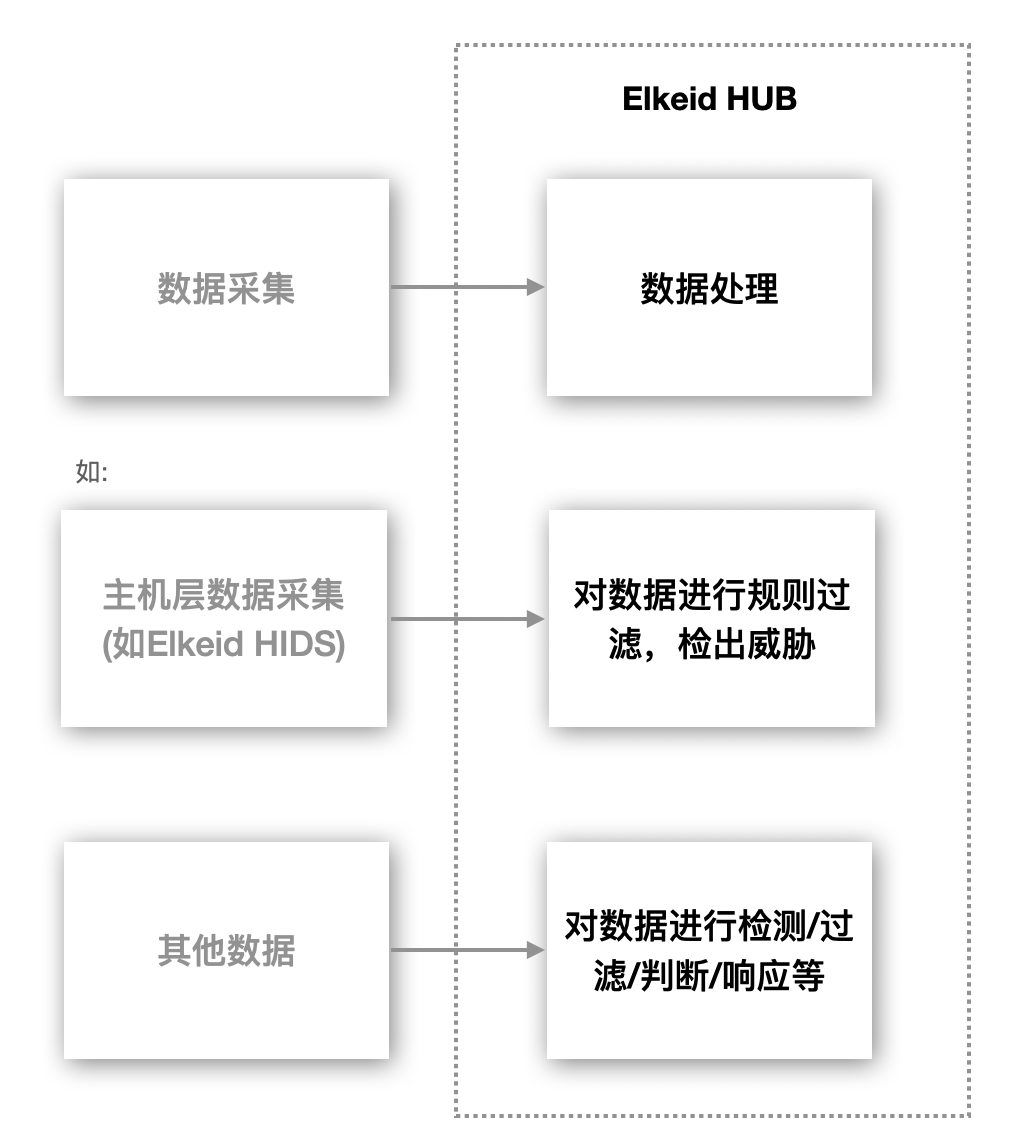

Elkeid 是一款可以满足 主机,容器与容器集群,Serverless 等多种工作负载安全需求的开源解决方案,源于字节跳动内部最佳实践。

随着企业的业务发展,多云、云原生、多种工作负载共存的情况愈发凸显,我们希望可以有一套方案可以满足不同工作负载下的安全需求,因此 Elkeid 诞生了。

Introduction

Elkeid 具备以下主要能力:

-

Elkeid 不仅具备传统的 HIDS(Host Intrusion Detection System) 的对于主机层入侵检测和恶意文件识别的能力,且对容器内的恶意行为也可以很好的识别,部署在宿主机即可以满足宿主机与其上容器内的反入侵安全需求,并且 Elkeid 底层强大的内核态数据采集能力可以满足大部分安全运营人员对于主机层数据的渴望。

-

对于运行的业务 Elkeid 具备 RASP 能力可以注入到业务进程内进行反入侵保护,不仅运维人员不需要再安装一个 Agent,业务也无需重启。

-

对于 K8s 本身 Elkeid 支持接入K8s Audit Log 对 K8s 系统进行入侵检测和风险识别。

-

Elkeid 的规则引擎 Elkeid HUB 也可以很好的和外部多系统进行联动对接。

Ekeid 将这些能力都很好的融合在一个平台内,满足不同工作负载的复杂安全需求的同时,还能实现多组件能力关联,更难得的是每个组件均经过字节跳动海量数据和多年的实战检验。

Elkeid Community Edition Description

需要注意的是 Elkeid 开源版本 和完整版本存在差异,目前已开源的能力主要包括:

- 全部端上能力,即端上数据/资产/部分采集能力,内核态数据采集能力,RASP 探针部分等,并与字节跳动内部版本一致;

- 全部接入层能力,即 Agent Center,服务发现等,并与字节跳动内部版本一致;

- 提供社区版规则引擎即 Elkeid HUB,并配套少量策略作为示例使用;

- 提供社区版 Elkeid Console 与部分配套能力。

因此需要具备完整的反入侵与风险感知能力,还需要自行基于 Elkeid HUB 进行策略构建和对 Elkeid 采集的数据进行二次加工等工作。

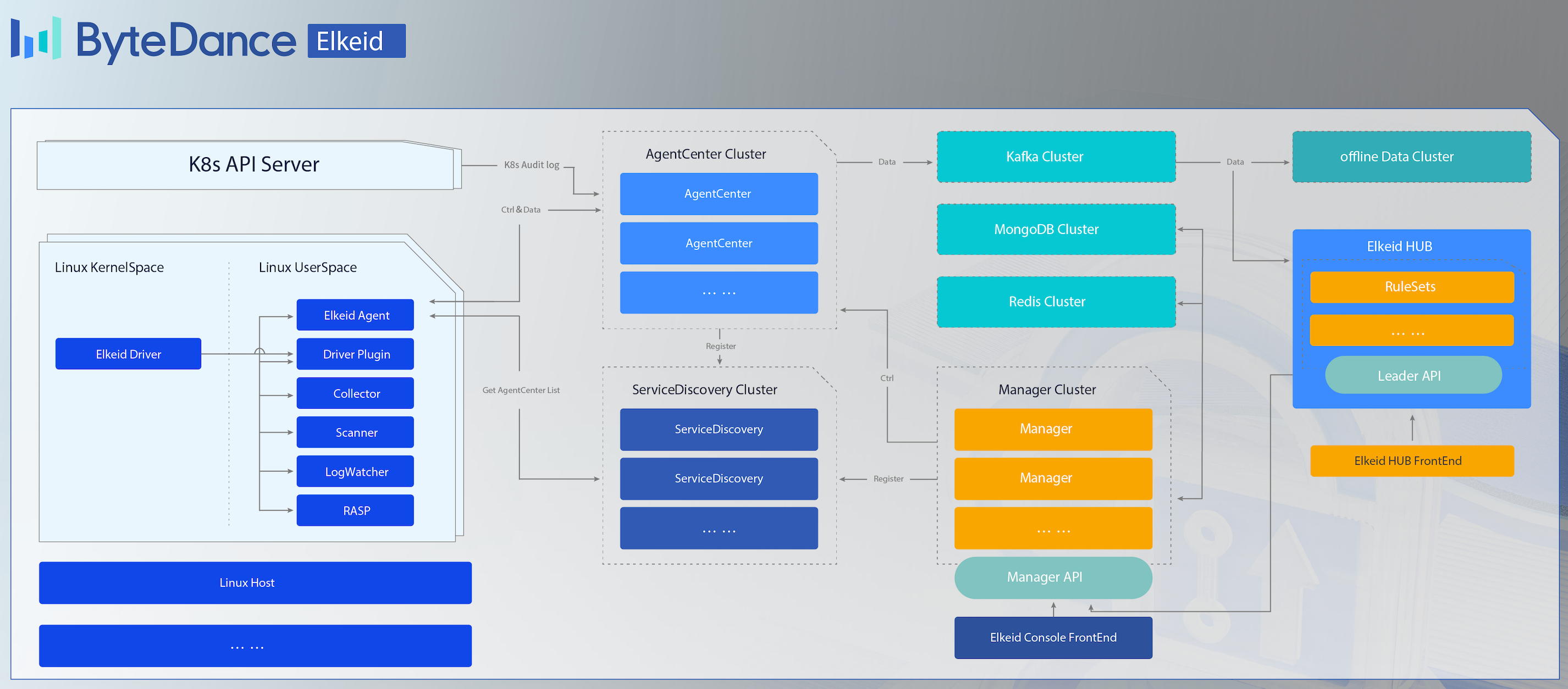

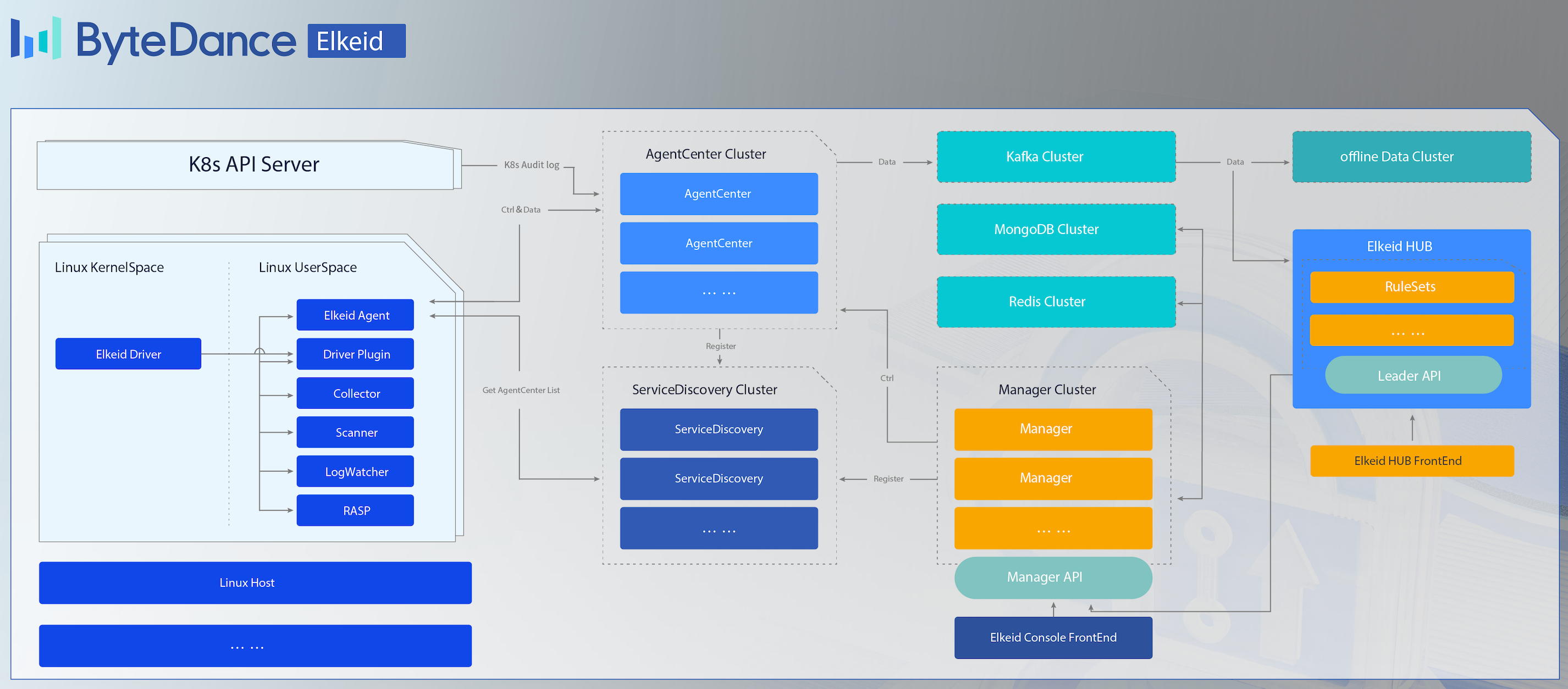

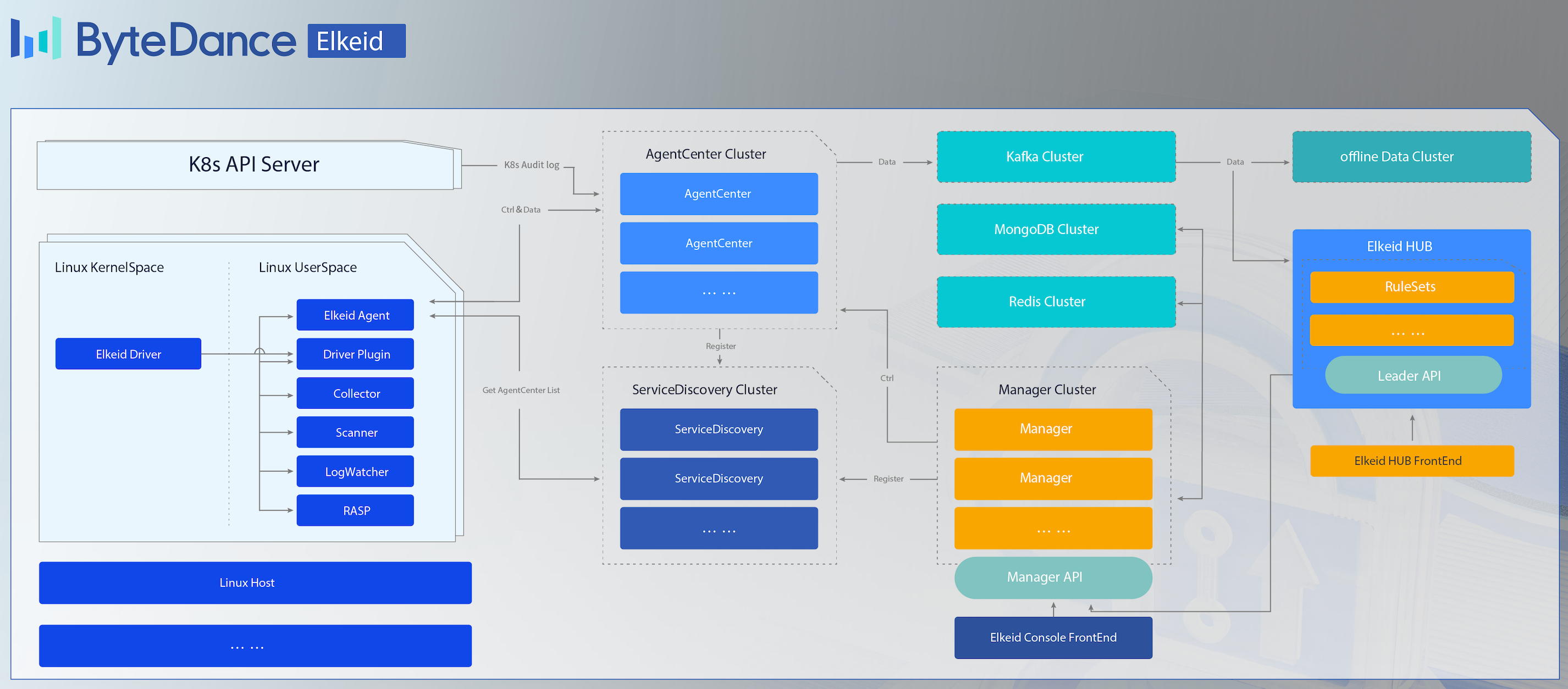

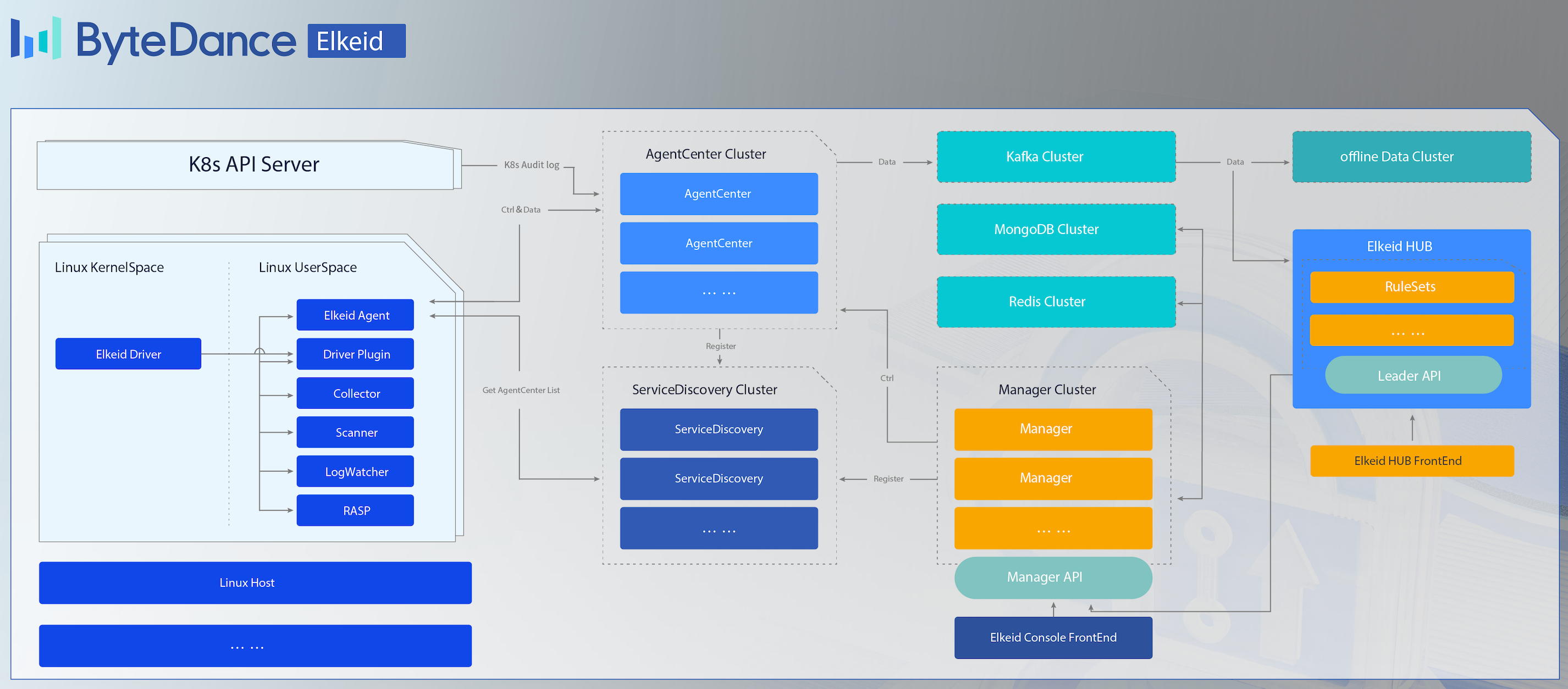

Elkeid Architecture

Elkeid Host Ability

- Elkeid Agent 用户态 Agent,负责管理各个端上能力组件并与 Elkeid Agent Center 通信

- Elkeid Driver 负责 Linux Kernel 层采集数据,兼容容器,并能够检测常见 Rootkit

- Elkeid RASP 支持 CPython、Golang、JVM、NodeJS、PHP 的运行时数据采集探针,支持动态注入到运行时

- Elkeid Agent Plugin List

- Driver Plugin: 负责与 Elkeid Driver 通信,处理其传递的数据等

- Collector Plugin: 负责端上的资产/关键信息采集工作,如用户,定时任务,包信息等

- Journal Watcher: 负责监测systemd日志的插件,目前支持ssh相关日志采集与上报

- Scanner Plugin: 负责在端上进行静态检测恶意文件的插件,支持 Yara

- RASP Plugin: 分析系统进程运行时,上报运行时信息,处理下发的 Attach 指令,收集各个探针上报的数据

- Baseline Plugin: 负责在端上进行基线风险识别的插件

- Elkeid 数据说明

- Elkeid 数据接入

Elkeid Backend Ability

- Elkeid AgentCenter 负责与 Agent 进行通信并管理 Agent 如升级,配置修改,任务下发等

- Elkeid ServiceDiscovery 后台中的各组件都会向该组件定时注册、同步服务信息,从而保证各组件相互可见,便于直接通信

- Elkeid Manager 负责对整个后台进行管理,并提供相关的查询、管理接口

- Elkeid Console Elkeid 前端部分

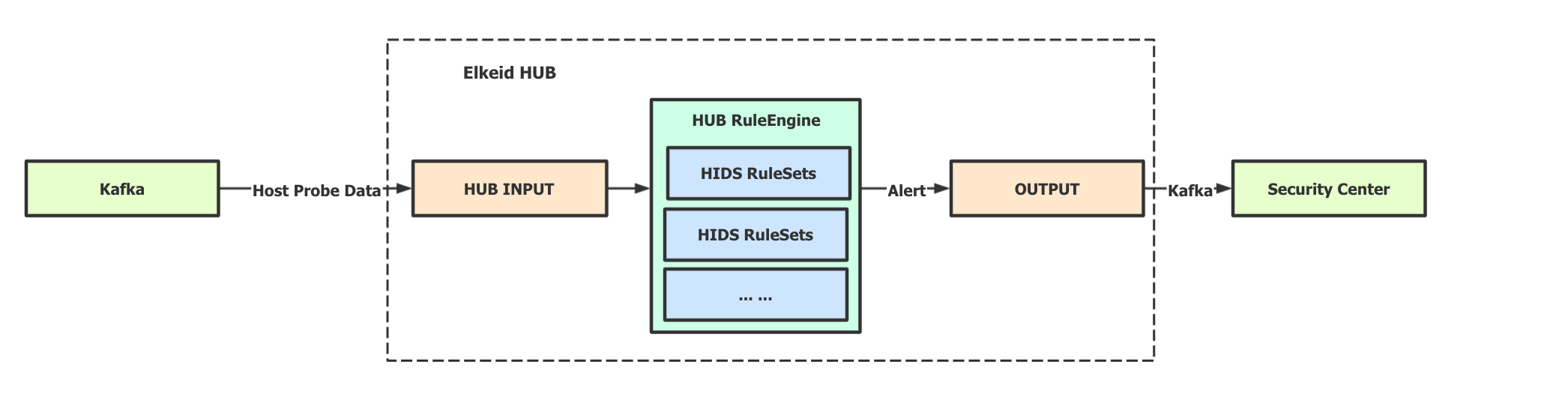

- Elkeid HUB 策略引擎

Elkeid Function List

| 功能 | Elkeid Community Edition | Elkeid Enterprise Edition |

|---|---|---|

| Linux 数据采集能力 | :white_check_mark: | :white_check_mark: |

| RASP 探针能力 | :white_check_mark: | :white_check_mark: |

| K8s Audit Log 采集能力 | :white_check_mark: | :white_check_mark: |

| Agent 控制面 | :white_check_mark: | :white_check_mark: |

| 主机状态与详情 | :white_check_mark: | :white_check_mark: |

| 勒索诱饵 | :ng_man: | :white_check_mark: |

| 资产采集 | :white_check_mark: | :white_check_mark: |

| 高级资产采集 | :ng_man: | :white_check_mark: |

| 容器集群资产采集 | :white_check_mark: | :white_check_mark: |

| 暴露面与脆弱性分析 | :ng_man: | :white_check_mark: |

| 主机/容器 基础入侵检测 | 少量样例 | :white_check_mark: |

| 主机/容器 行为序列入侵检测 | :ng_man: | :white_check_mark: |

| RASP 基础入侵检测 | 少量样例 | :white_check_mark: |

| RASP 行为序列入侵检测 | :ng_man: | :white_check_mark: |

| K8S 基础入侵检测 | 少量样例 | :white_check_mark: |

| K8S 行为序列入侵检测 | :ng_man: | :white_check_mark: |

| K8S 威胁分析 | :ng_man: | :white_check_mark: |

| 告警溯源(行为溯源) | :ng_man: | :white_check_mark: |

| 告警溯源(驻留溯源) | :ng_man: | :white_check_mark: |

| 告警白名单 | :white_check_mark: | :white_check_mark: |

| 多告警聚合能力 | :ng_man: | :white_check_mark: |

| 威胁处置(进程) | :ng_man: | :white_check_mark: |

| 威胁处置(网络) | :ng_man: | :white_check_mark: |

| 威胁处置(文件) | :ng_man: | :white_check_mark: |

| 文件隔离箱 | :ng_man: | :white_check_mark: |

| 漏洞检测 | 少量情报 | :white_check_mark: |

| 漏洞情报热更新 | :ng_man: | :white_check_mark: |

| 基线检查 | 少量基线 | :white_check_mark: |

| RASP 热补丁 | :ng_man: | :white_check_mark: |

| 病毒扫描 | :white_check_mark: | :white_check_mark: |

| 用户行为日志分析 | :ng_man: | :white_check_mark: |

| 插件管理 | :white_check_mark: | :white_check_mark: |

| 系统监控 | :white_check_mark: | :white_check_mark: |

| 系统管理 | :white_check_mark: | :white_check_mark: |

| Windows 支持 | :ng_man: | :white_check_mark: |

| 蜜罐 | :ng_man: | :oncoming_automobile: |

| 主动防御 | :ng_man: | :oncoming_automobile: |

| 云查杀 | :ng_man: | :oncoming_automobile: |

| 防篡改 | :ng_man: | :oncoming_automobile: |

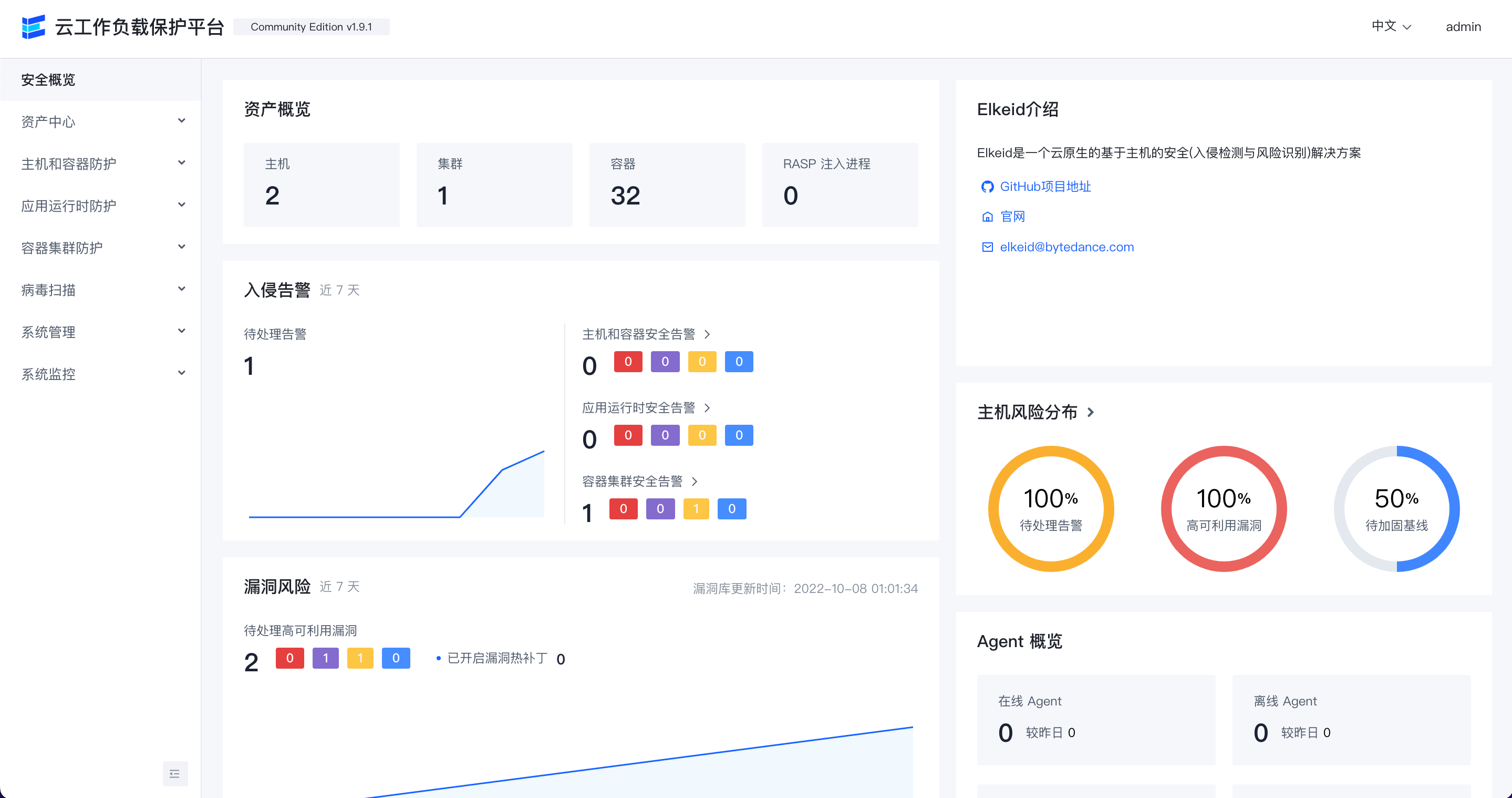

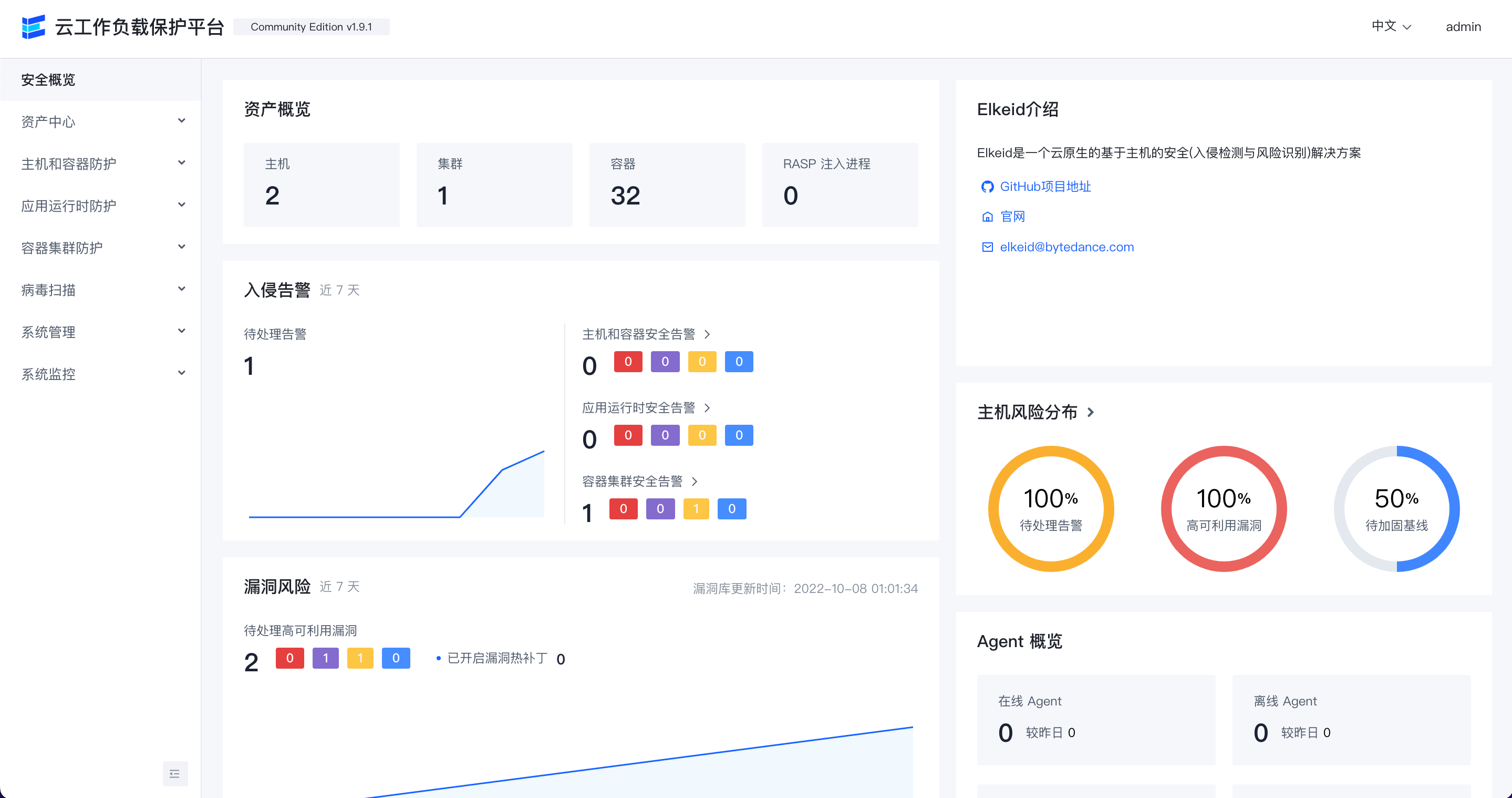

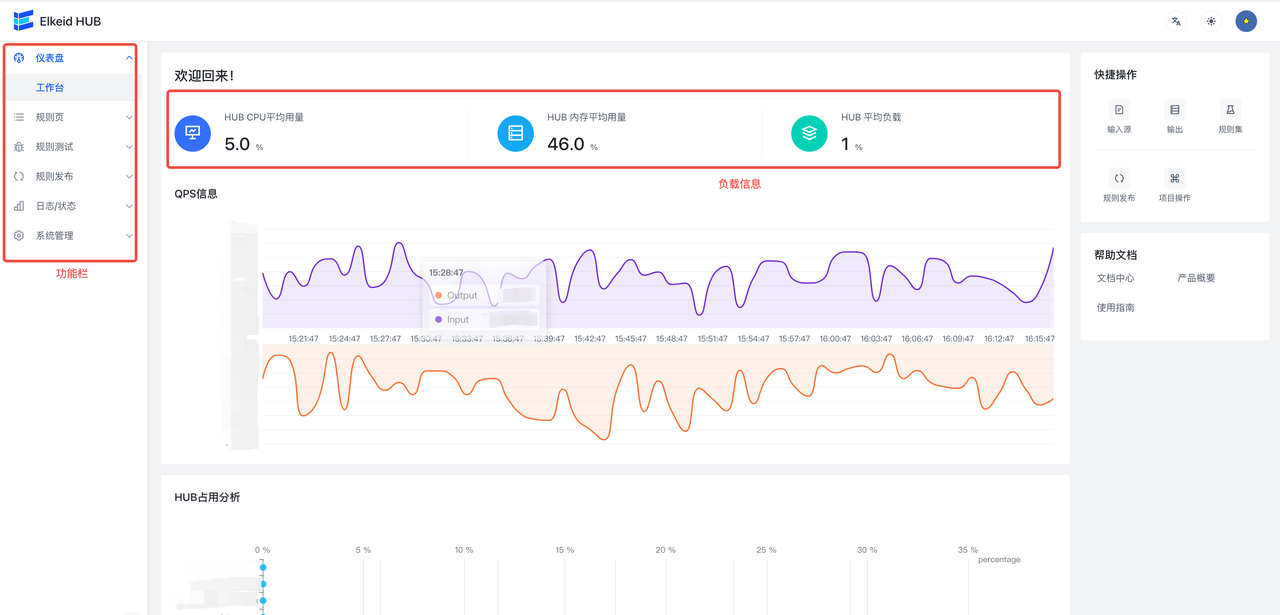

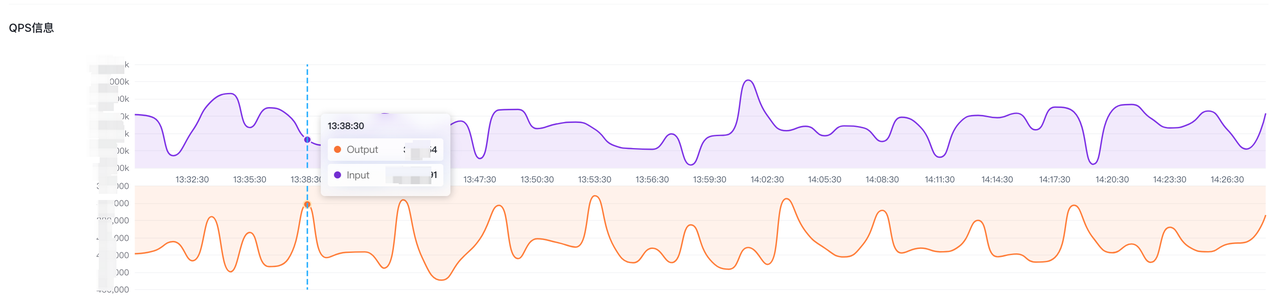

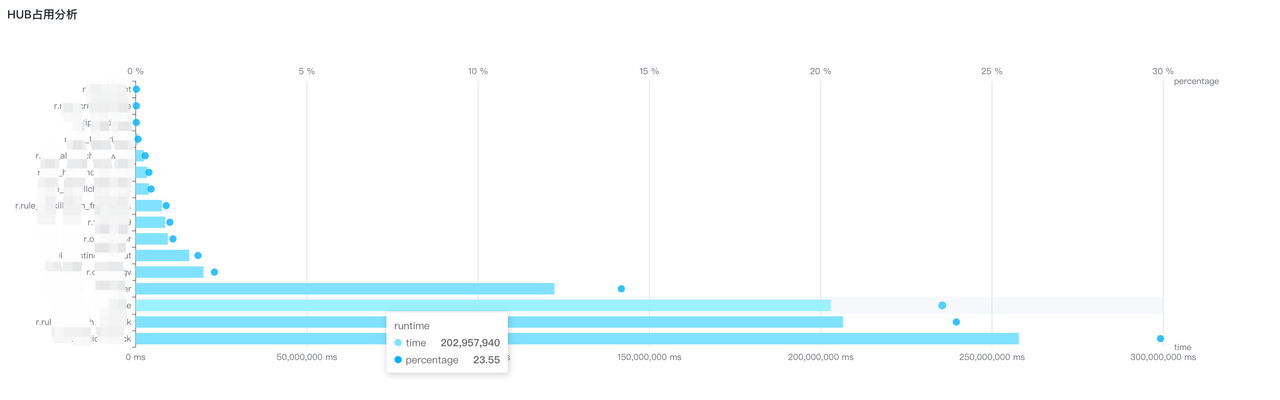

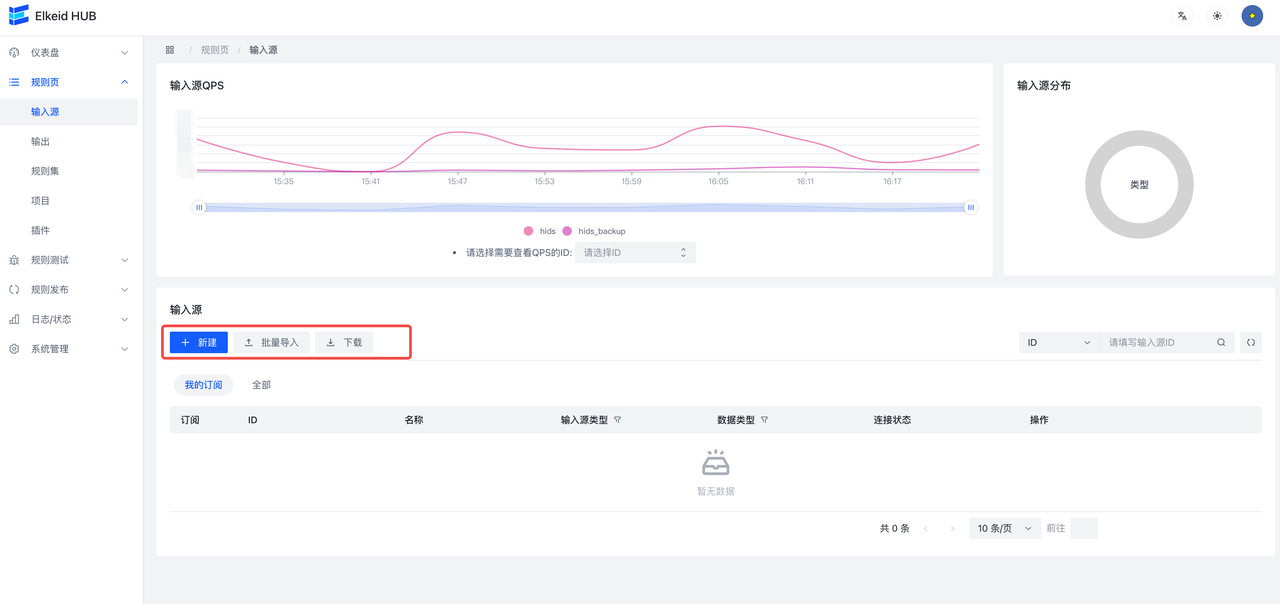

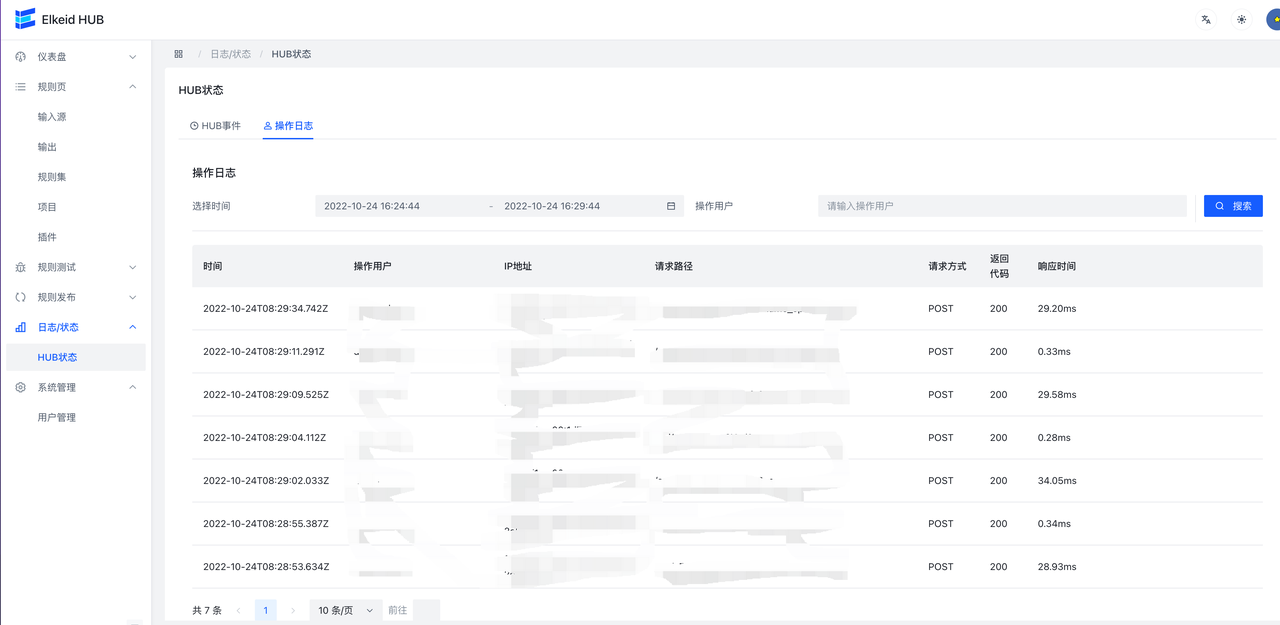

Front-end Display (Community Edition)

安全概览

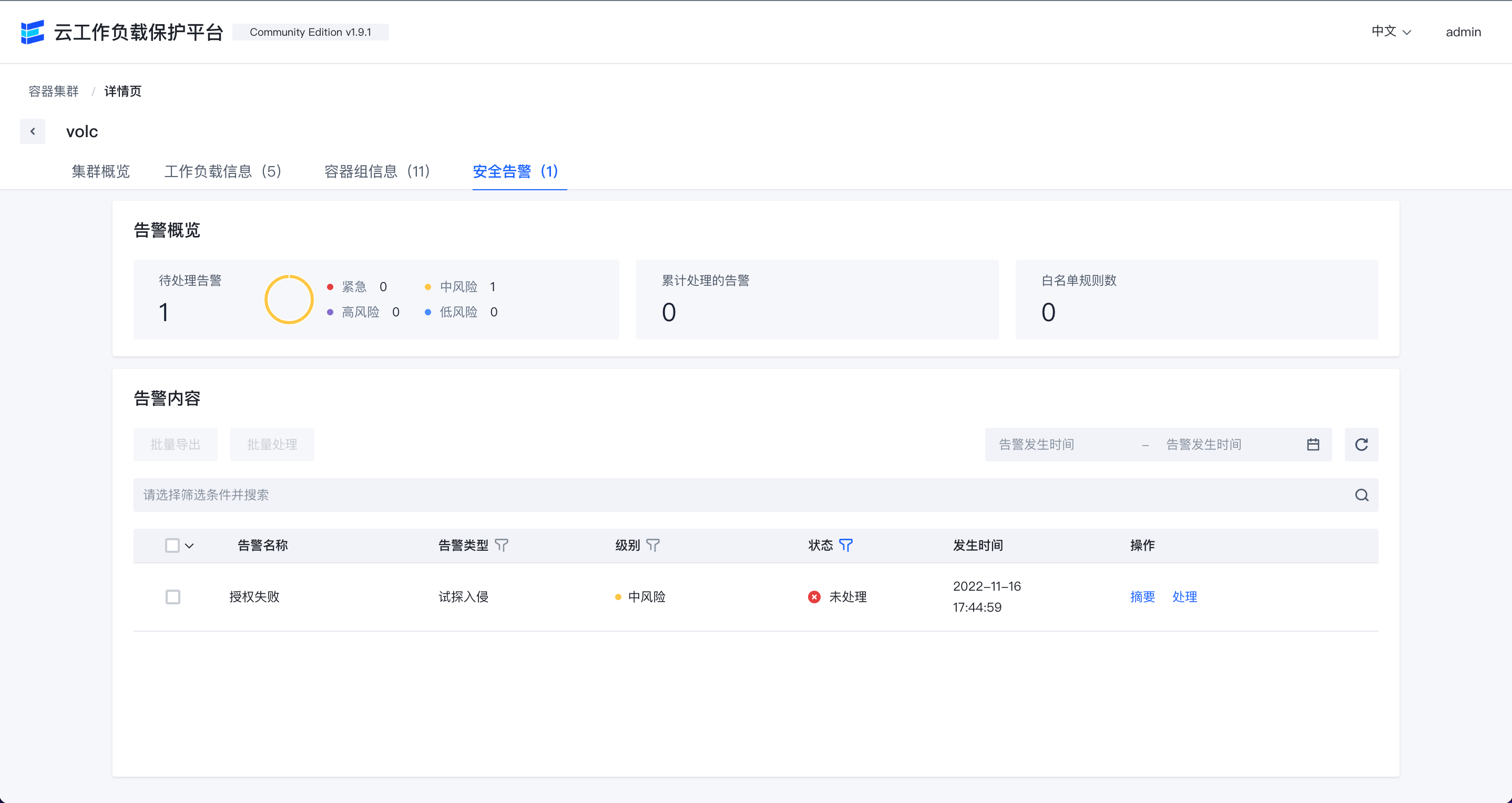

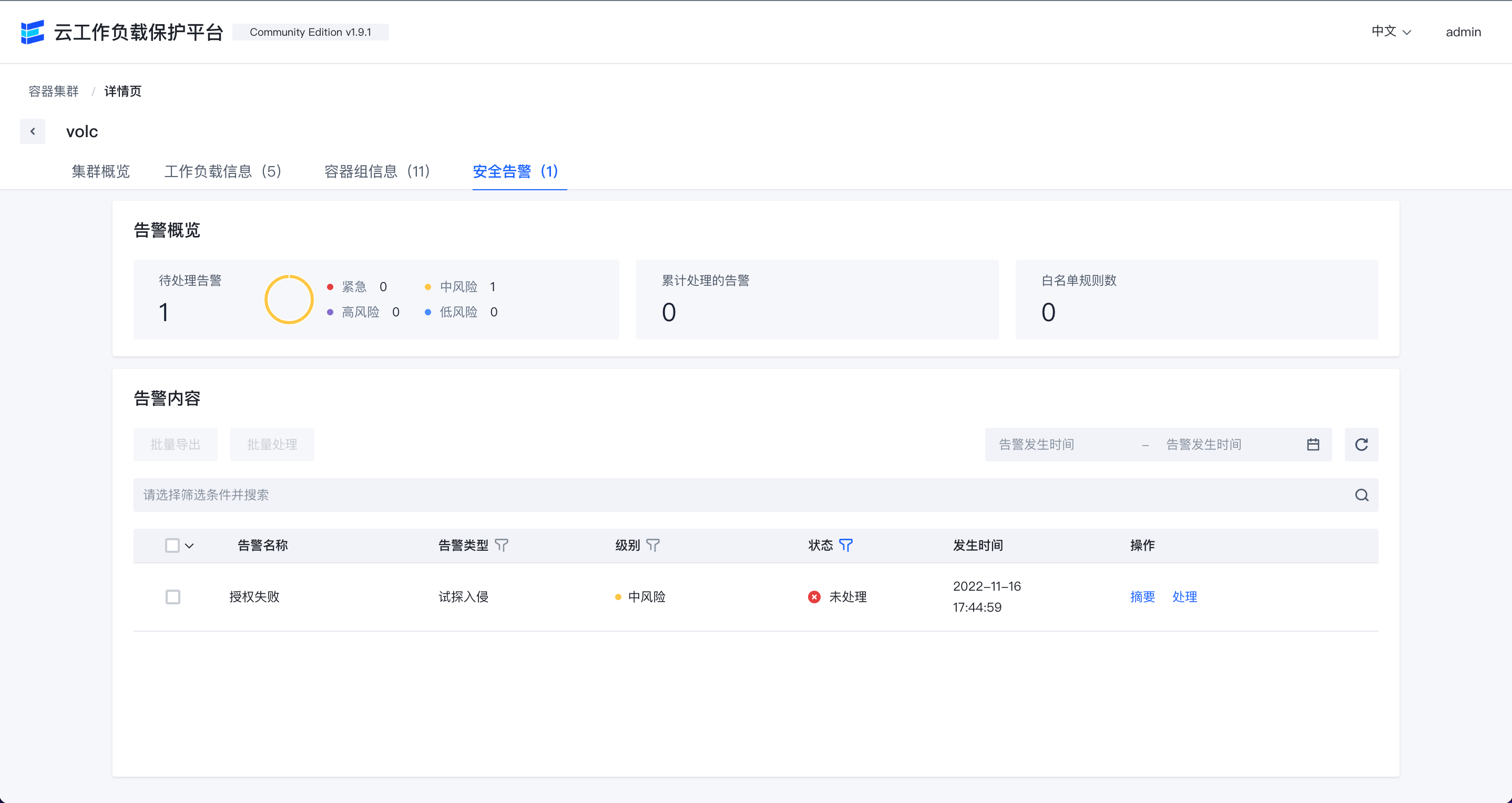

容器集群安全告警

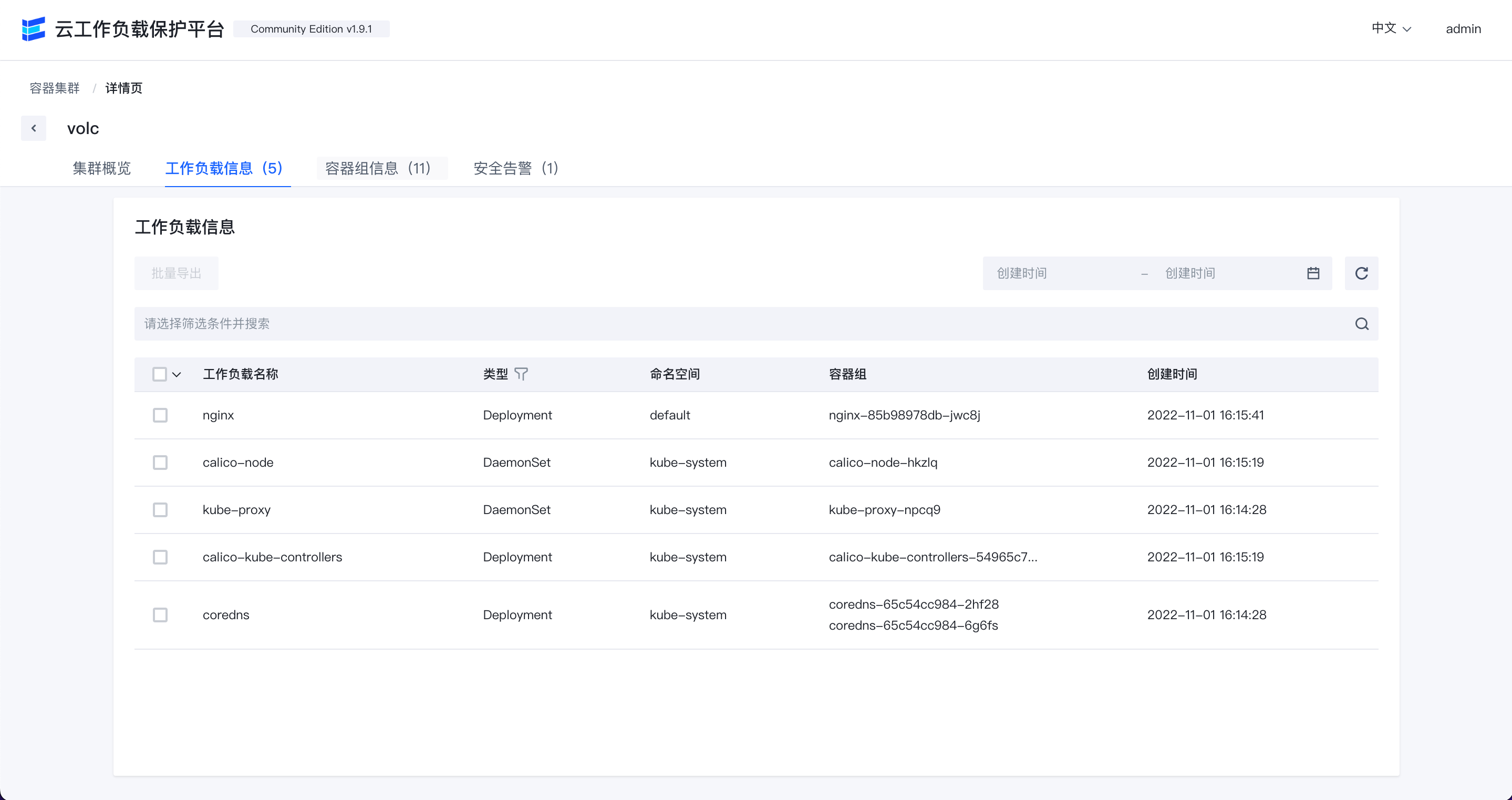

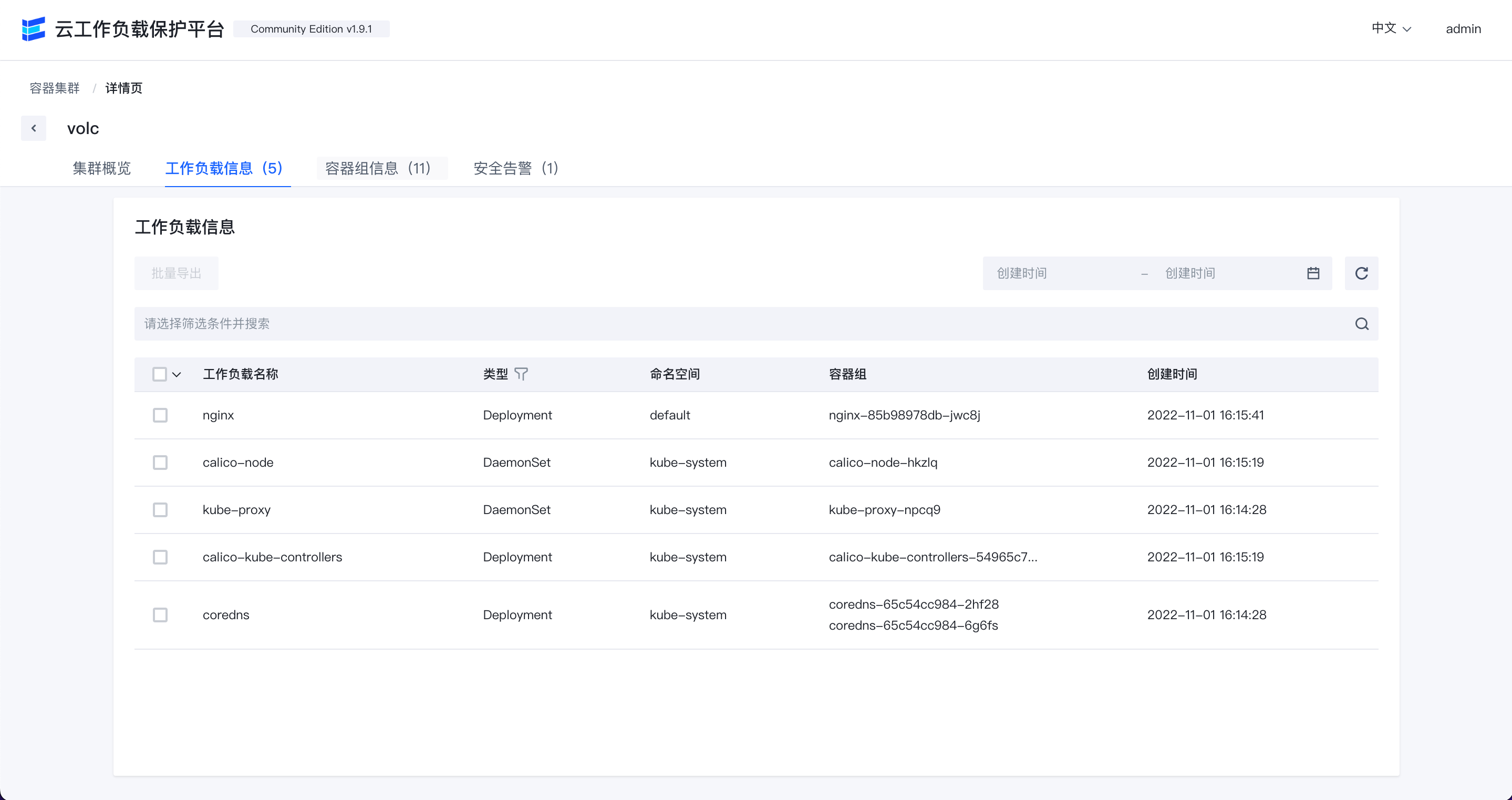

容器集群工作负载信息

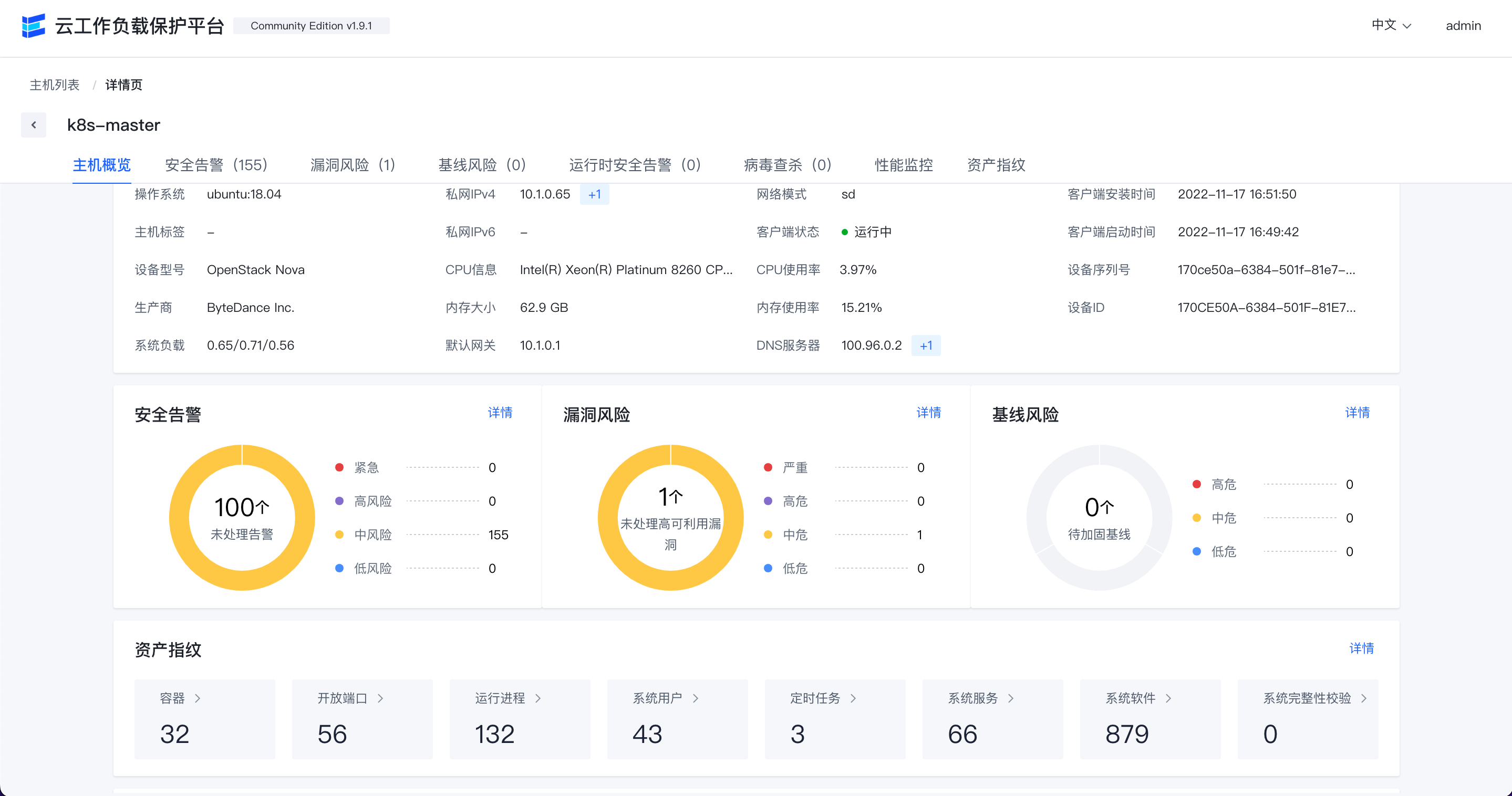

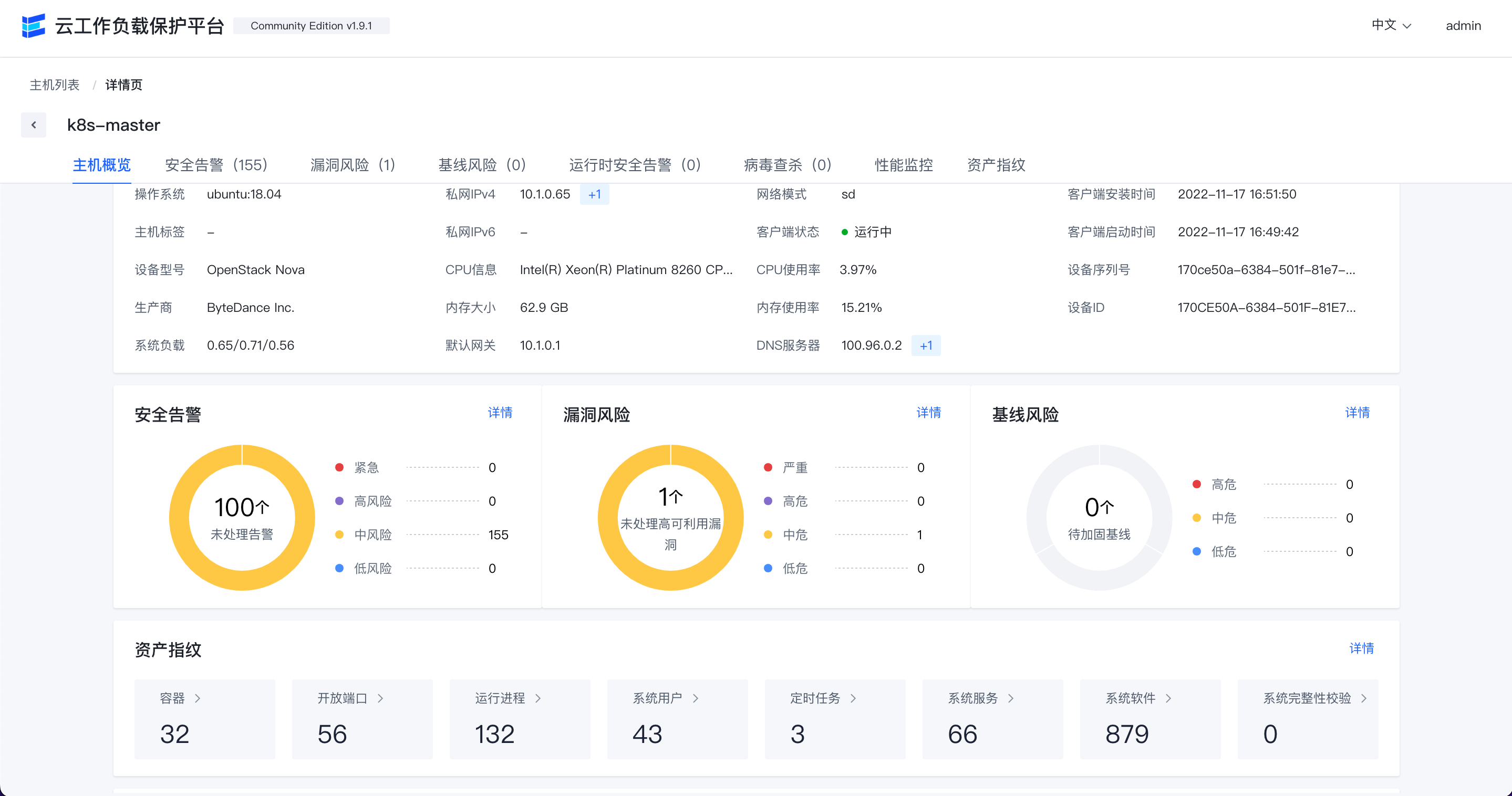

主机概览

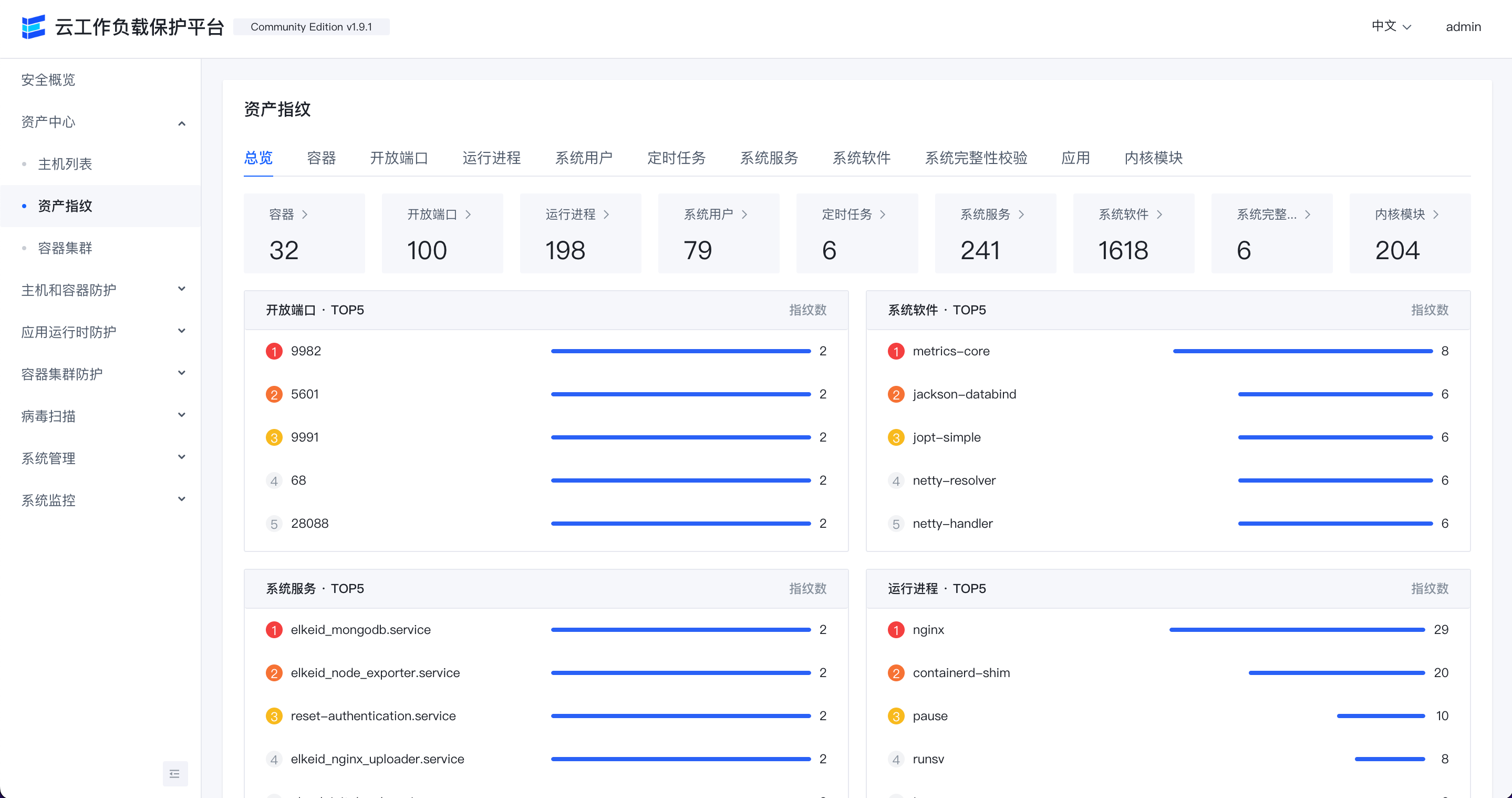

资产指纹

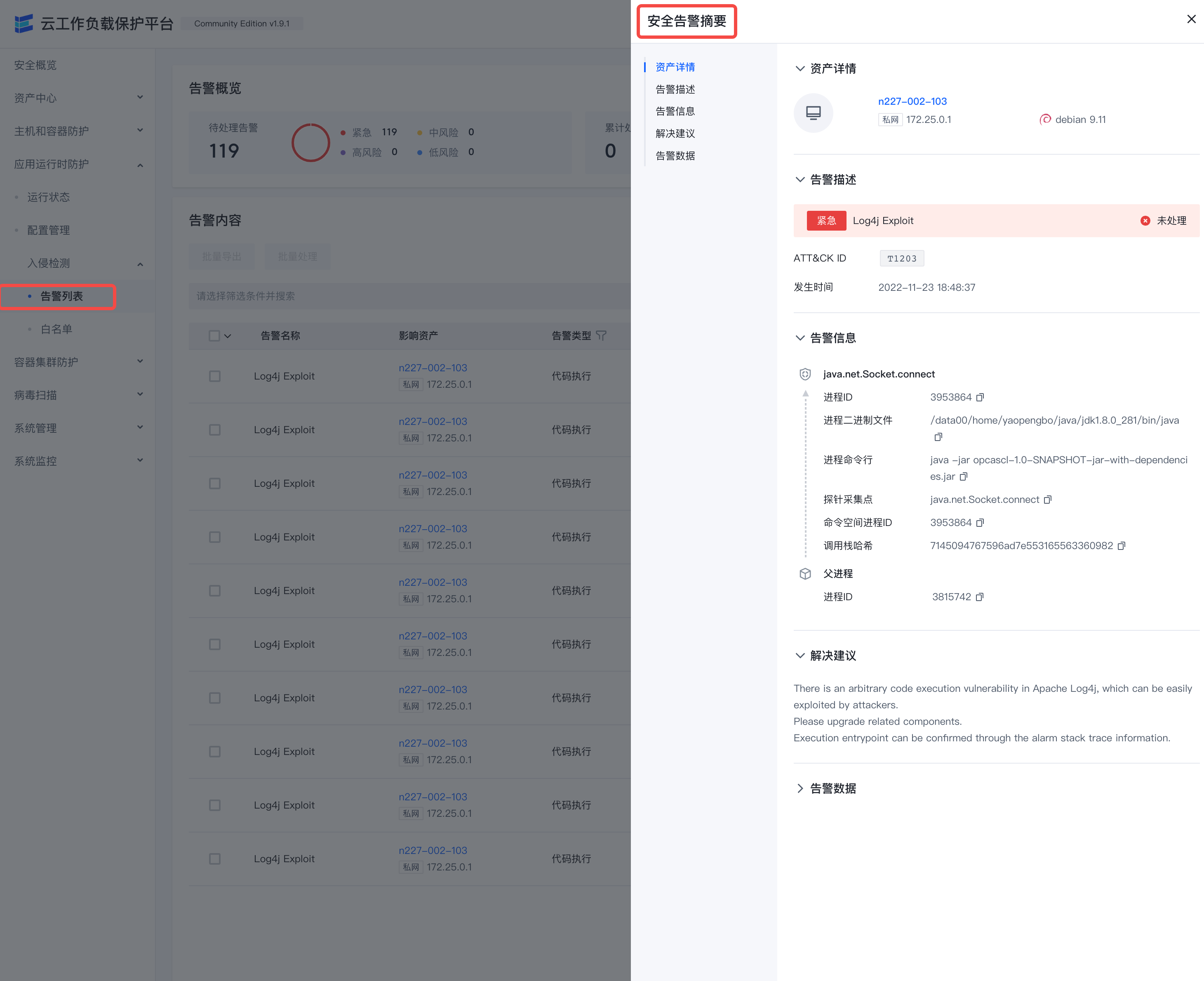

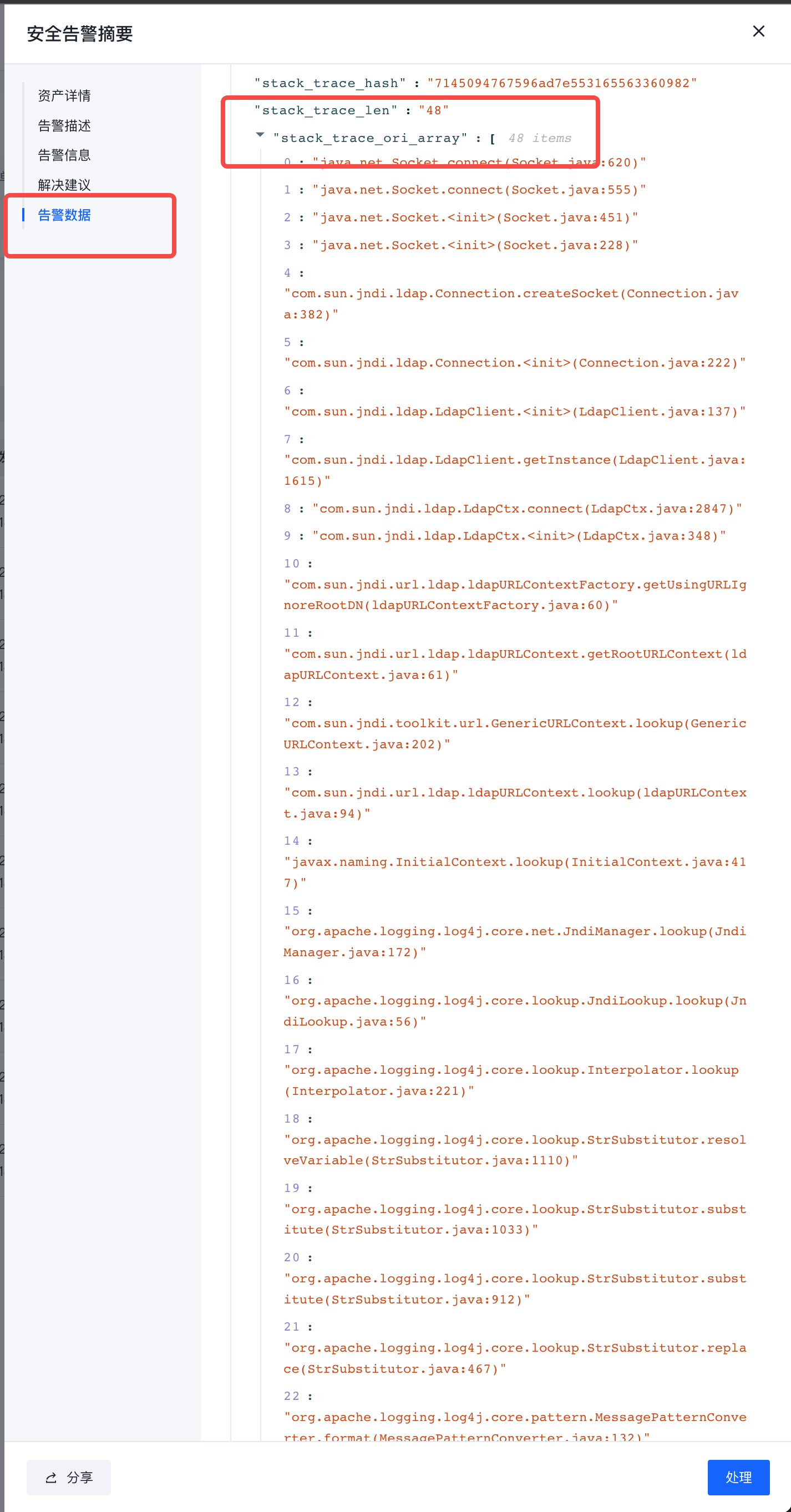

安全告警

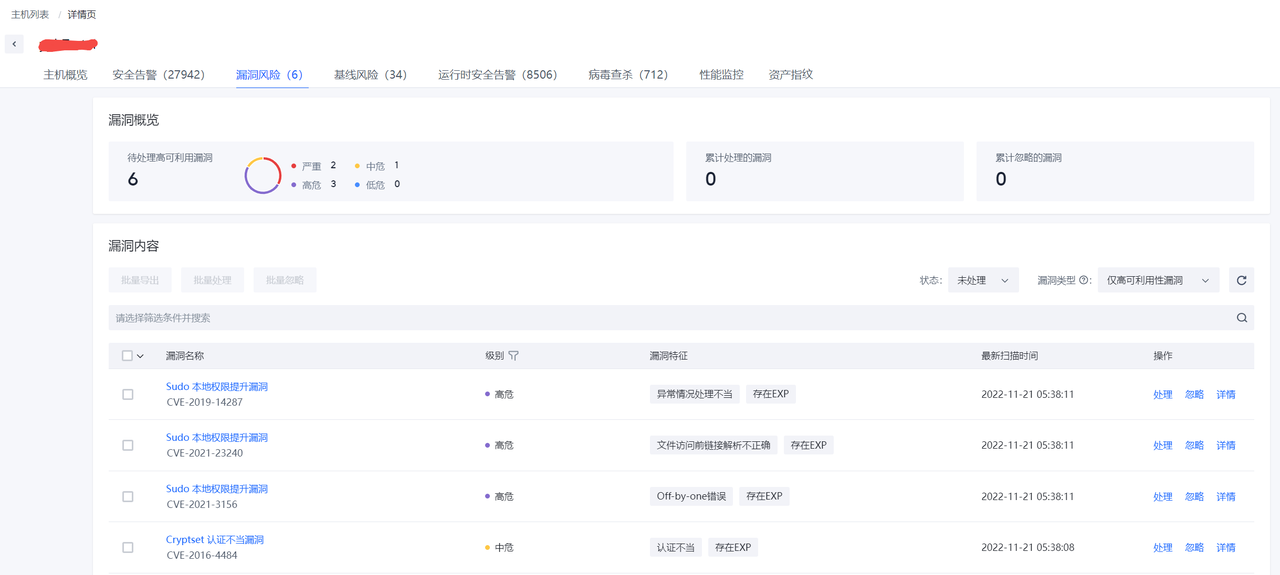

漏洞信息

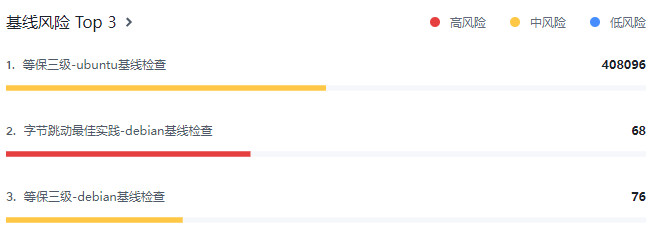

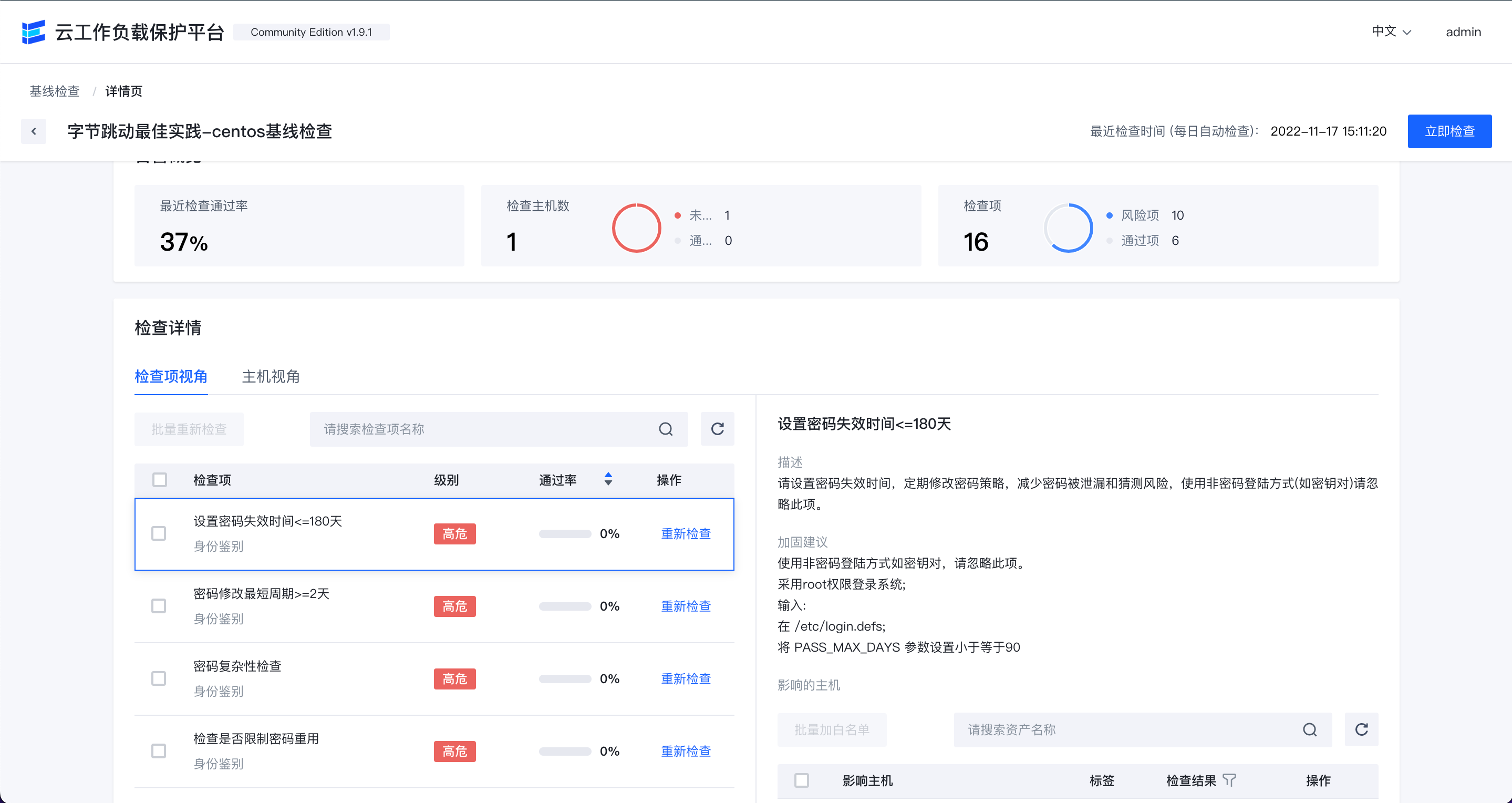

基线检查

病毒扫描

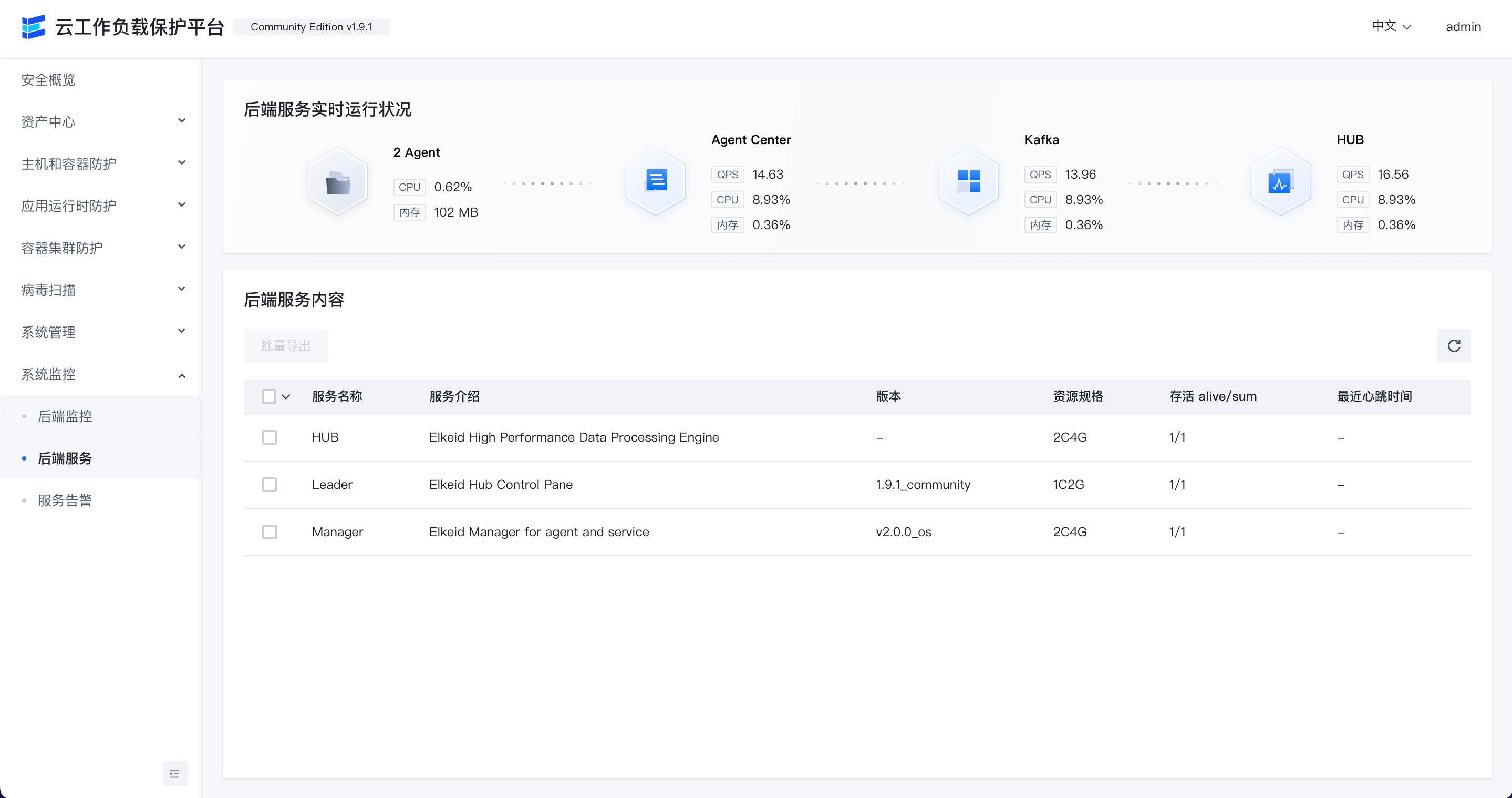

后端监控

后端服务监控

Console User Guide

Quick Start

Contact us && Cooperation

Lark Group

About Elkeid Enterprise Edition

Elkeid 企业版本支持单独策略售卖,也支持完全完整能力售卖。

如果对Elkeid企业版感兴趣请联系: elkeid@bytedance.com

Elkeid Docs

For more details and latest updates, see Elkeid docs.

License

- Elkeid Driver: GPLv2

- Elkeid RASP: Apache-2.0

- Elkeid Agent: Apache-2.0

- Elkeid Server: Apache-2.0

- Elkeid Console: Elkeid License

- Elkeid HUB: Elkeid License

404StarLink 2.0 - Galaxy

同时,Elkeid 也是 404Team 星链计划2.0中的一环,如果对星链计划感兴趣的小伙伴可以点击下方链接了解。 https://github.com/knownsec/404StarLink2.0-Galaxy

ElkeidUP

Elkeid 自动化部署工具

Component List

Instructions

- 部署所用的后端服务器需要仅供Elkeid使用

- 部署所用的后端服务器需要保证内网互通,也仅支持内网部署

- 部署所用的后端服务器部署时需要有 root 用户权限

- 部署所用的后端服务器只能使用:Centos7 及以上;Ubuntu16 及以上;Debian9 及以上

- 执行elkeidup的服务器需要能以root用户免密码ssh到所有的后端服务器上

- 部署过程不可以手动打断

- 仅可以使用局域网IP,不要使用 127.0.0.1 或者 hostname 或者公网IP

- 安装后不要删除

~/.elkeidup目录 - 不要修改任何组件的密码,包括Elkeid Console(Manager)初始默认用户

自动下载缺失预编译ko服务开启提示

服务背景: Elkeid Driver是在内核态工作的,由于内核要求加载的内核模块与内核版本强绑定,我们又无法占用客户机的资源在安装agent时在客户机上编译ko。因此,我们在release包中提供了预编译的ko,避免每次都需要手动编译ko,目前共计包含3435个预编译ko。但依旧存在两个问题无法解决,一是无法实时更新,上游发行版更新内核后,我们无法也没有人力同步更新预编译的ko到release中,二是覆盖范围有限,可能会遇见我们未曾使用过的发行版所使用的内核。为此,我们提供了自动下载缺失预编译ko的功能,此功能主要是通知到我们相关同学,该ko有客户在试用,尽快从上游更新或覆盖该发行版。 若您选择同意开启此服务,我们需要同时收集一些基础运行信息,以便我们根据不同需求的用户定制优先级排期,并给出合理的资源占用评估。填写的email信息仅用于区分来源身份,真实email或昵称均可。具体信息如下:

- 缺失预编译ko的内核版本,服务器架构(仅为arm64或amd64二选一,不涉及任何其他cpu机器信息)。

- agent center上agent的连接数,每30min收集一次。

- agent center上agent的qps,包含send和receive,每30min收集一次,取30min的平均值。

- hub input qps,每30min收集一次,取30min的平均值。

- redis qps,每30min收集一次,取30min的平均值。

- redis 内存占用,每30min收集一次,实时数值。

- kafka 生产和消费的qps,每30min收集一次,取30min的平均值。

- mongodb qps,每30min收集一次,取30min的平均值。

若您不同意开启此服务,您依旧可以使用release包中提供的预编译ko,其他功能不受影响。具体操作为在release界面下载ko_1.7.0.9.tar.xz,然后替换package/to_upload/agent/component/driver/ko.tar.xz,deploy期间会将ko解压到/elkeid/nginx/ElkeidAgent/agent/component/driver/ko目录中。相关收集信息和下载ko的代码均在已开源的manager代码中,是否开启相关功能取决于manager运行时conf目录下的elkeidup_config.yaml文件。若您在部署期间开启了此服务,但是需要在之后的流程中关闭,您可以将elkeidup_config.yaml文件中的report.enable_report设置为false,之后重启manager即可。

附:相关功能位于manager代码中的以下位置:

- 开关位于internal/monitor/report.go的InitReport()函数中,清空此函数内容,即可关闭功能入口。

- 收集信息项位于internal/monitor/report.go的heartbeatDefaultQuery结构中。

- 自动下载ko功能位于biz/handler/v6/ko.go的SendAgentDriverKoMissedMsg函数中。

Elkeid 完整部署(推荐)

Elkeid HUB 单独部署

Elkeid 升级和扩容

Raw Data Usage Tutorial

Elkeid 完整部署

1、单机docker快速部署 (单机测试环境推荐)

注:宿主机请优先使用centos 7.x 或 debian 9/10,容器内的服务依赖了systemd,而systemd使用了cgroup,容器内外systemd版本相差过大会导致容器内的systemd运行异常,无法启动相应服务。

1.1、导入镜像

# 从release下载的是分卷的镜像,需要先合并镜像

wget https://github.com/bytedance/Elkeid/releases/download/v1.9.1.4/elkeidup_image_v1.9.1.tar.gz.00

wget https://github.com/bytedance/Elkeid/releases/download/v1.9.1.4/elkeidup_image_v1.9.1.tar.gz.01

wget https://github.com/bytedance/Elkeid/releases/download/v1.9.1.4/elkeidup_image_v1.9.1.tar.gz.02

wget https://github.com/bytedance/Elkeid/releases/download/v1.9.1.4/elkeidup_image_v1.9.1.tar.gz.03

cat elkeidup_image_v1.9.1.tar.gz.* > elkeidup_image_v1.9.1.tar.gz

#导入镜像

docker load -i elkeidup_image_v1.9.1.tar.gz

1.2、运行容器

docker run -d --name elkeid_community \

--restart=unless-stopped \

-v /sys/fs/cgroup:/sys/fs/cgroup:ro \

-p 8071:8071 -p 8072:8072 -p 8080:8080 \

-p 8081:8081 -p 8082:8082 -p 8089:8080 -p 8090:8090\

--privileged \

elkeid/all-in-one:v1.9.1

1.3、设置对外IP

使用本机IP,不能使用127.0.0.1。

docker exec -it elkeid_community bash

cd /root/.elkeidup/

# 命令为交互式

./elkeidup public {ip}

./elkeidup agent init

./elkeidup agent build

./elkeidup agent policy create

cat ~/.elkeidup/elkeid_passwd

部署过程中遇到Elkeid社区版信息收集声明,请参考自动下载缺失预编译ko服务开启提示和Agent Install Remark

1.4、访问前端console并安装Agent

顺利安装完成后,/root/.elkeidup/elkeid_passwd文件记录了各组件的密码和相关的url。

初始密码在构建镜像的时候已经固定了的,为了安全性请不要用于生产环境

| 字段 | 说明 |

|---|---|

| elkeid_console | console账号密码 |

| elkeid_hub_frontend | hub前端账号密码 |

| grafana | grafana账号密码 |

| grafana | grafana 地址 |

| elkeid_hub_frontend | elkeid hub前端地址 |

| elkeid_console | elkeid console地址 |

| elkeid_service_discovery | 服务发现地址 |

访问elkeid_console,按照Console使用手册-安装配置 界面的命令进行Agent安装部署。

2、使用elkeidup进行完整部署

2.1、配置目标机器root用户ssh免密登录

如果部署机器为本机,依旧需要配置本机免密登录,登录耗时需要小于1s。 可用以下命令进行验证,两次date命令的输出结果需要相同。

date && ssh root@{ip} date

# 输出时间差小于1s

2.2、解压release产物并配置目录

- 下载release产物(分卷压缩包),并合并压缩包

wget https://github.com/bytedance/Elkeid/releases/download/v1.9.1.4/elkeidup_package_v1.9.1.tar.gz.00

wget https://github.com/bytedance/Elkeid/releases/download/v1.9.1.4/elkeidup_package_v1.9.1.tar.gz.01

wget https://github.com/bytedance/Elkeid/releases/download/v1.9.1.4/elkeidup_package_v1.9.1.tar.gz.02

cat elkeidup_package_v1.9.1.tar.gz.* > elkeidup_package_v1.9.1.tar.gz

也可以参考从源码构建 Elkeid,自行编译和构建package包。

如果之前安装过,请删除

/root/.elkeidup和/elkeid文件夹,避免造成干扰

- 解压release产物并配置目录

mkdir -p /root/.elkeidup && cd /root/.elkeidup

mv {DownloadDir}/elkeidup_package_v1.9.1.tar.gz elkeidup_package_v1.9.1.tar.gz

tar -xf elkeidup_package_v1.9.1.tar.gz

chmod a+x /root/.elkeidup/elkeidup

2.3、生成并修改config.yaml

ip为本机非127.0.0.1 ip,若不为单机部署,请参考资源手册修改config.yaml

cd /root/.elkeidup

./elkeidup init --host {ip}

mv config_example.yaml config.yaml

2.4、部署

cd /root/.elkeidup

# 命令为交互式

./elkeidup deploy

部署过程中遇到Elkeid社区版信息收集声明,请参考自动下载缺失预编译ko服务开启提示和Agent Install Remark

2.5、构建Agent

cd /root/.elkeidup

./elkeidup agent init

./elkeidup agent build

./elkeidup agent policy create

2.6、访问前端console并安装Agent

顺利安装完成后,执行cat /root/.elkeidup/elkeid_passwd将看到各组件的随机生成的密码和相关的url。

| 字段 | 说明 |

|---|---|

| elkeid_console | console账号密码 |

| elkeid_hub_frontend | hub前端账号密码 |

| grafana | grafana账号密码 |

| grafana | grafana 地址 |

| elkeid_hub_frontend | elkeid hub前端地址 |

| elkeid_console | elkeid console地址 |

| elkeid_service_discovery | 服务发现地址 |

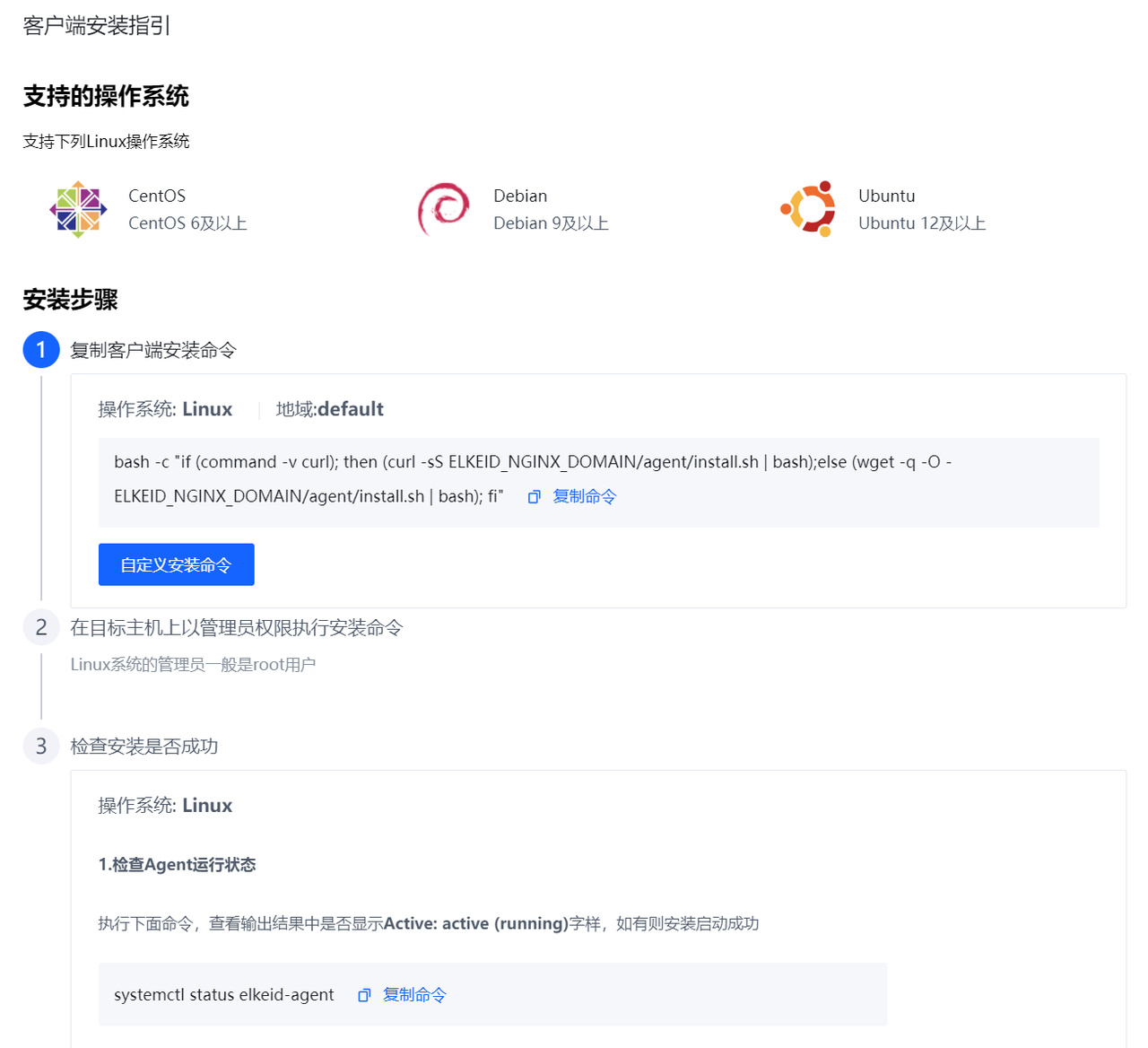

访问elkeid_console,按照Console使用手册-安装配置 界面的命令进行Agent安装部署。

3、Agent Install Remark

- Driver模块依赖预编译ko,具体支持列表参考:ko_list

- 正常情况下,在Agent安装完成后,需要10min左右Driver模块才能正常工作(涉及到KO自动下载和安装)。

- Driver是否存在的方式:

lsmod | grep hids_driver

3.1、ko导入Nginx方法

ko/sign文件的格式应该遵循:hids_driver_1.7.0.10_{uname -r}_{arch}.ko/sign格式, 文件需要放置在nginx对应服务器的:/elkeid/nginx/ElkeidAgent/agent/component/driver/ko下,并修改权限chown -R nginx:nginx /elkeid/nginx。放置完成后,重启Agent即可。

4、HTTPS配置

5、重装指定组件

如果部分组件有更新,或者重新编译了部分组件,可以使用elkeidup reinstall命令重新安装指定组件。 例如 release:v1.9.1.1 中更新了Hub社区版,可以使用以下命令进行重新安装。

# {v1.9.1.1} 为 v1.9.1.1 解压后的package目录

# reinstall hub

cp {v1.9.1.1}/package/hub/hub.tar.gz /root/.elkeidup/package/hub/hub.tar.gz

cp {v1.9.1.1}/package/hub_leader/hub_leader.tar.gz /root/.elkeidup/package/hub_leader/hub_leader.tar.gz

/root/.elkeidup/elkeidup reinstall --component Hub

/root/.elkeidup/elkeidup reinstall --component HubLeader

Elkeid HUB 单独部署

如果需要单独部署HUB,可以使用elkeidup中的--hub_only参数,具体步骤如下:

1、配置目标机器root用户ssh免密登录

如果部署机器为本机,依旧需要配置本机免密登录,登录耗时需要小于1s。 可用以下命令进行验证,两次date命令的输出结果需要相同。

date && ssh root@{ip} date

# 输出时间差小于1s

2、下载release产物并配置目录

mkdir -p /root/.elkeidup && cd /root/.elkeidup

wget https://github.com/bytedance/Elkeid/releases/download/v1.9.4/elkeidup_hub_v1.9.1.tar.gz -O elkeidup.tar.gz && tar -xf elkeidup.tar.gz

chmod a+x /root/.elkeidup/elkeidup

3、生成并修改config.yaml

ip为本机非 127.0.0.1 ip,若不为单机部署,请参考部署资源手册修改config.yaml

cd /root/.elkeidup

## 生成hub only 配置

./elkeidup init --host {ip} --hub_only

mv config_example.yaml config.yaml

4、部署

cd /root/.elkeidup

# 命令为交互式

./elkeidup deploy --hub_only

## status

./elkeidup status --hub_only

## undeploy

./elkeidup undeploy --hub_only

5、访问HUB前端

顺利安装完成后,执行cat /root/.elkeidup/elkeid_passwd将看到各组件的随机生成的密码和相关的url。

| 字段 | 说明 |

|---|---|

| elkeid_hub_frontend | hub前端账号密码 |

| grafana | grafana账号密码 |

| grafana | grafana 地址 |

| elkeid_hub_frontend | elkeid hub前端地址 |

| elkeid_service_discovery | 服务发现地址 |

访问 elkeid_hub_frontend,参照 Elkeid HUB 社区版快速上手教程 使用。

6、HTTPS配置

Elkeid CWPP v1.9.1 社区版 资源配置手册

版本

社区版v1.9.1

架构介绍

注:目前受社区版限制,Hub部分仅支持单机部署

组件详情

| 组件名称 | 测试环境下最小部署方式 | 生产环境建议部署方式 | 组件使用端口 | 说明 |

|---|---|---|---|---|

| Redis | 单台 | 三台,哨兵模式(仅支持3台,更大规模集群需要自行部署后替换) | 6379 26379 | 缓存数据库 |

| Mongodb | 单台 | 三台,副本集模式(仅支持3台,更大规模集群需要自行部署后替换) | 27017 9982 | 数据库 |

| Kafka | 单台 | 按Agent量进行计算(自动化部署情况下仅支持3台,多台需要自行部署后替换) | 2181 9092 12888 13888 | 消息通道 |

| Nginx | 单台 | 单台或多台均可,下载功能建议使用内部CDN,若需要外部接入,建议使用自建LB | 8080 8081 8082 8071 8072 8089 8090 | 文件服务器及反向代理 |

| Service Discovery | 单台 | 两至三台 | 8088 | 服务发现 |

| HUB | 单台 | 社区版仅支持单台(生产环境是否使用社区版,请进行额外评估) | 8091 8092 | 规则引擎 |

| HUB Leader | 单台 | 社区版仅支持单台(生产环境是否使用社区版,请进行额外评估) | 12310 12311 | 规则引擎集群控制层 |

| HIDS Manager | 单台 | 两至三台 | 6701 | HIDS控制层 |

| Agent Center | 单台 | 按Agent量进行计算 | 6751 6752 6753 | HIDS接入层 |

| Prometheus | 单台 | 单台或两台均可 | 9090 9993 9994 9981 9983 9984 | 监控用数据库 |

| Prometheus Alermanager | 与Prometheus共用服务器 | - | ||

| Grafana | 单台 | 单台 | 8083 | 监控面板 |

| Kibana | 单台 | 单台 | 5601 | ES面板 |

| NodeExporter | 不需指定单独的服务器,所有机器都需要部署该监控服务 | - | 9990 | 监控探针 |

| ProcessExporter | 不需指定单独的服务器,所有机器都需要部署该监控服务 | - | 9991 | 监控探针 |

配置文件说明

- ssh_host 为通用配置,表示该组件在哪些机器上进行部署,若为数组类型,说明该组件支持集群部署,否则只支持单机部署,具体限制见配置文件注释。

- quota为通用配置,最终会转变为cgroup限制。

- 单机测试环境下,所有机器都填同一地址即可。

# redis 单台或3台,3台时为哨兵模式

redis:

install: true

quota: 1C2G

ssh_host:

- redis-1

- redis-2

- redis-3

# MongoDB 单台或3台,3台时为副本集模式

mongodb:

install: true

quota: 2C4G

ssh_host:

- monogo-1

- monogo-2

- monogo-3

# MongoDB 单台或3台,3台时为进群模式

kafka:

install: true

topic: hids_svr

partition_num: 12 # 默认单topic分区数

quota: 2C4G

ssh_host:

- kafka-1

- kafka-2

- kafka-3

# leader 社区版目前仅支持单机模式

leader:

install: true

quota: 1C2G

ssh_host: leader-1

# nginx 单台多台即可,但其他组件默认只会使用第一台

nginx:

install: true

quota: 1C2G

ssh_host:

- nginx-1

- nginx-2

domain: # 指向nginx机器的域名,仅支持单个

public_addr: # nginx机器的公网IP,仅支持单个

# sd 单台多台即可

service_discovery:

install: true

quota: 1C2G

ssh_host:

- sd-1

- sd-2

# hub 社区版目前仅支持单机模式

hub:

install: true

quota: 2C4G

ssh_host: hub-1

# manager 单台多台即可

manager:

install: true

quota: 2C4G

ssh_host:

- manager-1

# ac 单台多台即可

agent_center:

install: true

grpc_conn_limit: 1500 # 单个AC的最大连接数限制

quota: 1C2G

ssh_host:

- ac-1

# prometheus 单台多台即可,默认只会请求第一台,第二台处于双写状态,不会被查询

prometheus:

quota: 1C2G

ssh_host:

- prometheus-1

# grafana 仅支持一台

grafana:

quota: 1C2G

ssh_host: grafana-1

从源码构建 Elkeid CWPP

当前社区版本中,部分组件尚未开源,主要是Elkeidup和Hub的相关组件目前仅能提供社区版二进制,所以无法提供从零到一提供完全从源码构建的构建手册。您可以通过在安装前替换package中的指定文件,或安装后替换可执行程序的方式,达到运行从源码构建的可执行程序的效果。具体文件位置和对应关系说明如下。

安装前替换

Agent

Agent部分在elkeidup deploy过程中会从源码build,所以替换package中的以下文件即可,建议解压该文件,确认该文件与目录结构与替换前的文件相同。

package/agent/v1.9.1/agent/elkeid-agent-src_1.7.0.24.tar.gz

Driver Plugin

Driver plugin同样会在elkeidup deploy过程中会从源码build,所以同样替换package中的以下文件即可,建议解压该文件,确认该文件与目录结构与替换前的文件相同。

package/agent/v1.9.1/driver/driver-src_1.0.0.15.tar.gz

其他agent plugin

其他agent plugin都是预编译好的,按照各plugin的文档,编译好后替换对应的文件即可。注意plugin存在plg格式和tar.gz格式,plg格式为可执行文件,tar.gz为压缩包。版本号目前写死在elkeidup中,需要保持一致,请勿更改。

package/agent/v1.9.1/driver/driver-src_1.0.0.15.tar.gz

package/agent/v1.9.1/baseline/baseline-default-aarch64-1.0.1.23.tar.gz

package/agent/v1.9.1/baseline/baseline-default-x86_64-1.0.1.23.tar.gz

package/agent/v1.9.1/collector/collector-default-aarch64-1.0.0.140.plg

package/agent/v1.9.1/collector/collector-default-x86_64-1.0.0.140.plg

package/agent/v1.9.1/etrace/etrace-default-x86_64-1.0.0.92.tar.gz

package/agent/v1.9.1/journal_watcher/journal_watcher-default-aarch64-1.0.0.23.plg

package/agent/v1.9.1/journal_watcher/journal_watcher-default-x86_64-1.0.0.23.plg

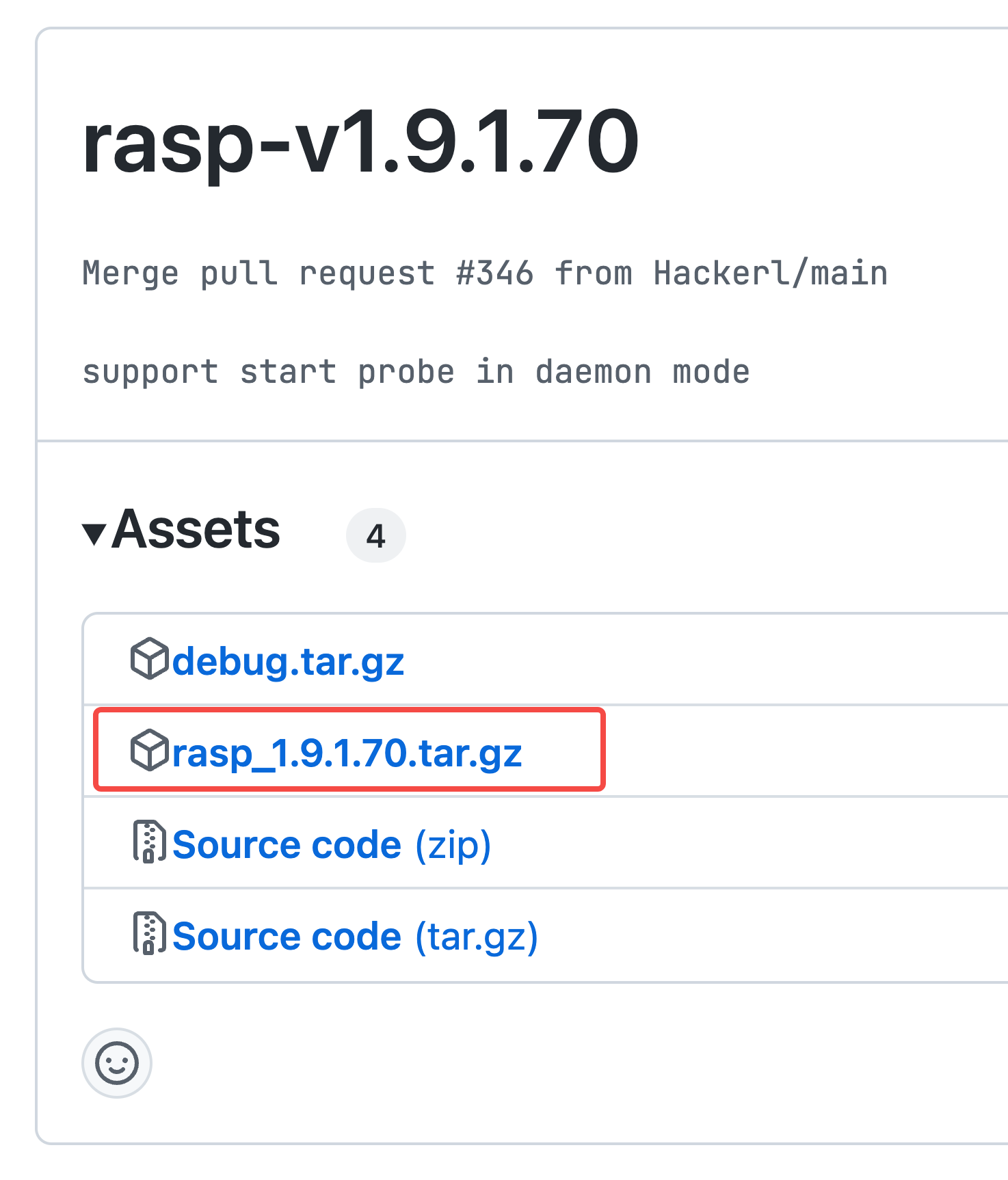

package/agent/v1.9.1/rasp/rasp-default-x86_64-1.9.1.44.tar.gz

package/agent/v1.9.1/scanner/scanner-default-aarch64-3.1.9.6.tar.gz

package/agent/v1.9.1/scanner/scanner-default-x86_64-3.1.9.6.tar.gz

ko

默认deploy时不会降预编译的ko拷贝到nginx中,在release界面同时会提供预编译的ko,下载预编译的ko或自行编译ko后,替换以下文件即可,文件为tar.xz格式,解压后有一个ko文件夹,格式必须相同。

package/to_upload/agent/component/driver/ko.tar.xz

Manager & ServiceDiscovery & AgentCenter

编译好对应的二进制,解压以下路径的tar.gz,然后替换好二进制后打包回tar.gz即可。

# manager

package/manager/bin.tar.gz

# service discovery

package/service_discovery/bin.tar.gz

# agent center

package/agent_center/bin.tar.gz

安装后替换

Agent 相关

Agent部分均可以通过前端上传,具体见agent发布文档

ko

拷贝对应ko和sing文件到以下目录即可,之后执行命令修改目录权限

# ko 目录

/elkeid/nginx/ElkeidAgent/agent/component/driver/ko

# 修改权限

chown -R nginx:nginx /elkeid/nginx

Manager & ServiceDiscovery & AgentCenter

暂停服务,替换对应的二进制文件,然后重启服务

# manager

systemctl stop elkeid_manager

mv new_manager_bin /elkeid/manager/manager

systemctl start elkeid_manager

# service discovery

systemctl stop elkeid_sd

mv new_sd_bin /elkeid/service_discovery/sd

systemctl start elkeid_sd

# agent center

systemctl stop elkeid_ac

mv new_ac_bin /elkeid/agent_center/agent_center

systemctl start elkeid_ac

Elkeidup 社区版升级指南 1.7.1 --> 1.9.1

前言

首先需要配置elkeidup 1.7.1 与 1.9.1 版本共存,然后按情况进行切换。

详细操作请同时参照1.7.1 与 1.9.1 的文档。

# rename .elkeidup dir

cd /root

mv .elkeidup .elkeidup_v1.7.1

ln -s .elkeidup_v1.7.1 .elkeidup

# copy cert to v1.9.1

mkdir -p /root/.elkeidup_v1.9.1

cp -r /root/.elkeidup_v1.7.1/elkeid_password /root/.elkeidup_v1.9.1

cp -r /root/.elkeidup_v1.7.1/cert /root/.elkeidup_v1.9.1

# download v1.9.1 package to /root/.elkeidup_v1.9.1

切换到 1.7.1

rm /root/.elkeidup && ln -s /root/.elkeidup_v1.7.1 /root/.elkeidup

切换到 1.9.1

rm /root/.elkeidup && ln -s /root/.elkeidup_v1.9.1 /root/.elkeidup

后端

v1.9.1后端目前无法与v1.7.1兼容,需要卸载v1.7.1后端后重新安装v1.9.1。

备份数据

根据需要选择备份数据:

- 备份 MongoDB:目录位于 /elkeid/mongodb 仅是备份DB,备份的数据无法直接使用,如果有恢复需求,目前尚无自动化脚本,需要手动转换。

- 备份Hub策略:目录位于 /elkeid/hub 策略可以在Hub web界面中进行导入。

卸载v1.7.1

在卸载v1.7.1后端后,Agent将在1min后自动关闭所有插件,并进入守护状态,直到新的后端被安装

# 按照前言操作切换到 v1.7.1

cd /root/.elkeidup

./elkeidup undeploy

安装v1.9.1

在安装v1.9.1后端后,Agent将在1min内重连,但此时还尚未加载任何插件,您可以在Console上看到这个状态

# 按照前言操作切换到 v1.9.1

# 安装文档详见v1.9.1 安装文档

cd /root/.elkeidup

./elkeidup deploy

Agent

确认配置及状态

-

/root/.elkeidup_v1.7.1/cert/root/.elkeidup_v1.9.1/cert两个目录内的所有文件内容均保持一致 -

/root/.elkeidup_v1.7.1/elkeid_server.yaml/root/.elkeidup_v1.9.1/elkeidup_config.yaml两个文件中,下述相关配置均保持一致。-

注:具体字段filed值以

v1.9.1为准,请勿直接覆盖。 -

nginx

- domain

- ssh_host

- public_addr

-

mg

- ssh_host

-

-

确认后端更新完成后,所有v1.7.1的Agent均已成功上线

Build v1.9.1组件

./elkeidup agent init

./elkeidup agent build

./elkeidup agent policy create

下发任务

可根据需要进行灰度升级,此时新上线/重连的客户端会自动拉取最新配置升级,其他客户端需要手动同步配置升级

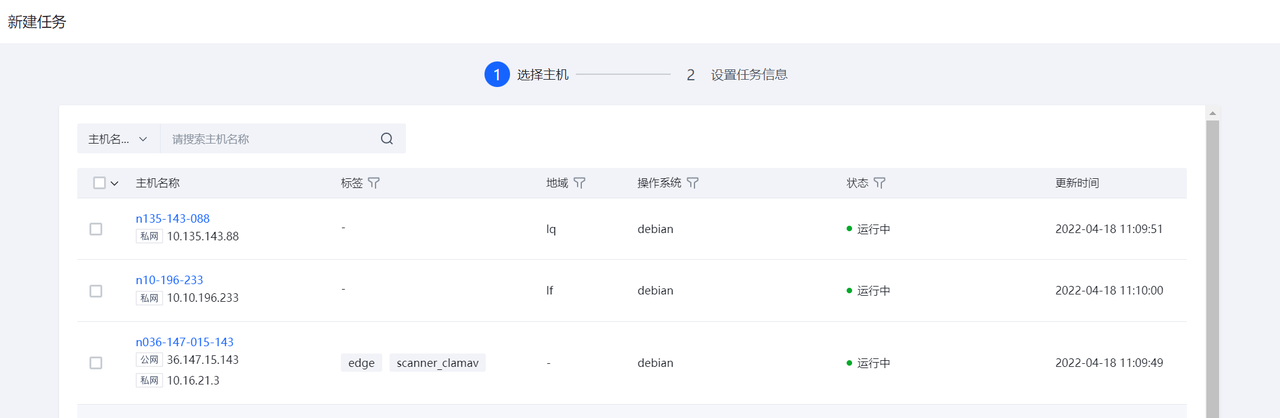

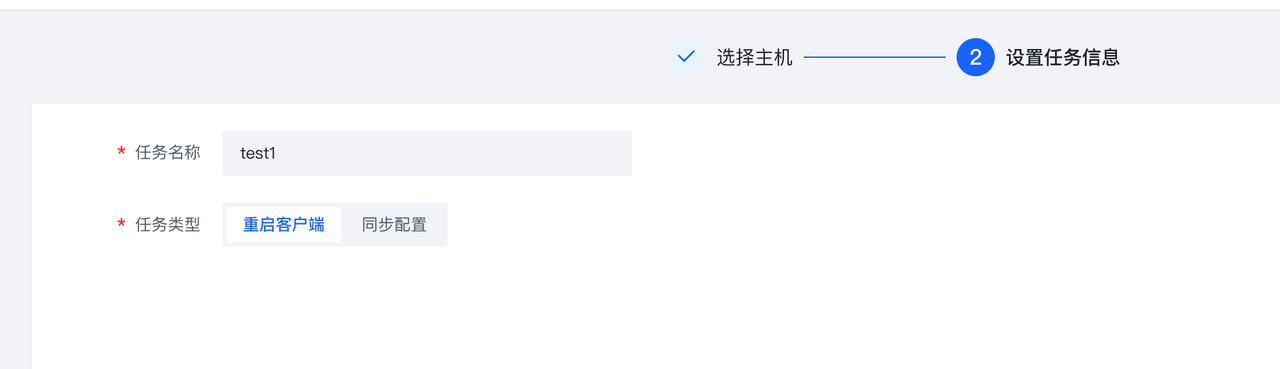

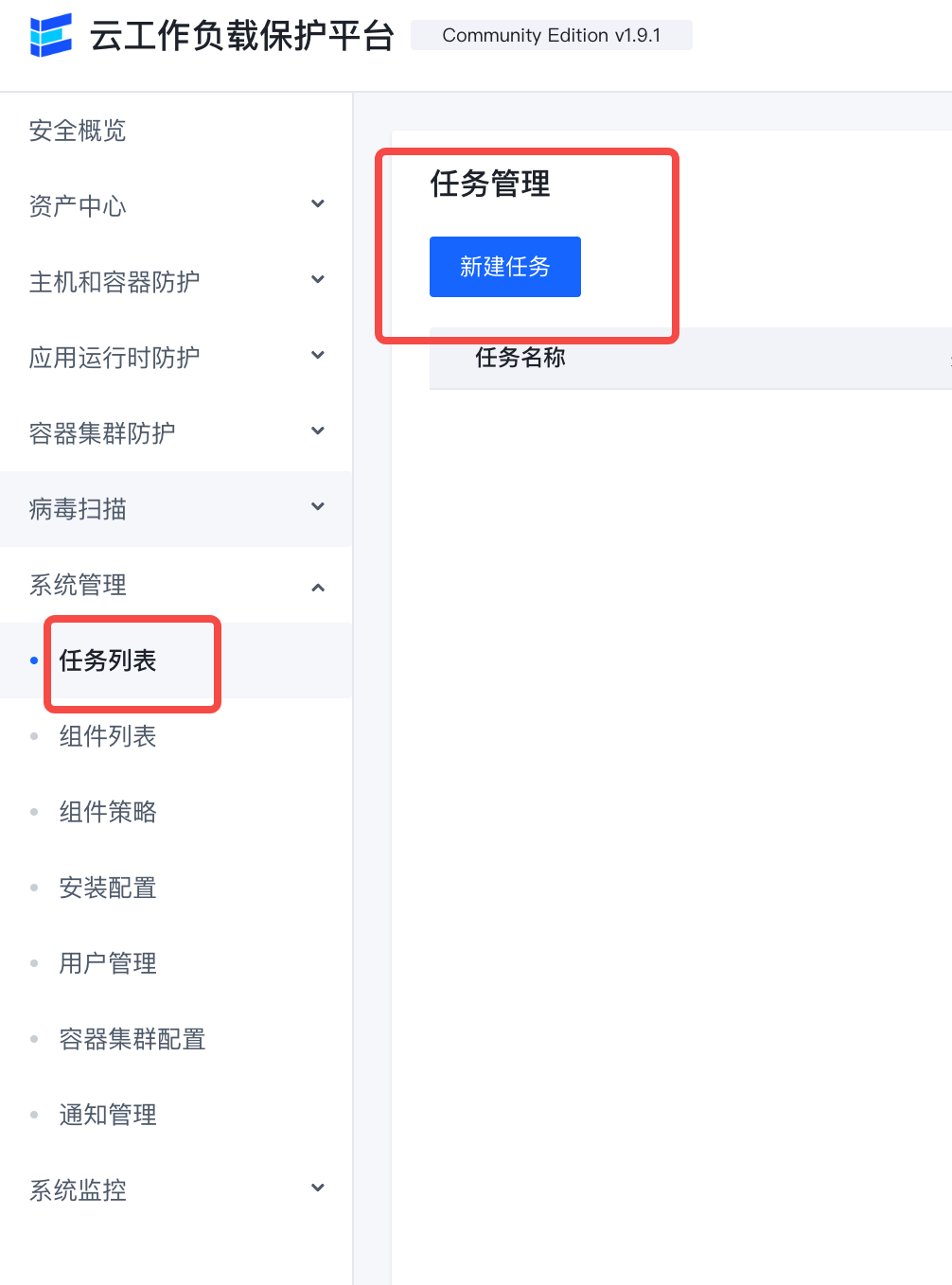

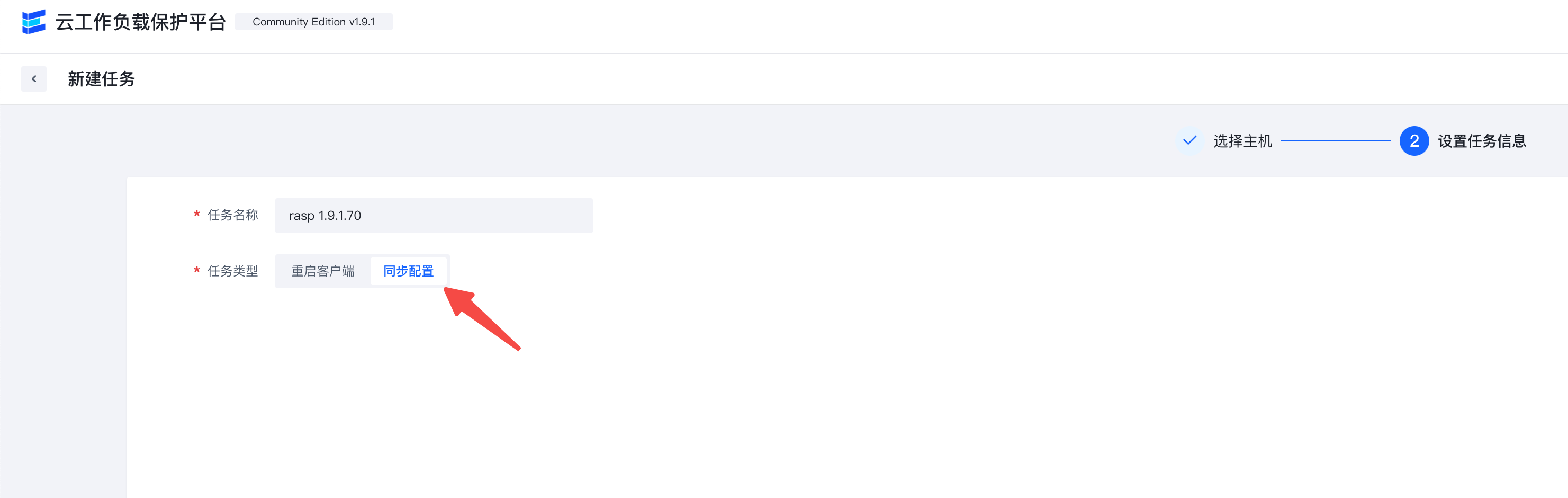

- 在 Elkeid Console - 任务管理 界面,点击“新建任务”,选择单台主机,点击下一步,选择“同步配置”任务类型,点击确认。随后,在此页面找到刚刚创建的任务,点击运行,观察升级后的主机是否符合预期。

- 在 Elkeid Console - 任务管理 界面,点击“新建任务”,选择全部主机,点击下一步,选择“同步配置”任务类型,点击确认。随后,在此页面找到刚刚创建的任务,点击运行,即可对存量旧版本Agent进行升级。

Elkeid 社区版 扩容指南

ServiceDiscovery

自身扩容(依赖elkeidup)

- 修改config.yaml 在sd中添加其他的host,登录条件与安装时相同。

- 执行以下命令 elkeidup reinstall --component ServiceDiscovery --re-init

自身扩容(手动操作)

- 拷贝已安装好SD机器的 /elkeid/service_discovery 到待扩容机器上。

- 更新全部SD的配置文件 /elkeid/service_discovery/conf/conf.yaml 的 Cluster.Members项,该项为所有sd实例的数组,每台sd都要填写全部实例的地址。

- 执行新SD实例的 /elkeid/service_discovery/install.sh ,会自动启动sd。

- 重启所有旧的sd实例

systemctl restart elkeid_sd。

同步修改上下游配置

sd目前同时被AgentCenter,Manager和Nginx所依赖,扩容SD后,需要同步重启。

- AgentCenter: 配置文件位于/elkeid/agent_center/conf/svr.yml 的 sd.addrs,重启命令

systemctl restart elkeid_ac。 - Manager: 配置文件位于/elkeid/manager/conf/svr.yml 的 sd.addrs,重启命令

systemctl restart elkeid_manager。 - Nginx: 配置文件位于/elkeid/nginx/nginx/nginx.conf 的 upstream sd_list,重启命令

systemctl restart elkeid_nginx。

AgentCenter

自身扩容(依赖elkeidup)

- 修改config.yaml 在ac中添加其他的host,登录条件与安装时相同。

- 执行以下命令 elkeidup reinstall --component AgentCenter --re-init

自身扩容(手动操作)

- 拷贝已安装好AC机器的 /elkeid/agent_center 到待扩容机器上。

- 执行新AC实例的 /elkeid/agent_center/install.sh ,会自动安装和启动AC。

同步修改上下游配置

若agent通过服务发现的方式连接到AC,则不需要手动同步上下游配置。

若agent通过编码的AC地址连接AC,需要重新编译agent,将新的AC地址加入到agent连接配置中。

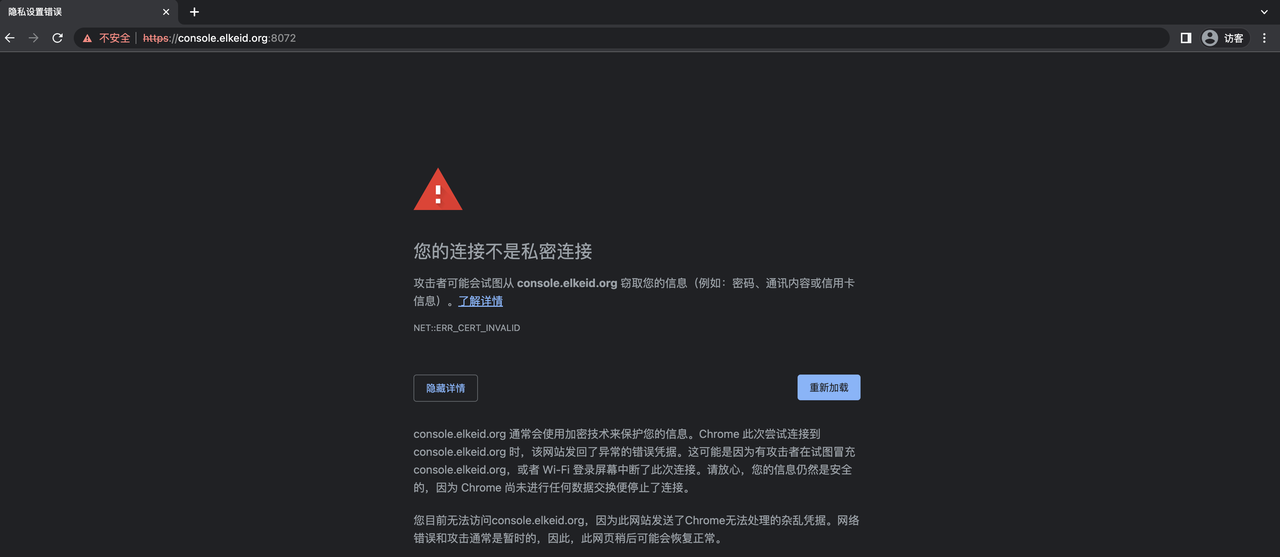

Elkeid https configuration documentation

1. Overview

- By default, the Elkeid Console listens on ports 8082 and 8072, and the Elkeid HUB listens on ports 8081 and 8071.

- If HTTPS is required, ports 8072 and 8071 can be used for access.

| Elkeid Console | Elkeid HUB Console | |

|---|---|---|

| HTTP | http://{{NignxIP}}:8082 | http://{{NignxIP}}:8081 |

| HTTPS | https://{{NignxIP}}:8072 | https://{{NignxIP}}:8072 |

2. Use an internal enterprise certificate

The self-signed certificate generated during installation is located in the '/elkeid/nginx/nginx' directory on the machine where nginx is located, and includes the following two files:

server.key

server.crt

After replacing the above two files, do the following:

chown -R nginx: nginx /elkeid/nginx

systemctl restart elkeid_nginx

3. Use the self-signed certificate generated at deployment time

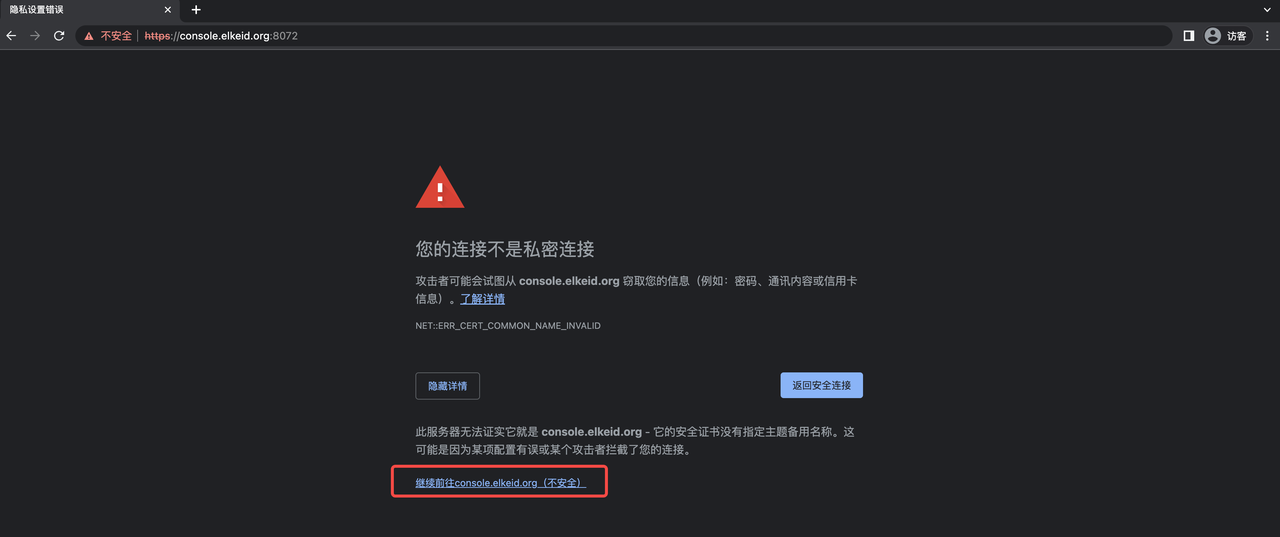

When Elkeid is deployed, it can only use a self-signed certificate. Due to the security settings of chrome, it cannot be accessed directly. All you need to manually trust the certificate to access it using https. The specific operation is as follows:

The following example hypotheses that the server where nginx is located is console.elkeid.org and has a configuration of /etc/hosts or dns parsing.

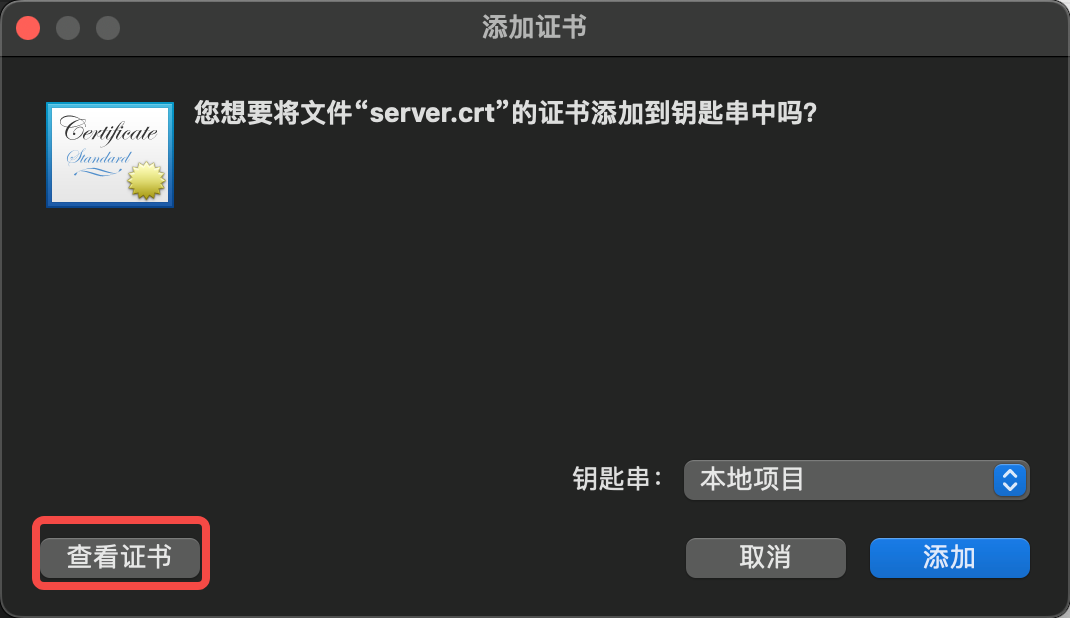

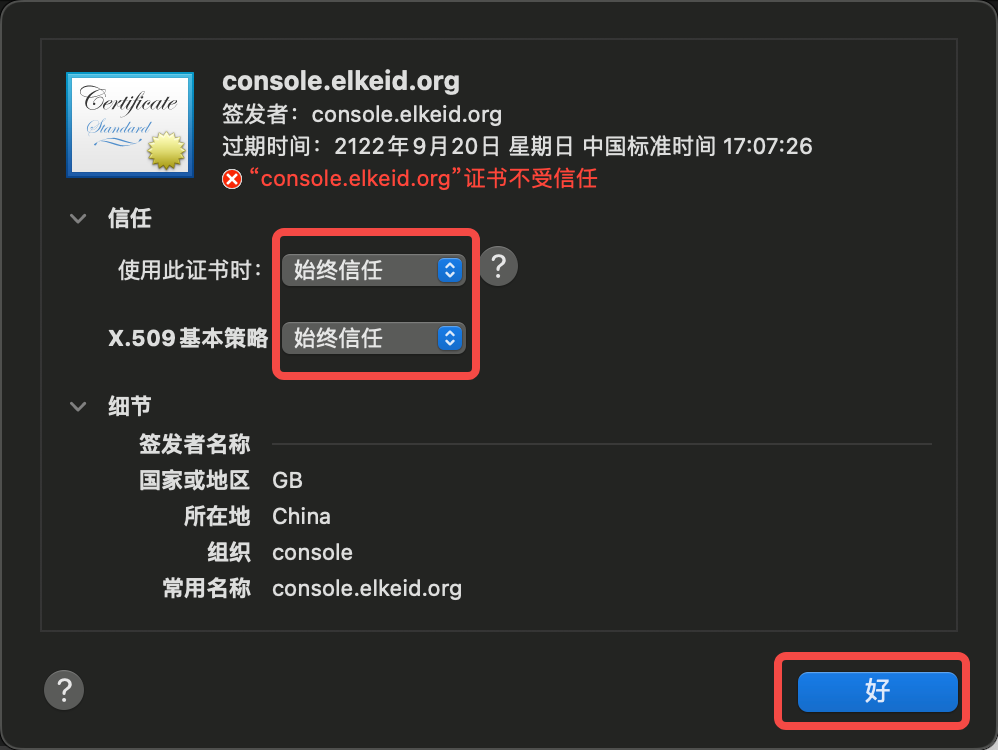

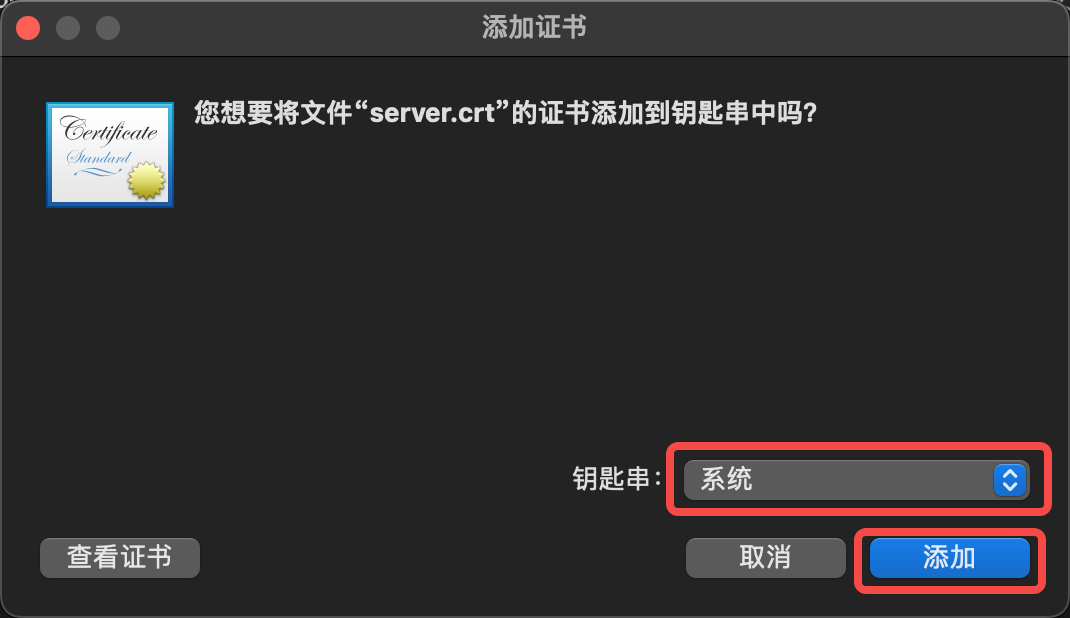

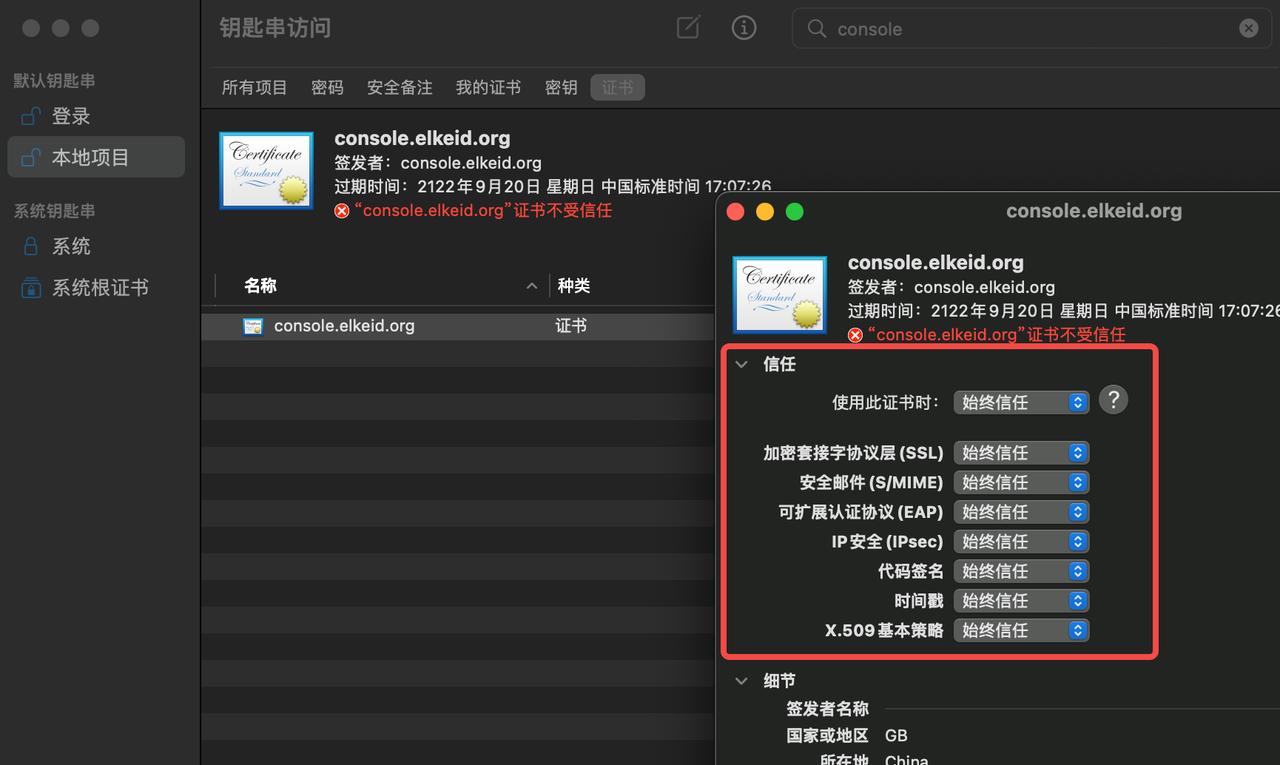

3.1, Macos

- Access https://console.elkeid.org:8072/ Export Certificate

- Import the exported certificate and trust it

- Click Keychain Access, Trust Certificate

- Visit https://console.elkeid.org:8072/ again

Elkeid Console 主机安全保护平台使用手册

版本

社区版v1.9.1

安全概览

通过安全概览能快速了解覆盖范围,告警势态,运营情况(安全告警与安全风险处置情况)等的整体安全态势。

资产概览

查看当前在覆盖的主机和容器集群信息。

入侵告警

展示未处理告警的数量以及最近7天内的变化趋势。

漏洞风险

展示未处理漏洞的数量以及最近7天内的变化趋势。

基线风险

展示TOP3的基线风险数量。

主机风险分布

展示当前存在待处理告警、高可利用漏洞和基线风险的主机占比。

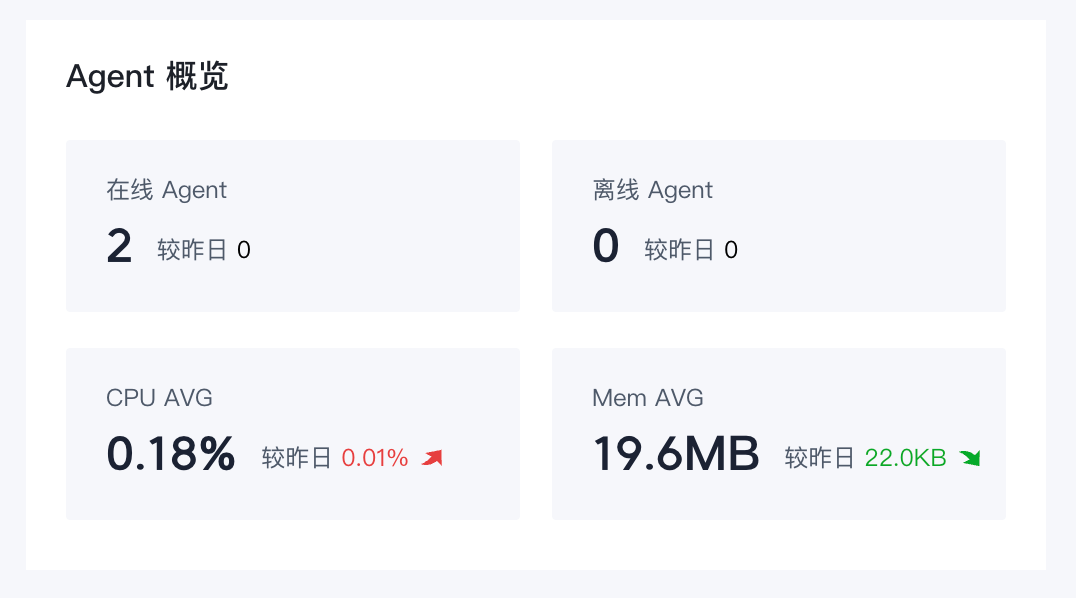

Agent 概览

展示Agent的在线情况和资源占用情况。

后端服务状态

展示后端服务的负载。

资产中心

运营人员可以通过资产中心对资产数,Agent运行情况,资产上详细信息进行查看。

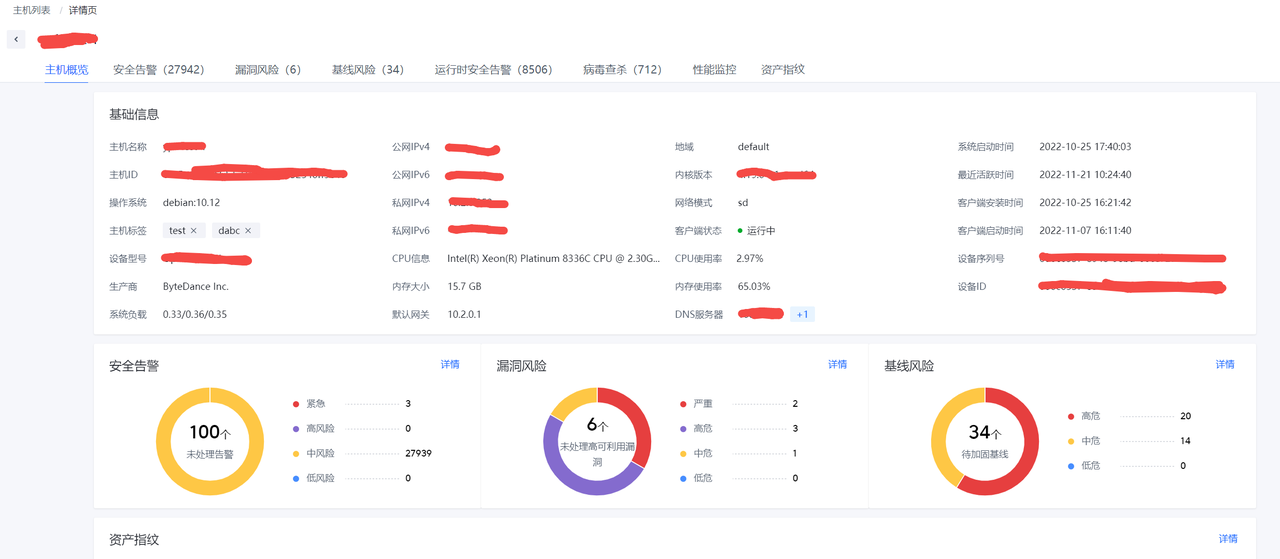

主机列表

展示主机资产的列表以及各主机的风险情况。

点击"主机名称"可以进入查看此主机的资产信息和风险信息。

点击页面中各标签可以查看主机各类相关数据,目前支持下列数据。

- 安全告警

- 漏洞风险

- 基线风险

- 运行时安全告警

- 病毒查杀

- 性能监控

- 资产指纹

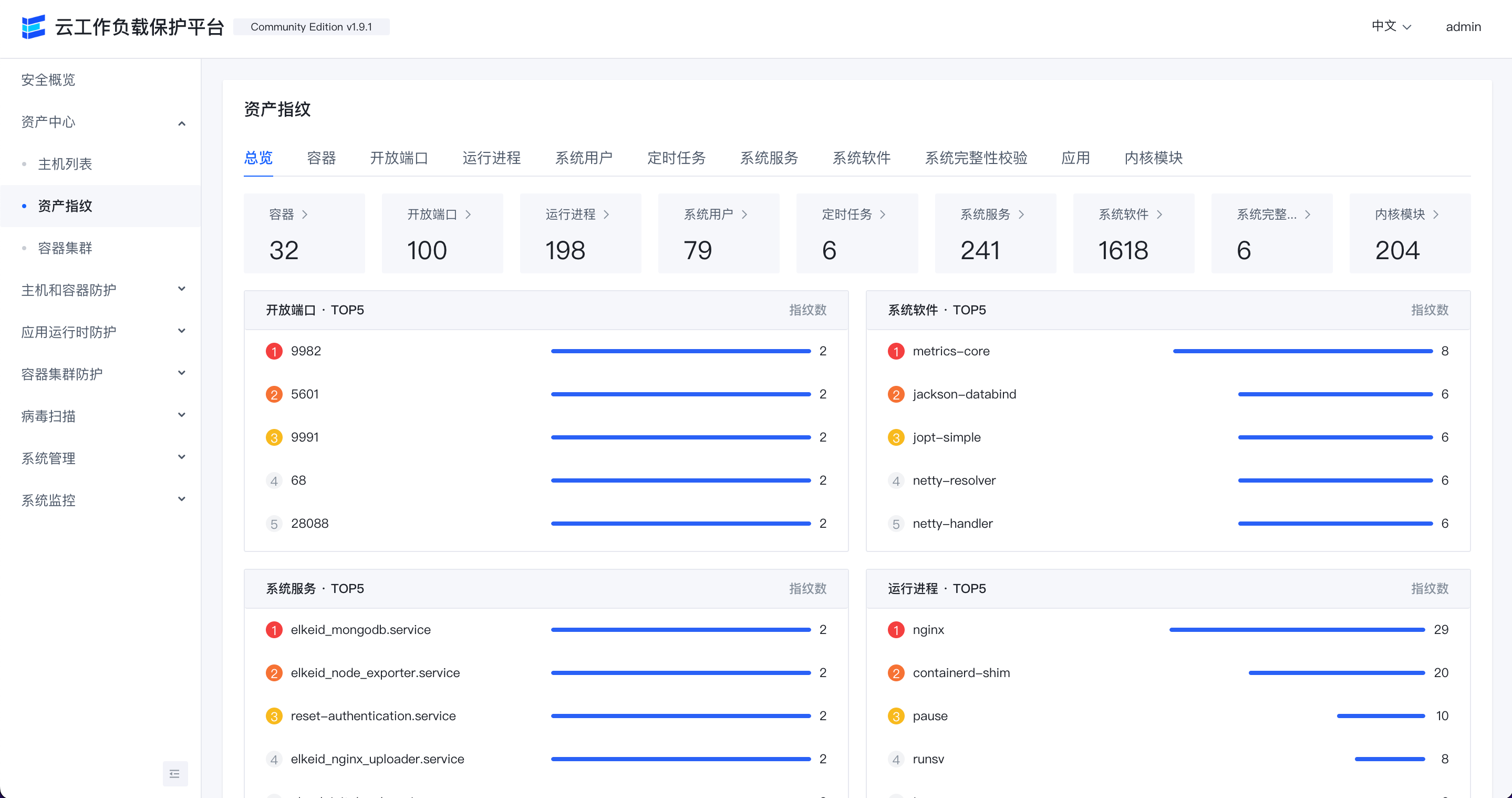

资产指纹

通过该功能查看各主机的开放端口,运行进程,系统用户,定时任务,系统服务,系统软件等详情。

点击页面中各标签可以查看相应资产数据,目前支持下列资产数据:

- 容器

- 开放端口

- 运行进程

- 系统用户

- 定时任务

- 系统服务

- 系统软件

- 系统完整性校验

- 应用

- 内核模块

点击各行的"主机名称"可以跳转到相应主机的详情页,查看此主机资产指纹数据

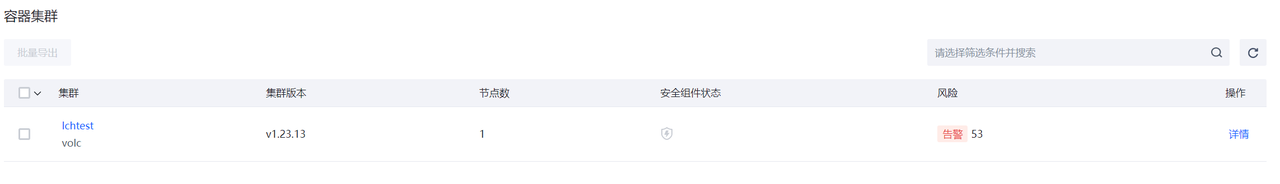

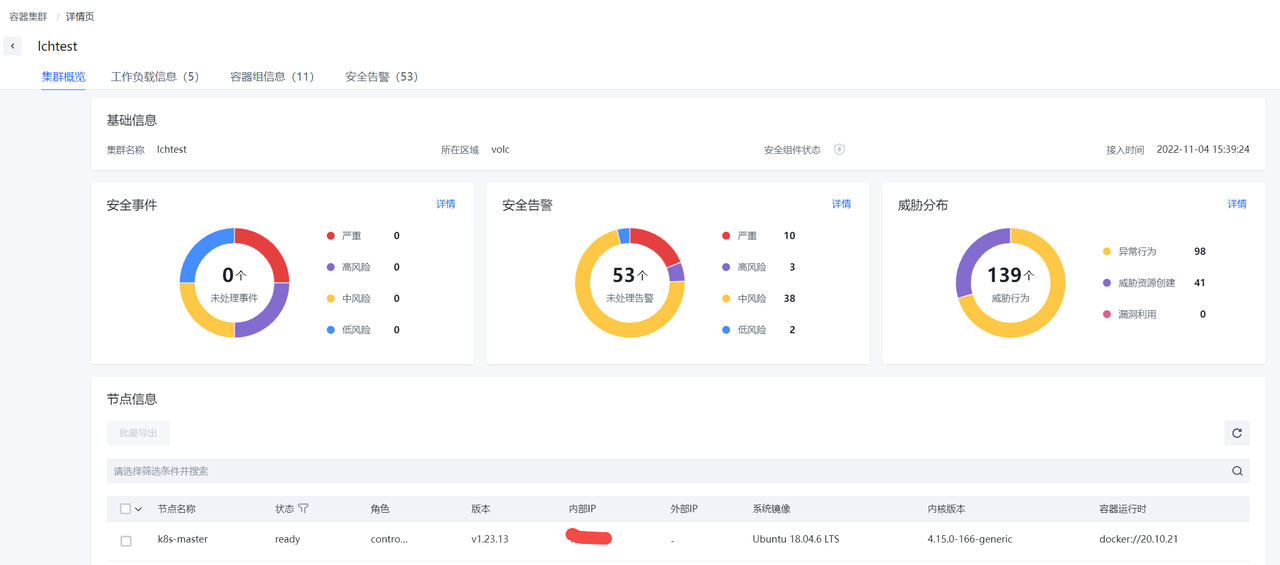

容器集群

展示已经接入容器集群防护能力的容器集群信息。

主机和容器防护

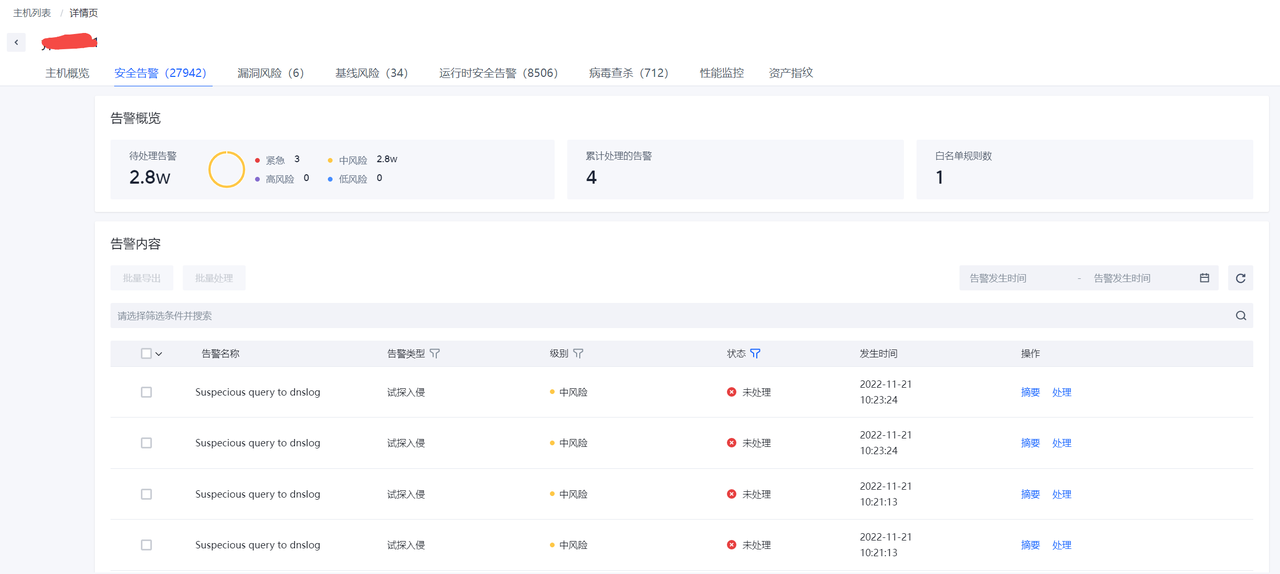

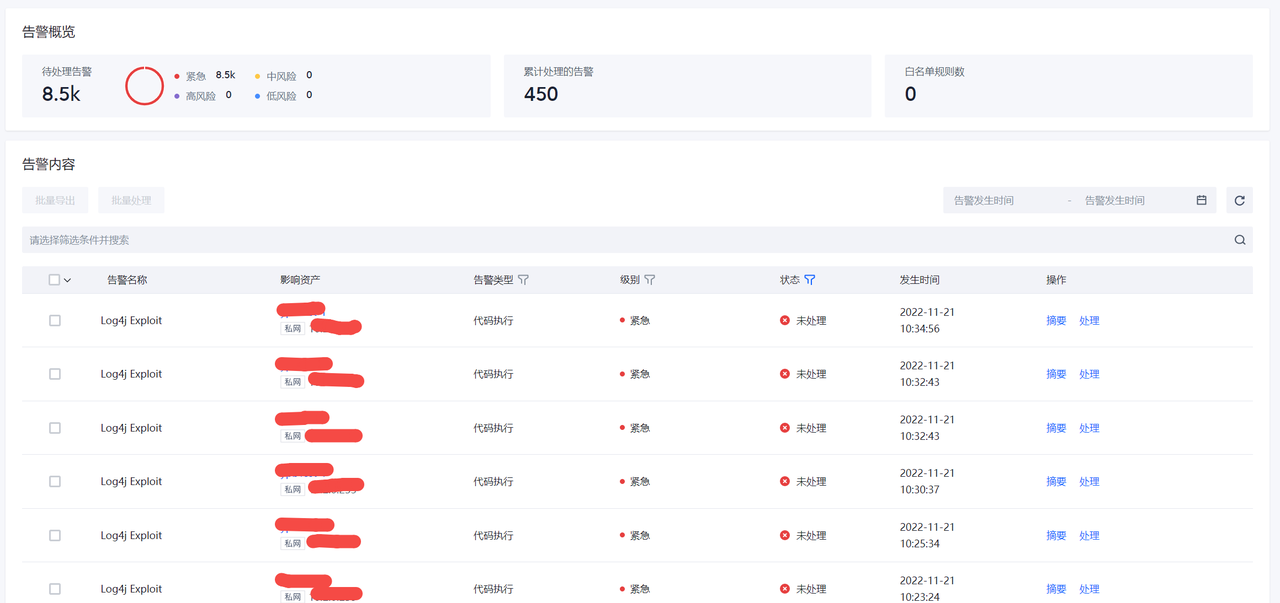

入侵检测

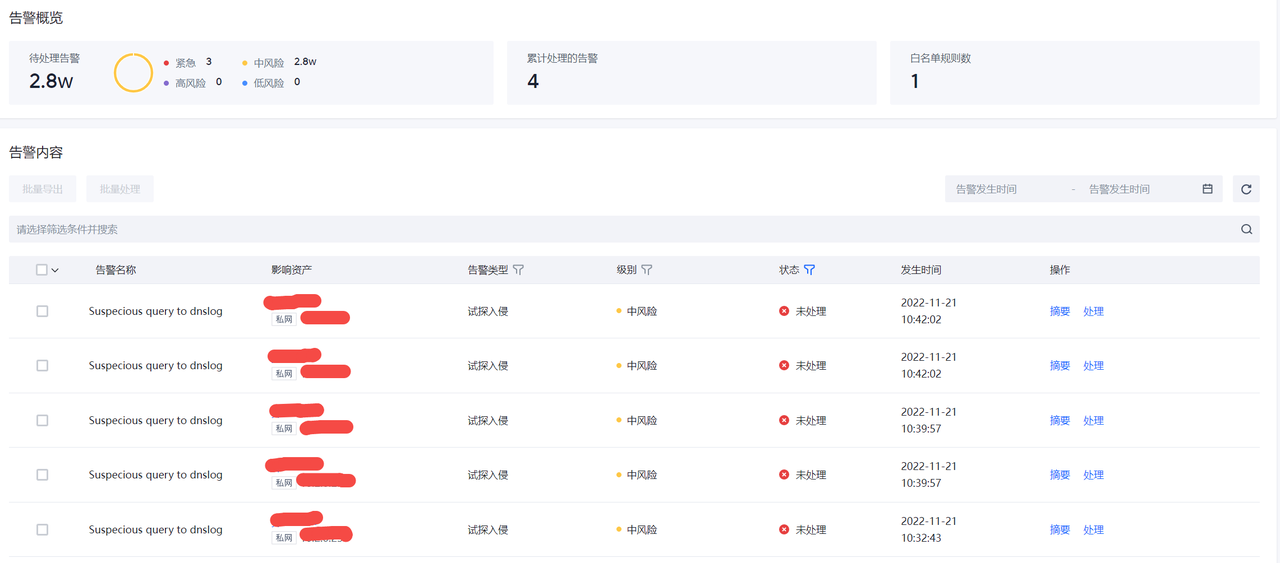

告警列表

告警列表可以查看当前环境内存在的安全告警列表。

点击"摘要"可以查看告警关键摘要信息。

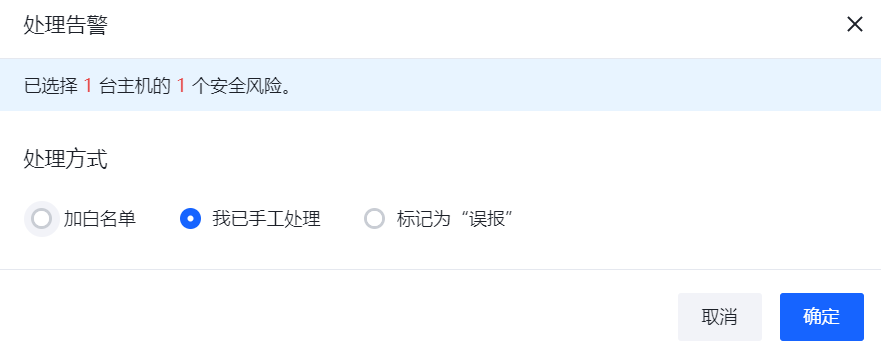

点击”处理”可以进行告警的处理,目前处理操作支持"加白","已人工处理"和“误报”。

点击各行的“影响资产”可以跳转到关联的主机详情页面查看相关数据。

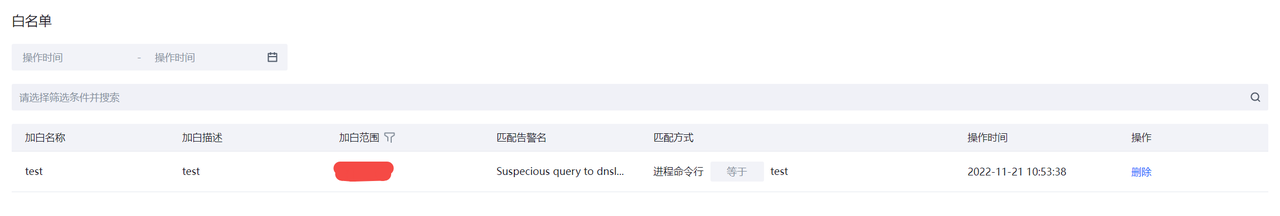

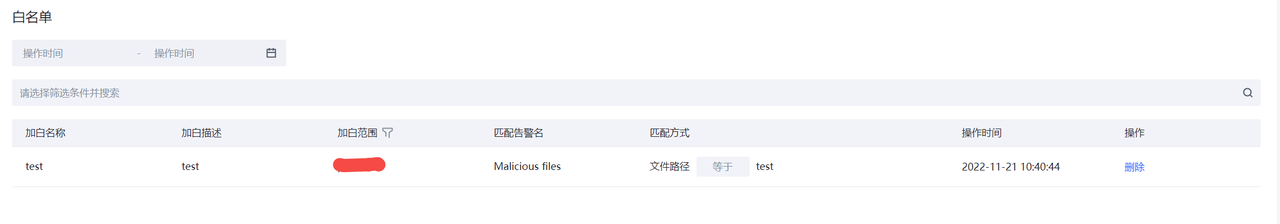

白名单

主机和容器防护告警的白名单。

风险防范

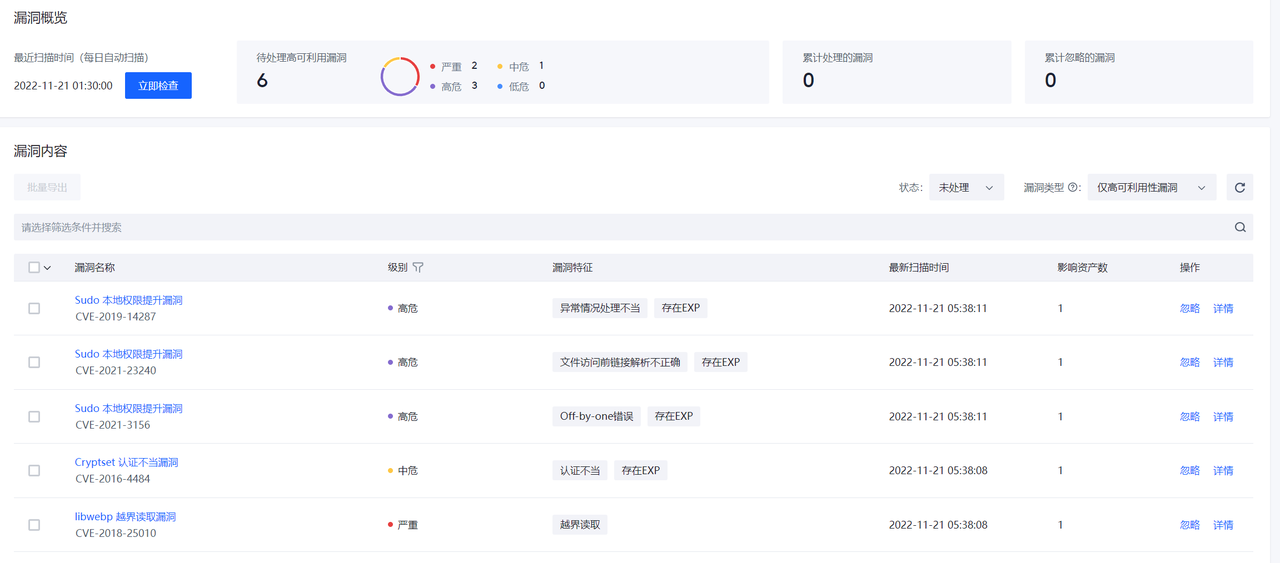

漏洞列表

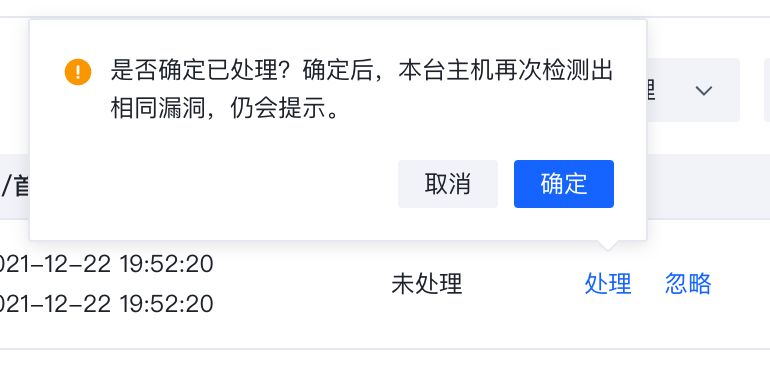

漏洞列表页面可以查看当前环境内存在的安全漏洞风险,默认只显示高风险漏洞的信息,用户通过立即检查来检测环境中最新存在的安全漏洞。

在漏洞列表数据右侧点击详情可以查看漏洞信息以及影响的资产列表。

漏洞信息也可以通过处置与忽略进行标记。

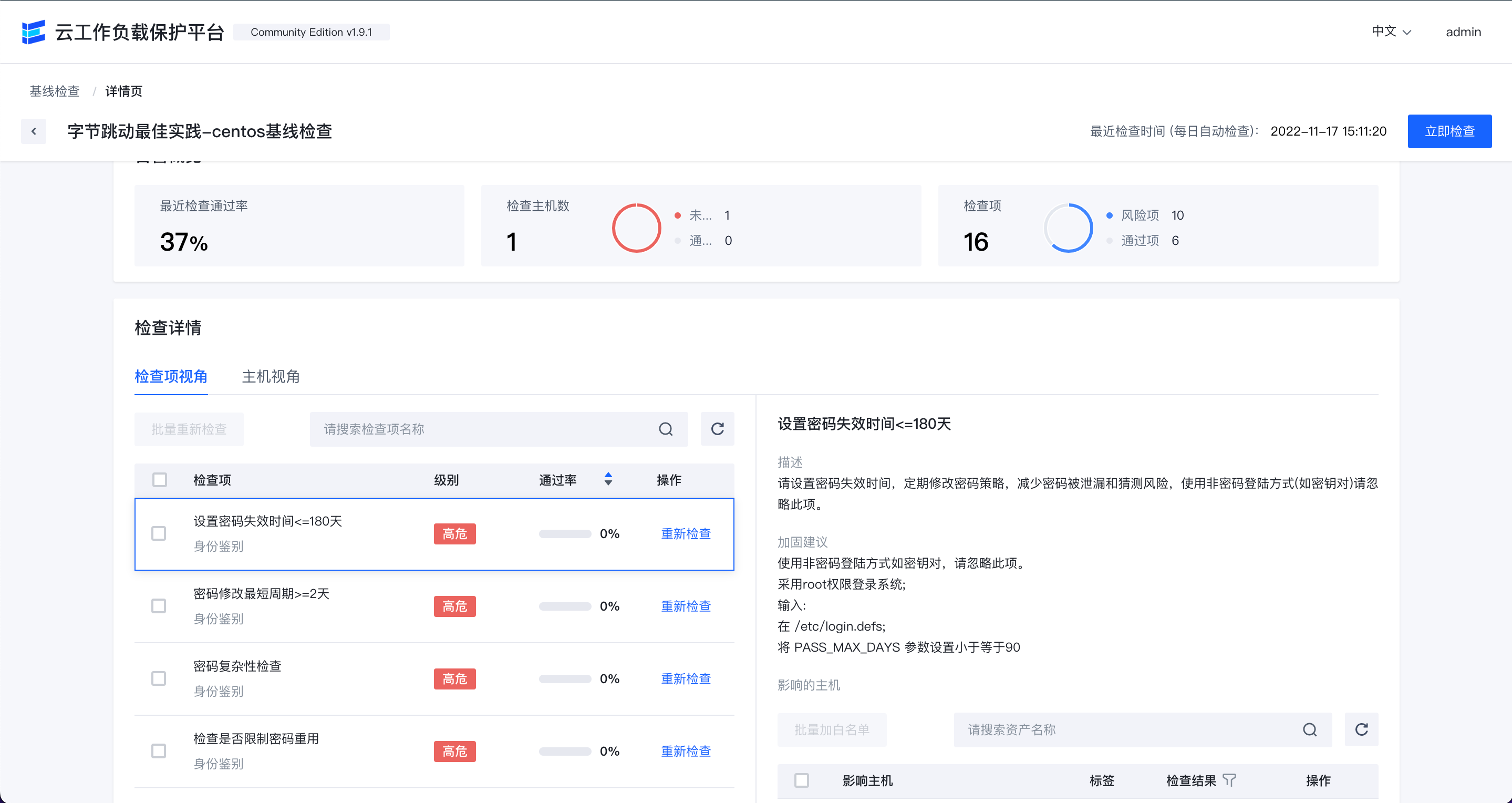

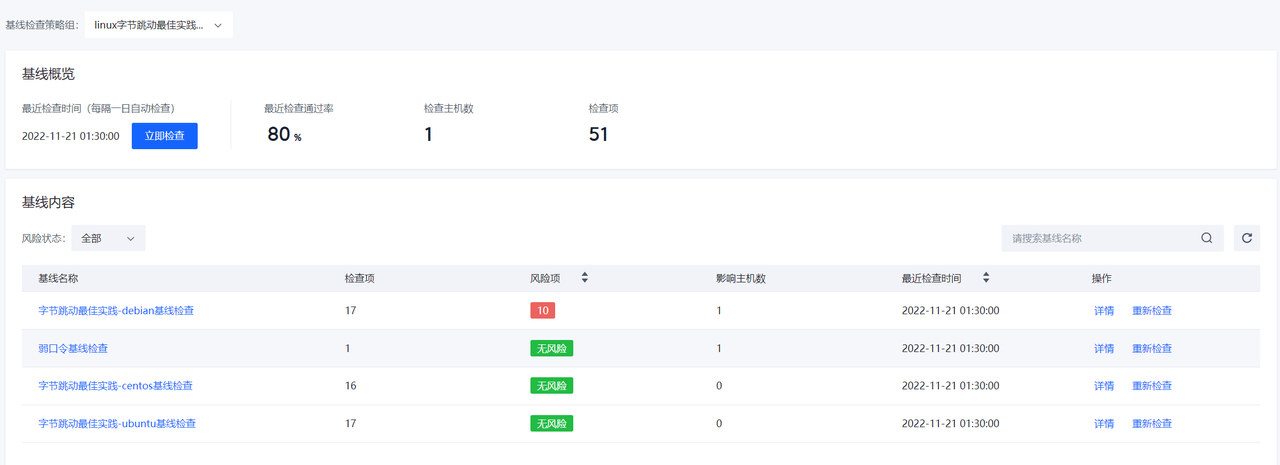

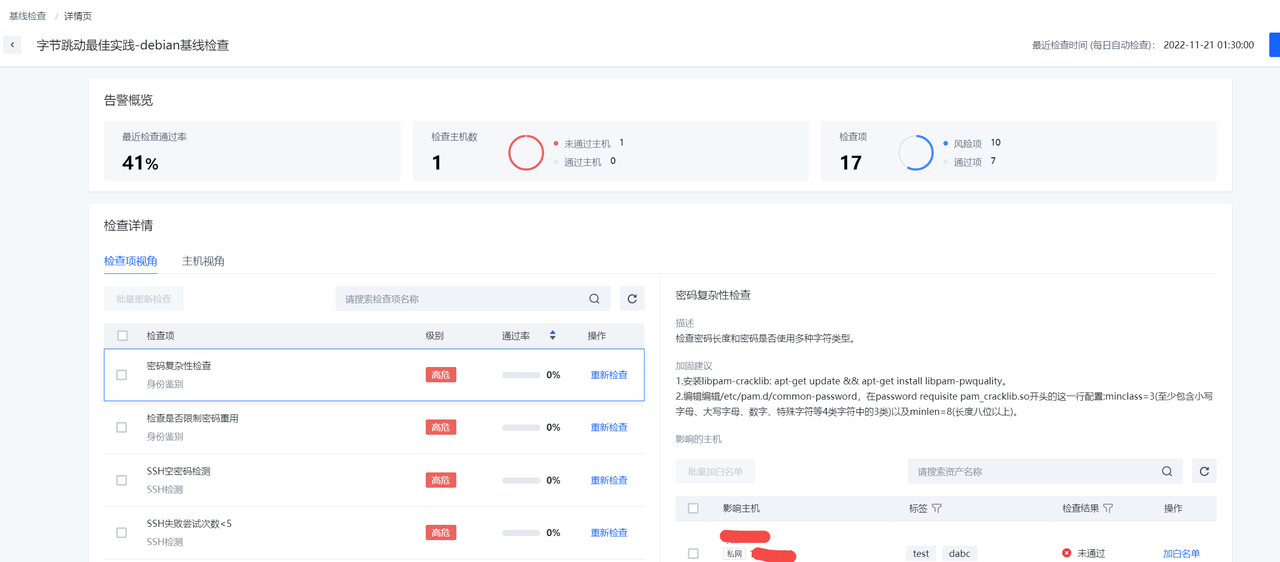

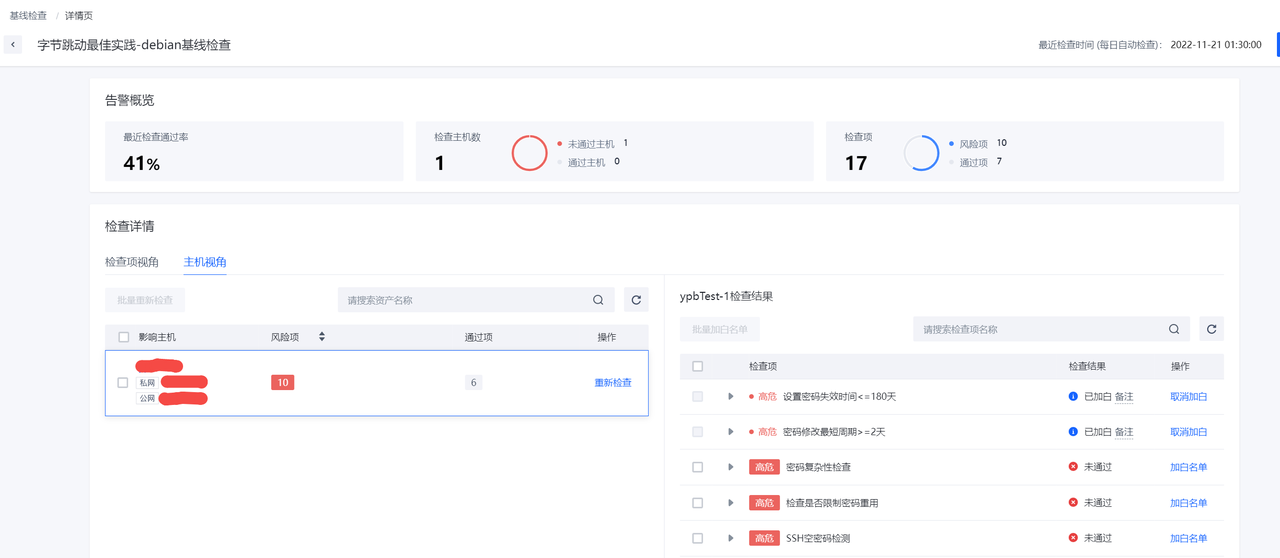

基线检查

基线检查页面可以查看当前环境内存在的安全基线风险,可以通过立即检查来查看环境中最新存在的安全基线问题。

在基线列表右侧点击详情可以看到相应的基线详情。

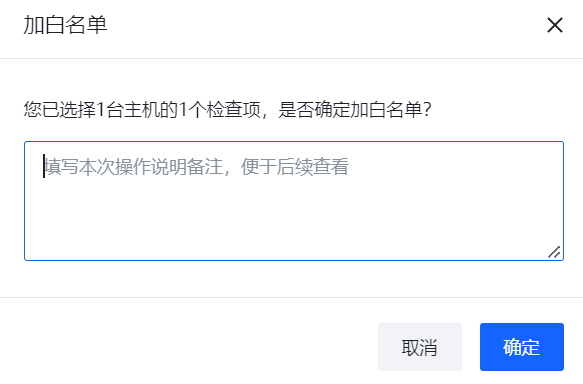

点击加白名单可以进行加白操作。

应用运行时安全防护

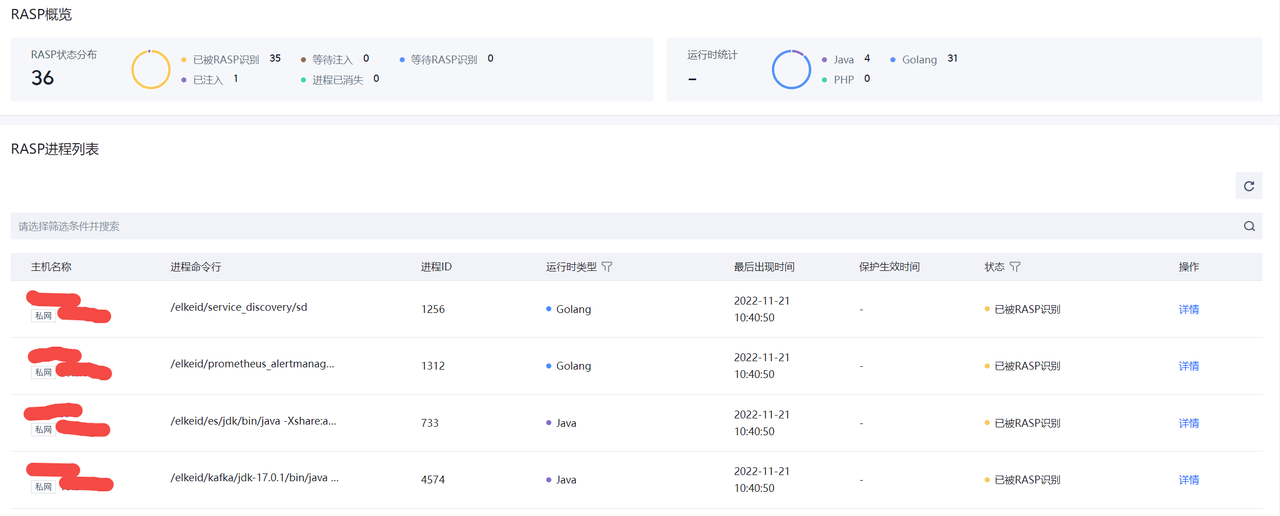

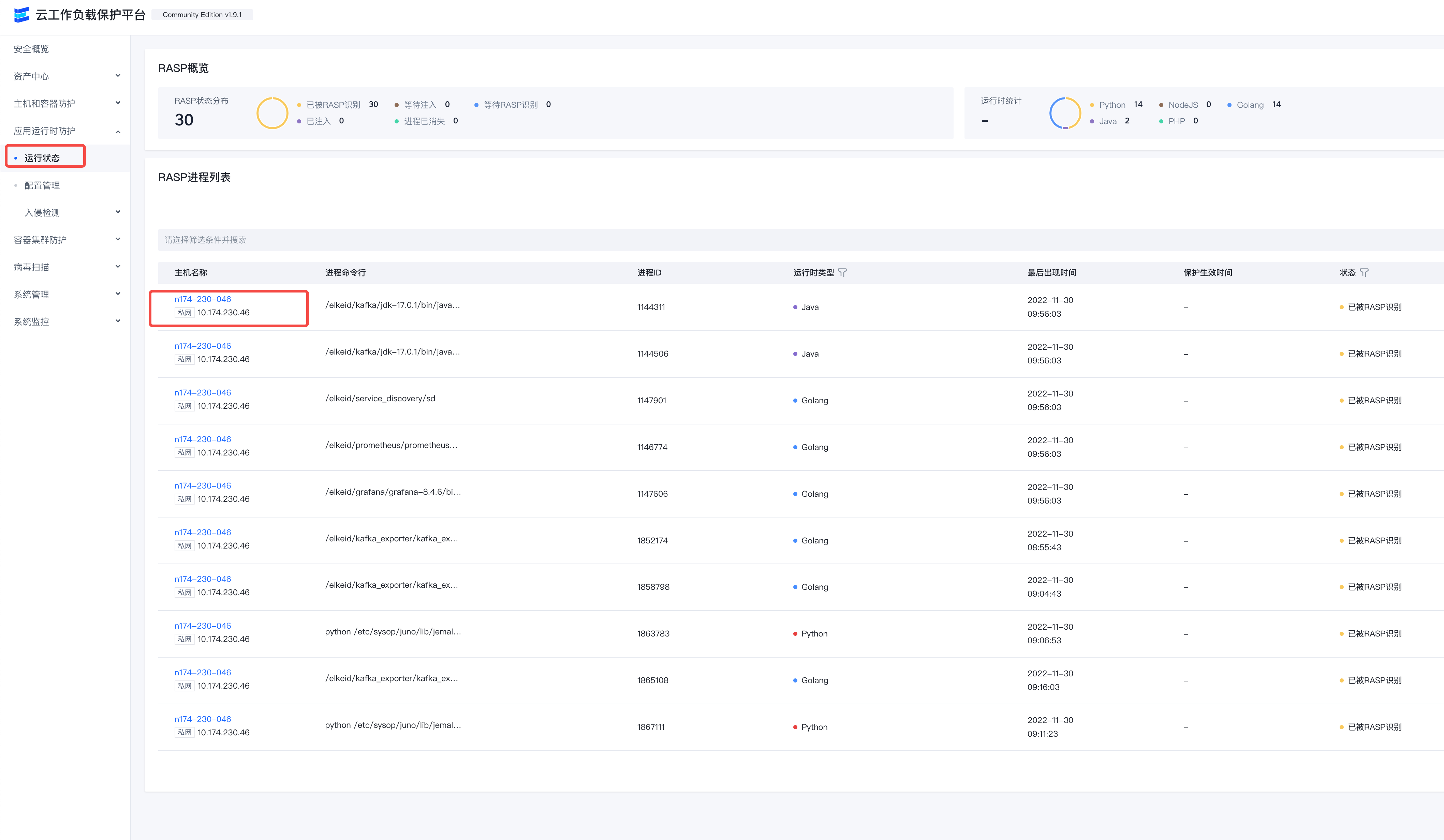

运行状态

展示运行时安全组件的覆盖情况。

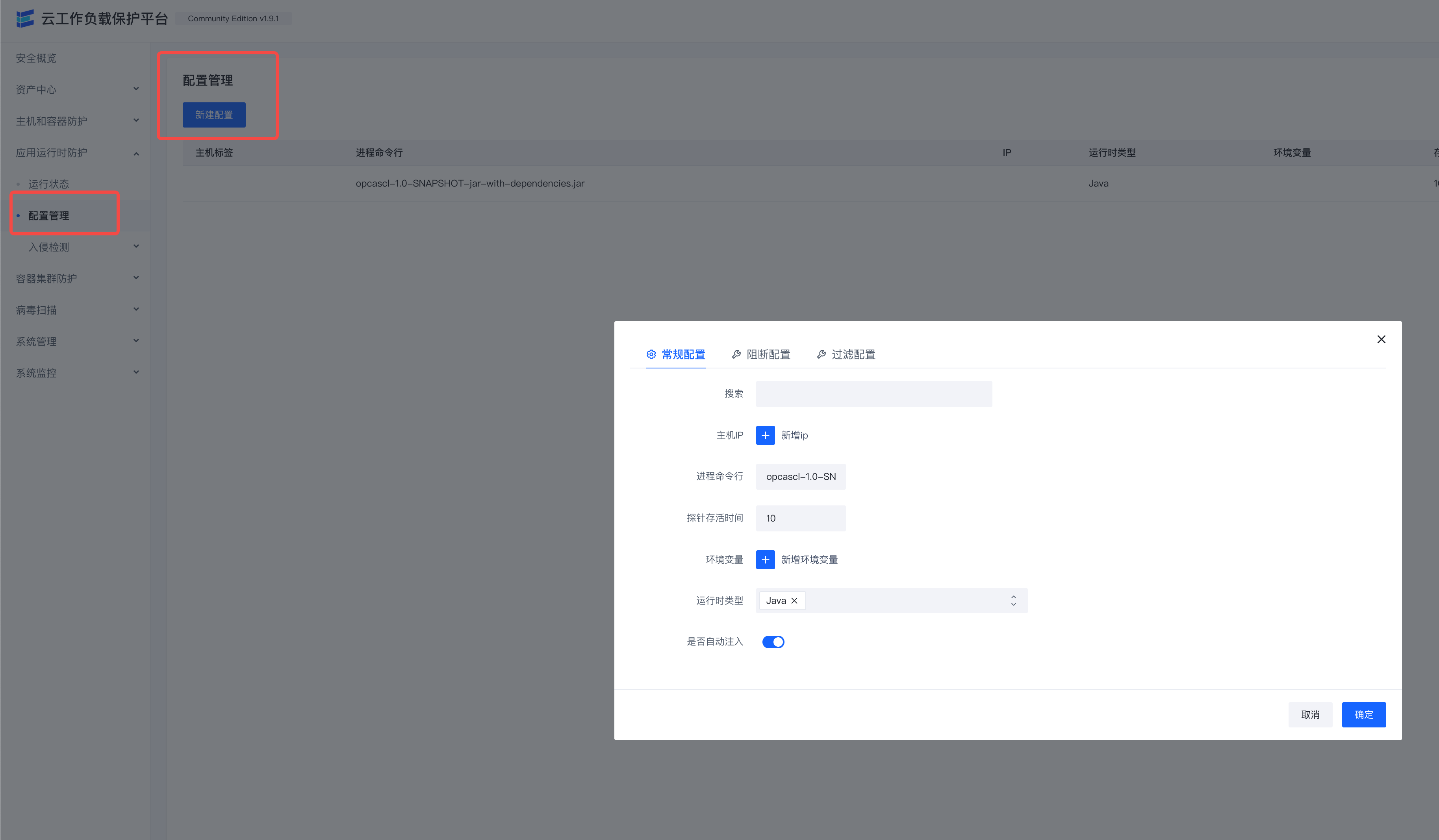

配置管理

进行运行时安全组件的配置管理。

入侵检测

告警列表

运行时安全检测发现的安全告警展示。

白名单

运行时安全检测告警过滤白名单规则展示。

容器集群防护

入侵检测

告警列表

容器集群防护发现的安全告警展示。

白名单

容器集群防护告警过滤白名单规则展示。

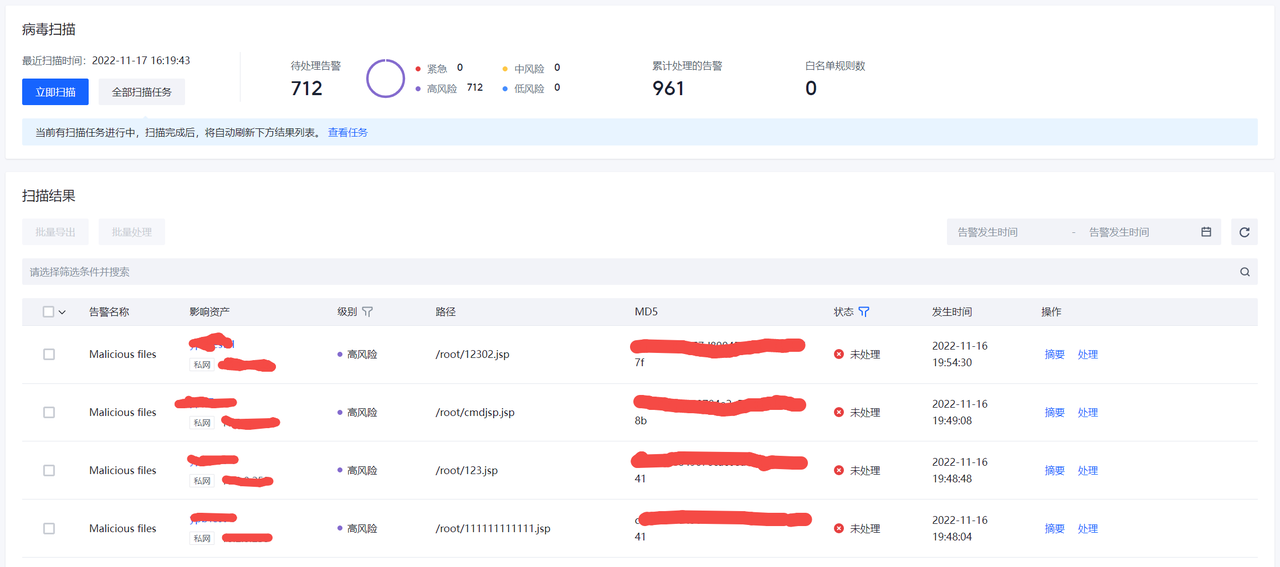

病毒扫描

病毒扫描

显示检测到的病毒文件信息。

白名单

对病毒检测结果进行过滤的白名单列表。

系统管理

任务管理

该功能主要用于重启客户端、同步配置等管理。

点击”新建任务“,可以进行任务的配置。

除"重启客户端"类型任务外,其他类型任务需要先在"组件管理"和"组件策略"界面进行Agent和插件的配置,才能进行相应操作。

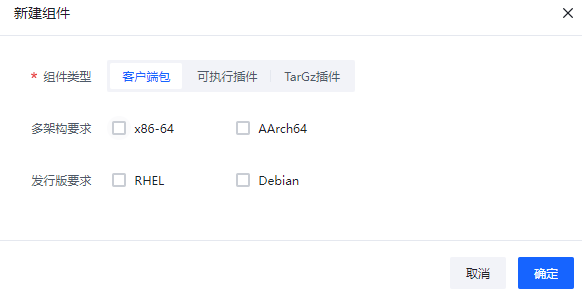

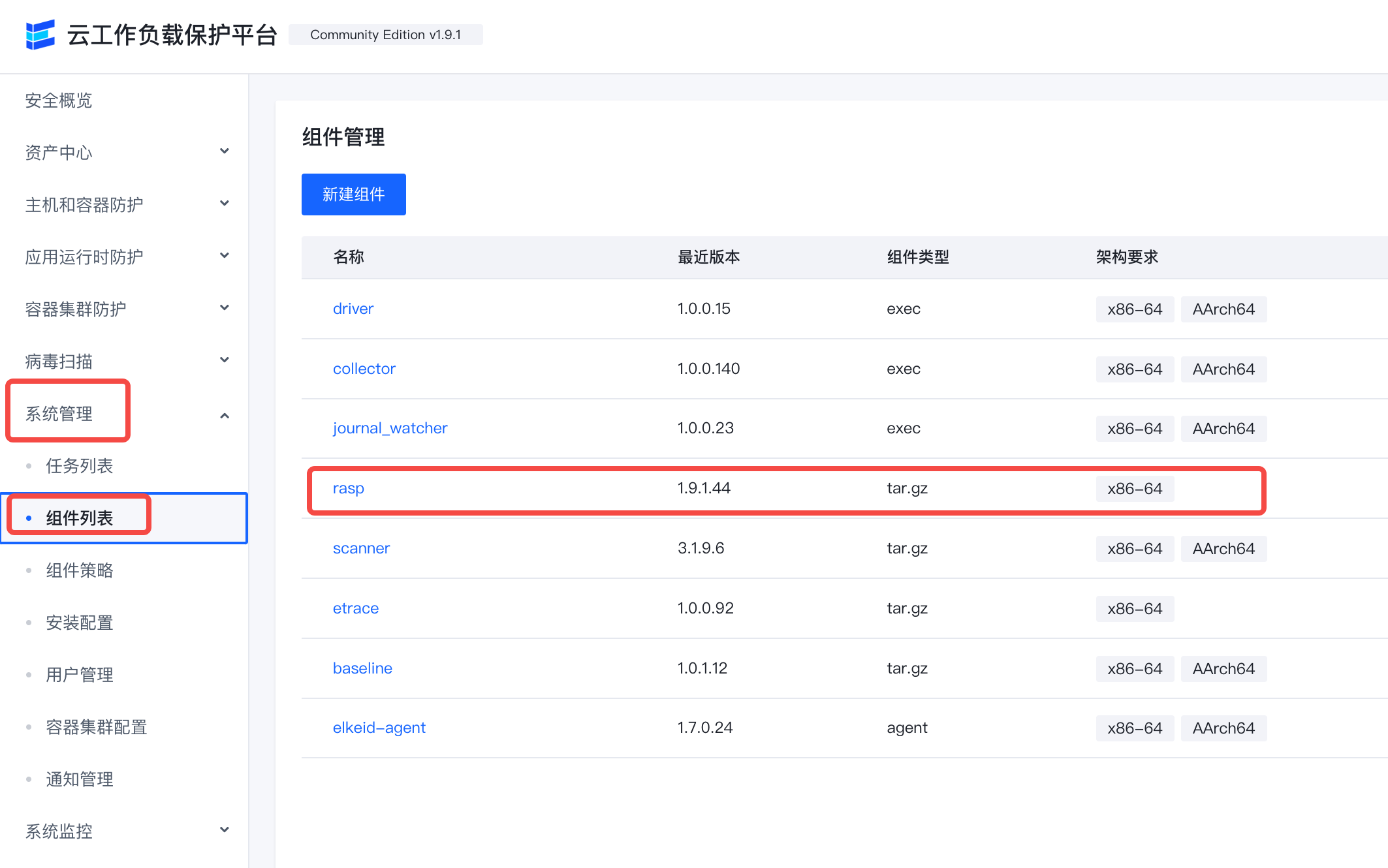

组件管理

用于对Agent和相应插件进行升级配置的管理。

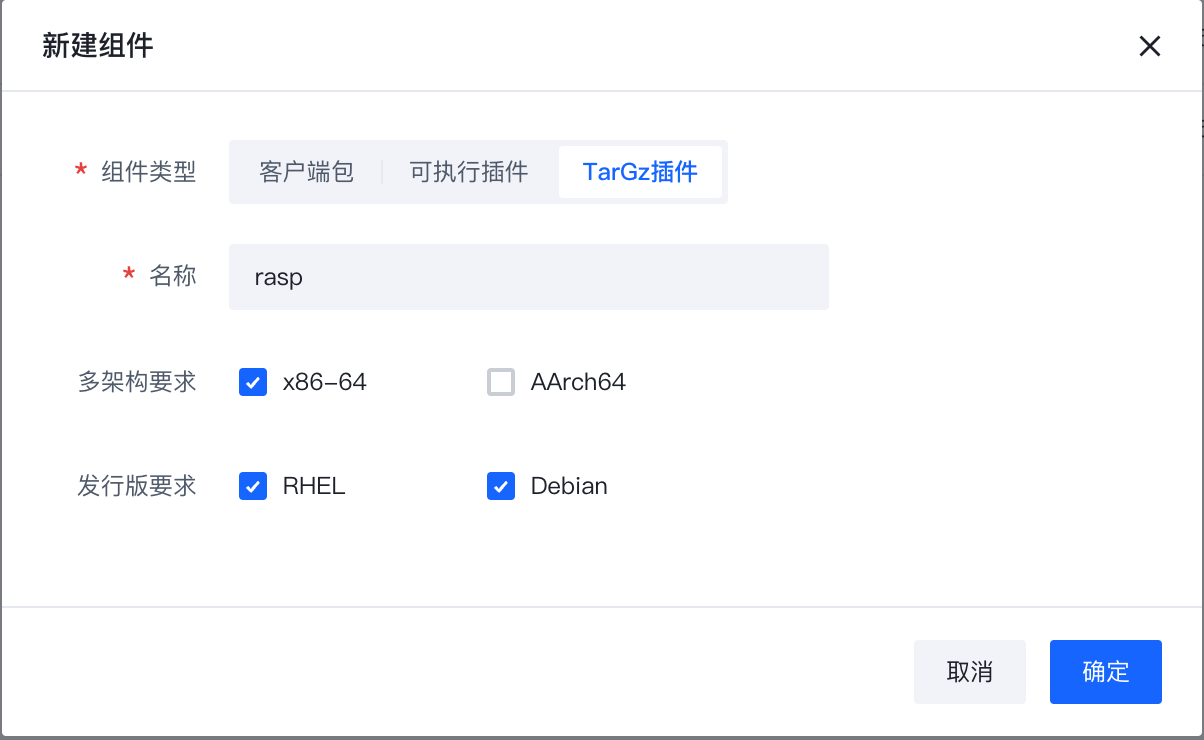

点击”新建组件“可以选择组件的类型是Agent还是插件,然后进行相应配置。

点击发布版本按钮,可以通过上传对应架构与发行版的组件文件生成版本实例。

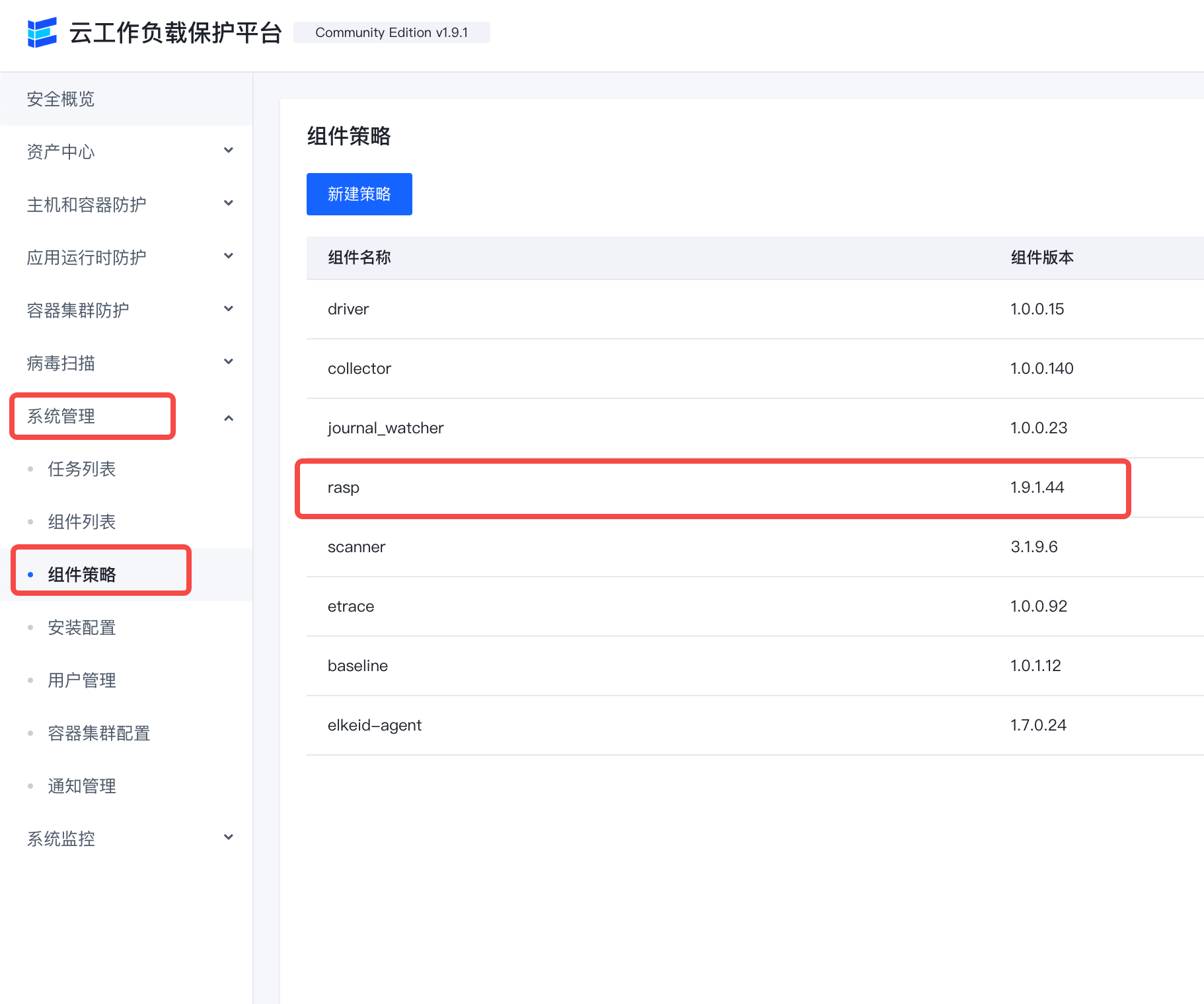

组件策略

通过管理组件策略,调整Agent实际生效的组件版本,进而实现更新、卸载等操作。

点击新建策略,通过选择组件名称及相匹配的版本,将对应策略添加至策略组中。

通过屏蔽规则使得部分主机不加载(生效)对应组件。

安装配置

可以通过部署帮助来实现Agent的部署和卸载。

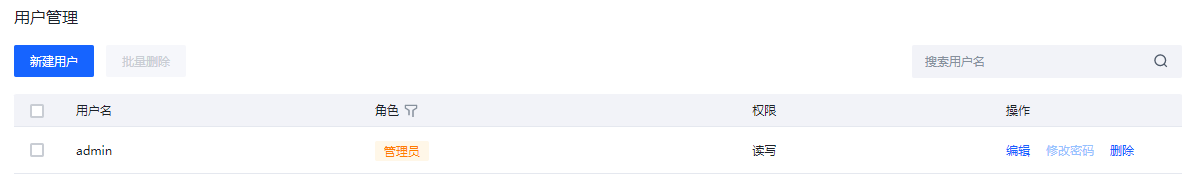

用户管理

可以在用户管理中对Elkeid Console进行管理,如修改密码,新增与删除用户。

点击"新增用户"可以设置增加新的用户,设置密码的时候请注意密码强度的要求。

容器集群配置

进行容器集群防护能力接入的配置。

通知管理

告警通知以及过期通知的配置管理,支持飞书,钉钉等。

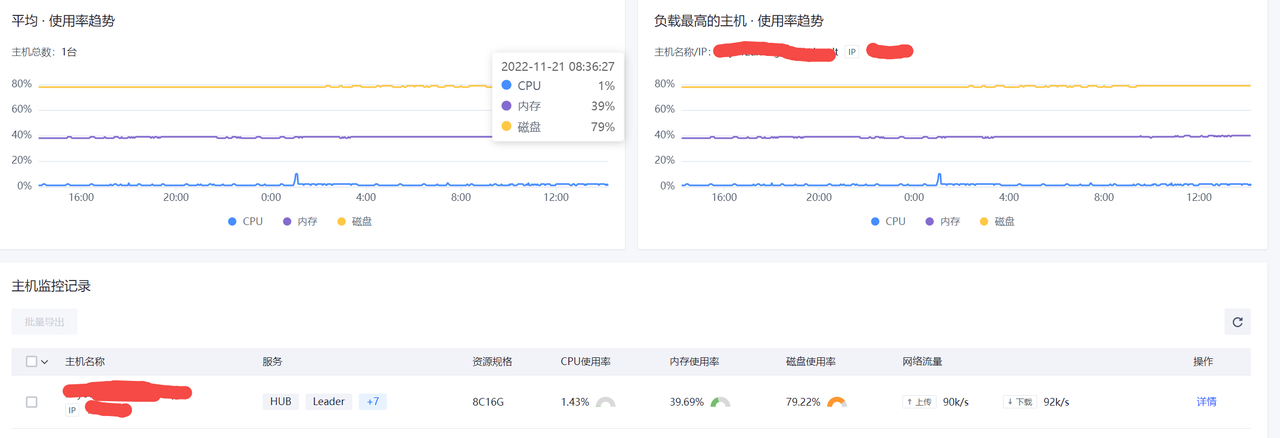

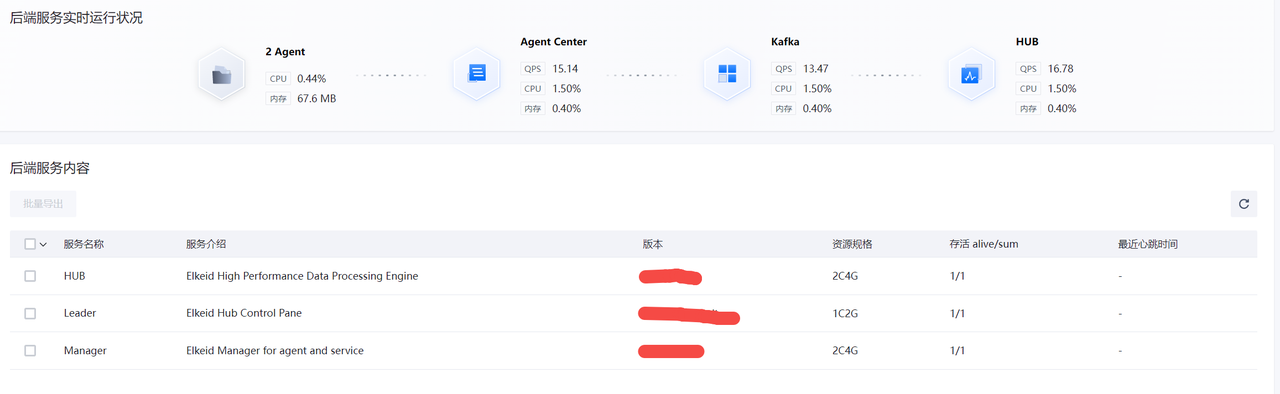

系统监控

后端监控

查看后端服务所在主机的CPU,内存,磁盘和网络流量等使用情况。

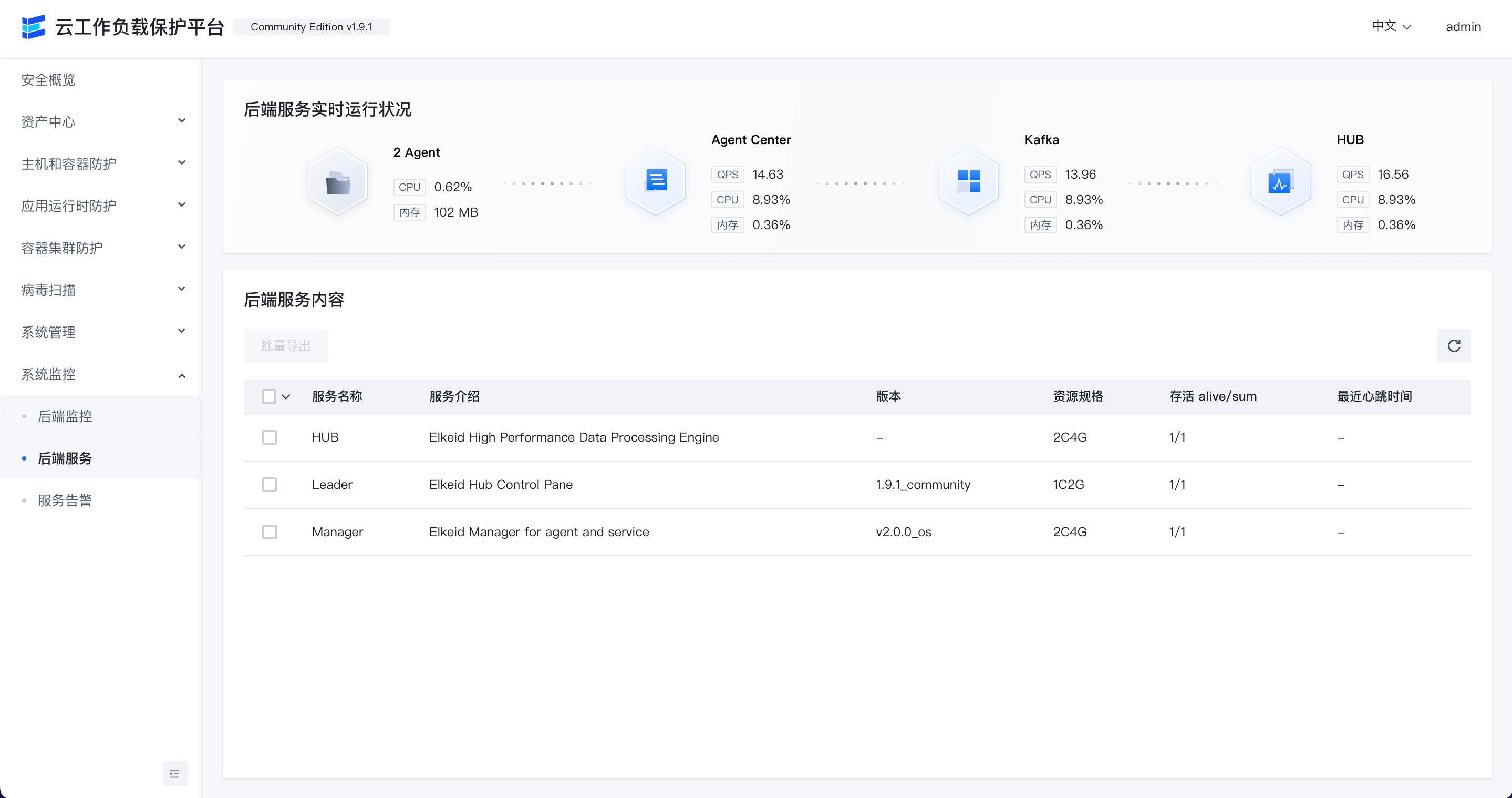

后端服务

查看后端各服务模块的QPS,CPU和内存的使用情况。

服务告警

显示最近1小时/24小时发现的服务异常告警。

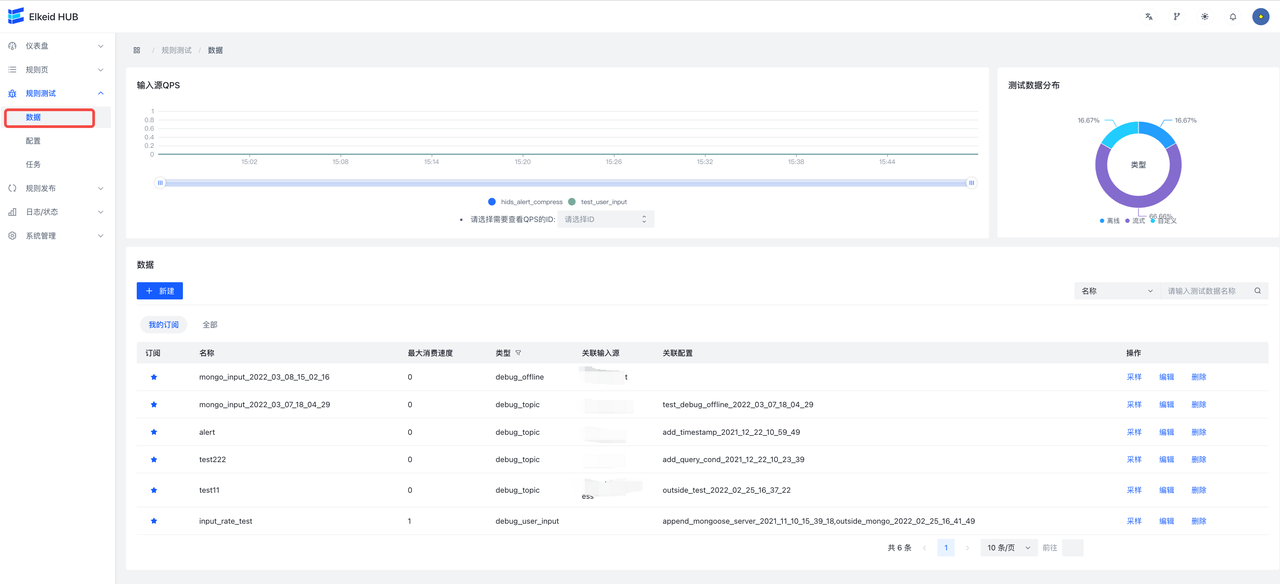

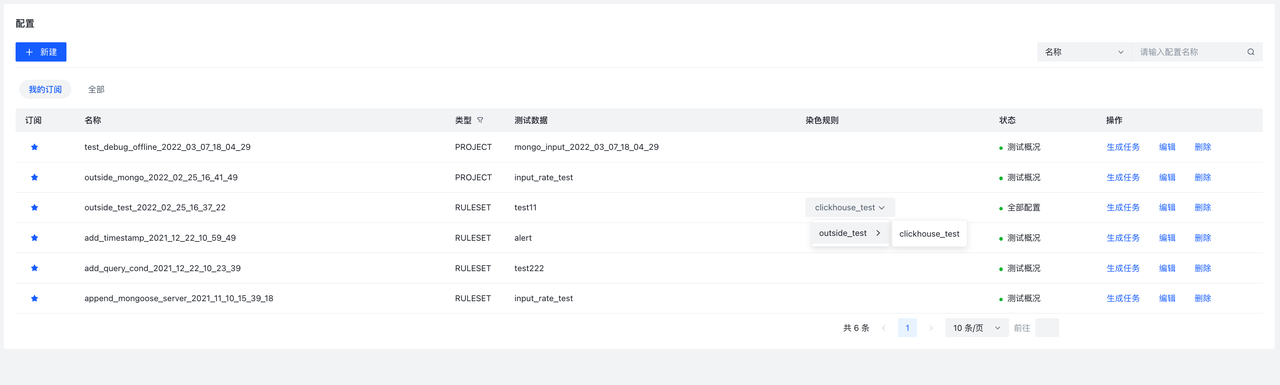

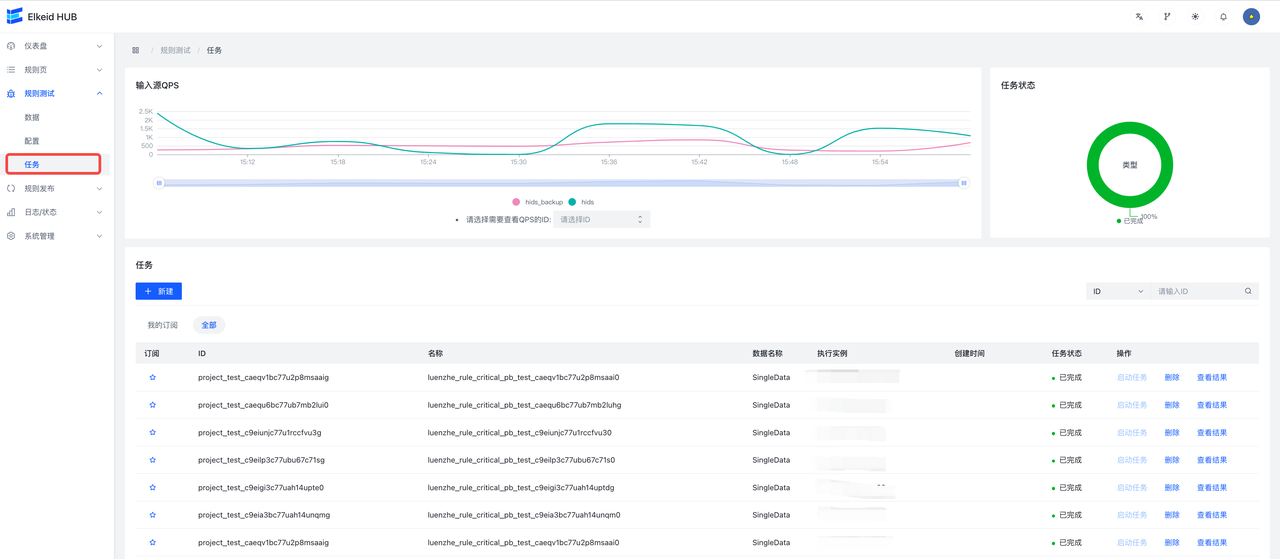

Elkeid HUB 社区版快速上手教程

本教程的前置条件

在开始本教程之前,请检查:

- 已经按照部署文档,使用elkeidup正确部署了 HUB。

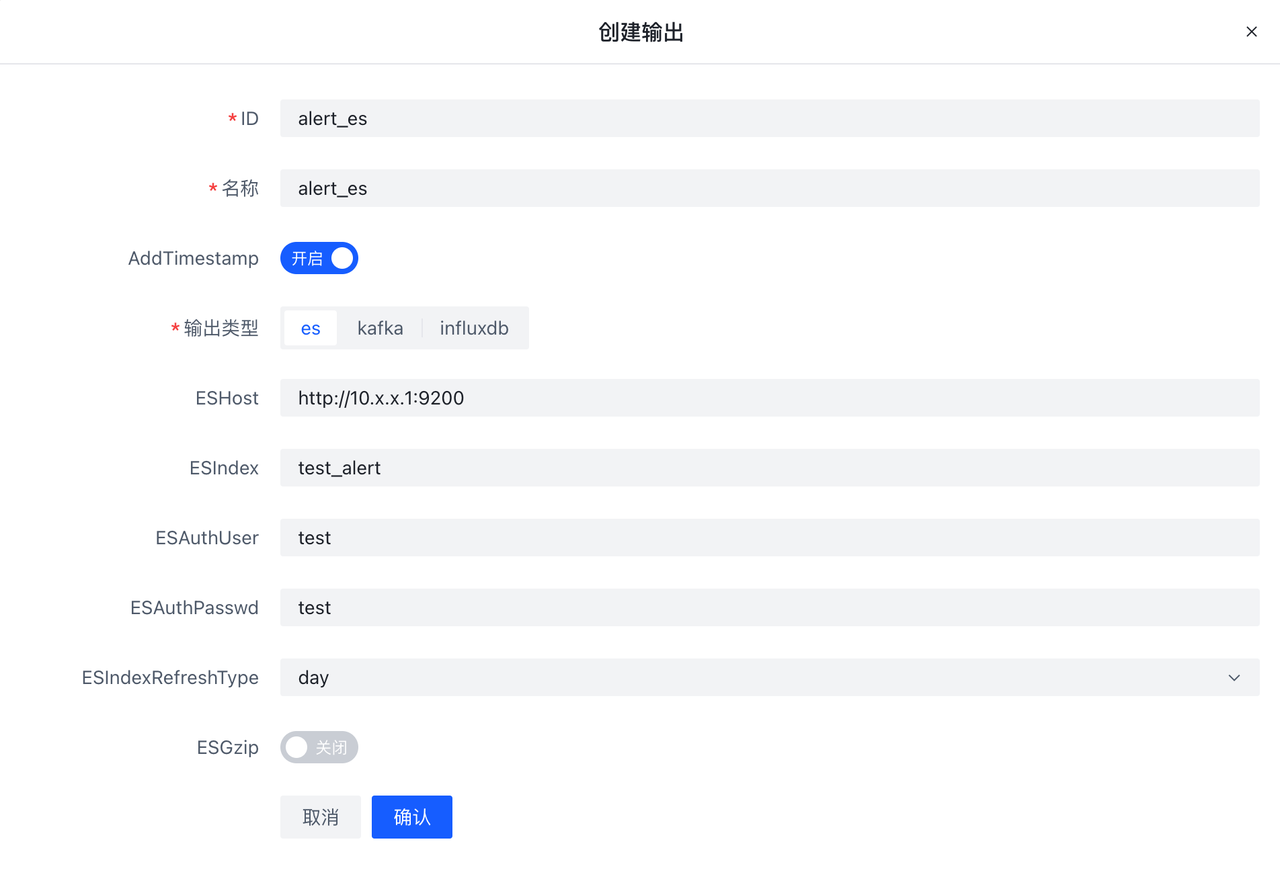

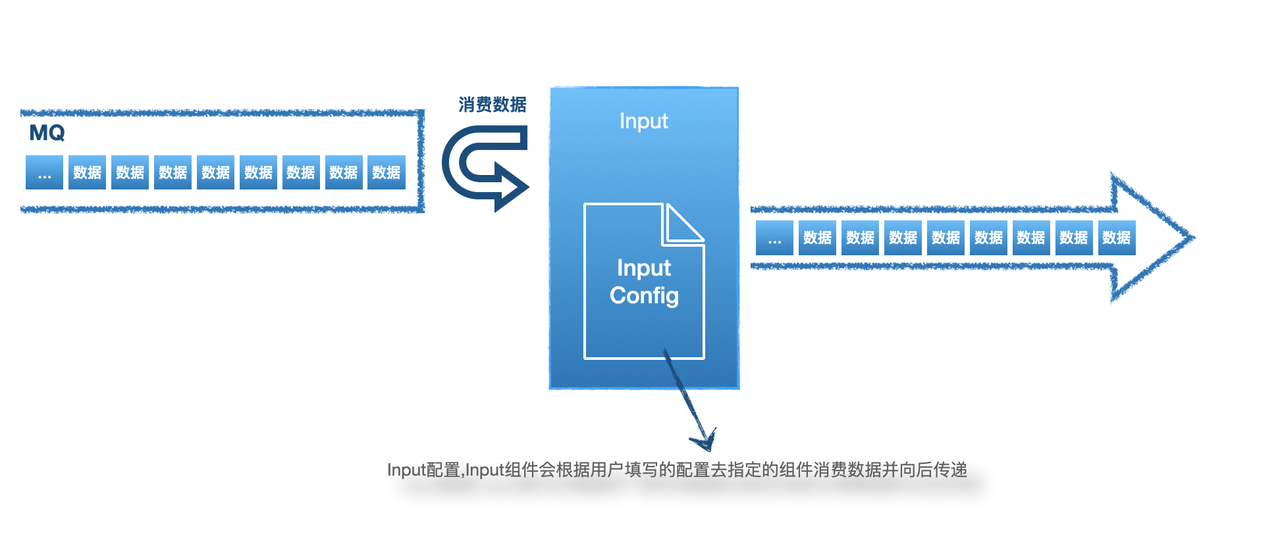

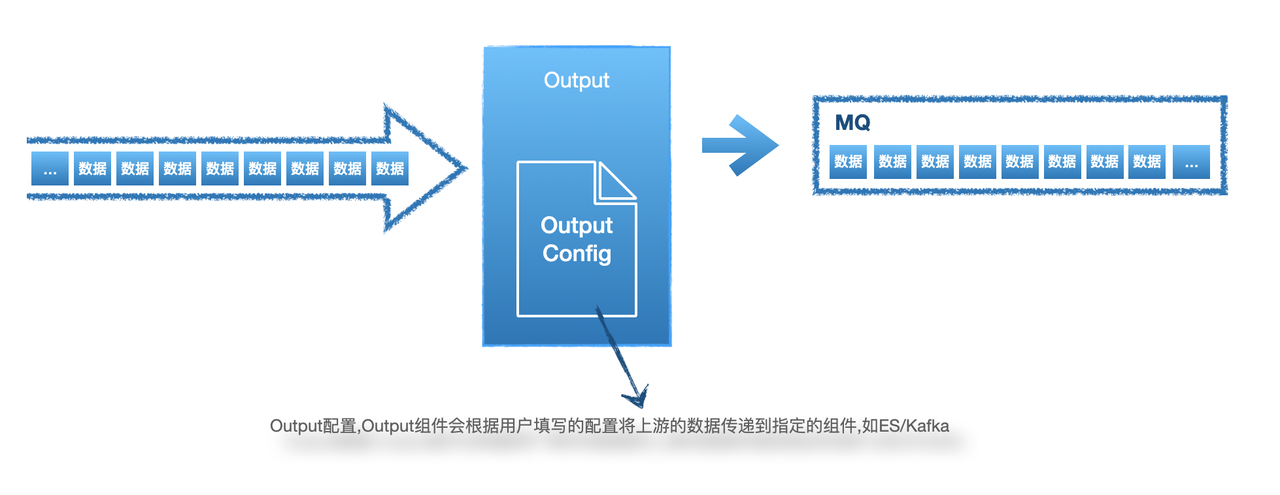

- 至少有一个可以使用的数据输入源(Input)和数据存储的输出源(Output)。在HIDS场景中,数据输入源为 AgentCenter 配置文件中指定的 kafka ,输出源可以使用 ES 或 Kafka ,本教程中以 ES 为例。

e.g. 社区版默认已配置输入源(hids,k8s)可在前端看到,方便测试使用

Step 1. 访问并登录前端

使用部署前端机器的 IP 即可访问前端,登录信息为elkeidup部署创建的用户名和密码。

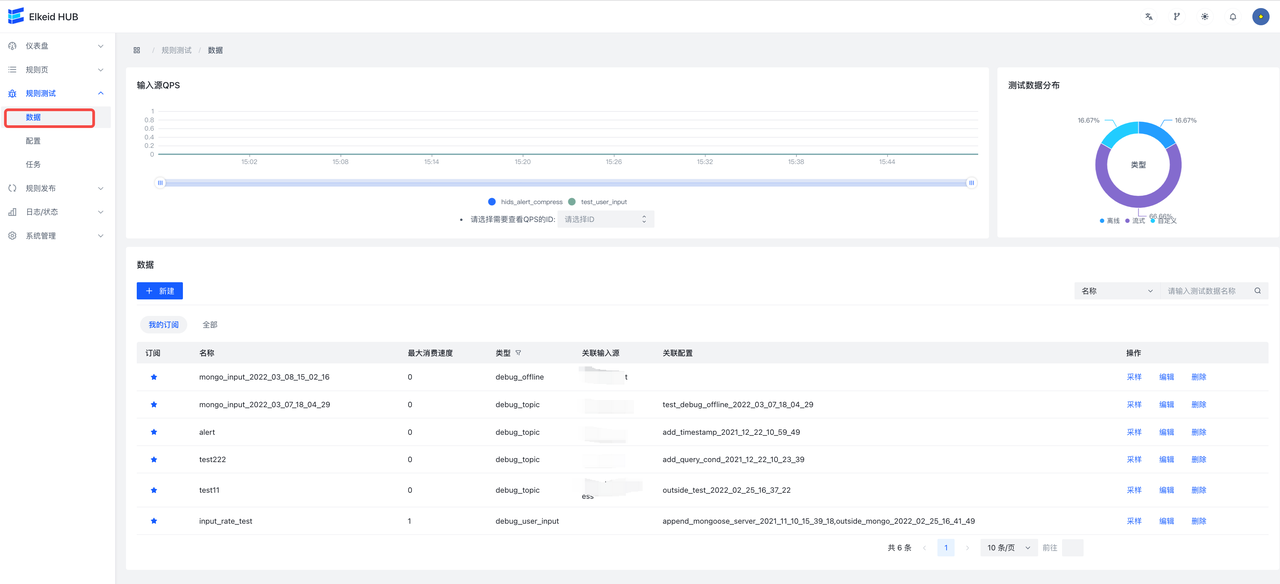

Step 2. 编写策略

基本概念介绍

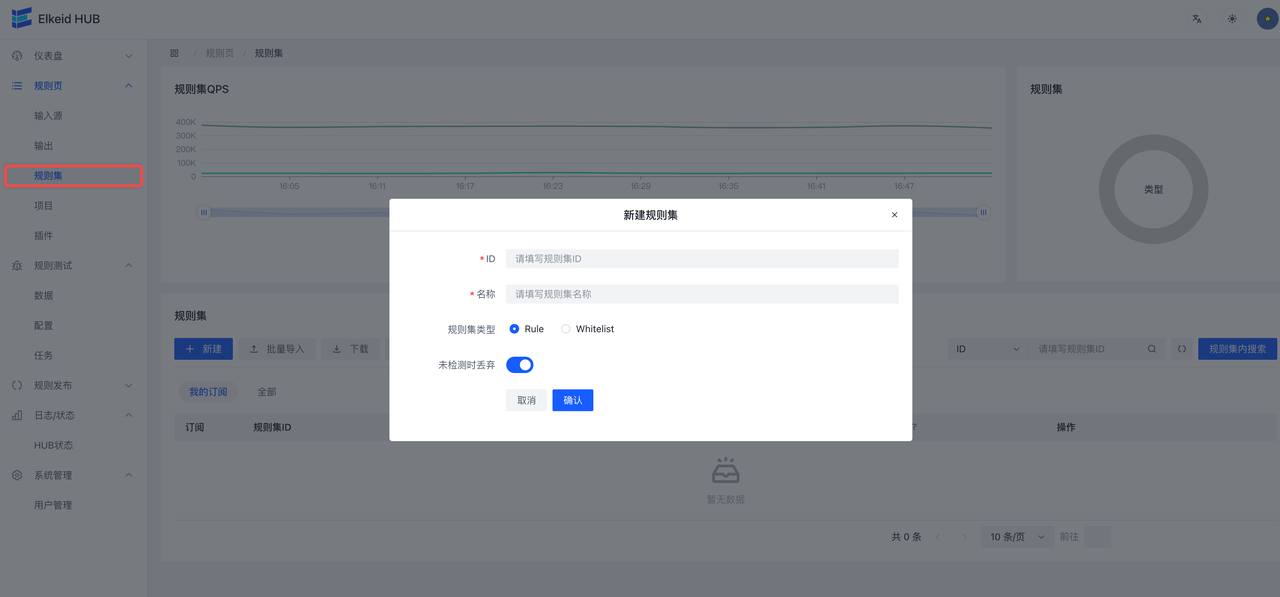

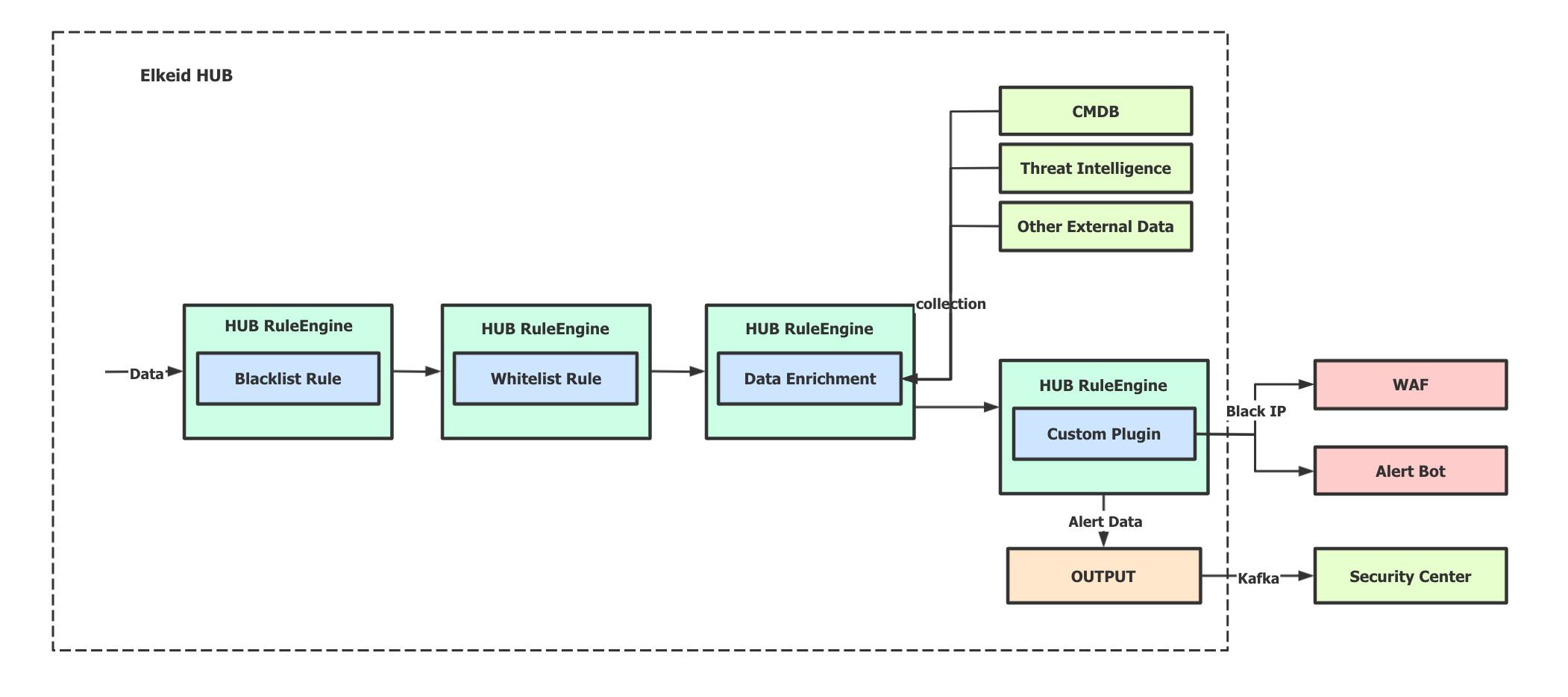

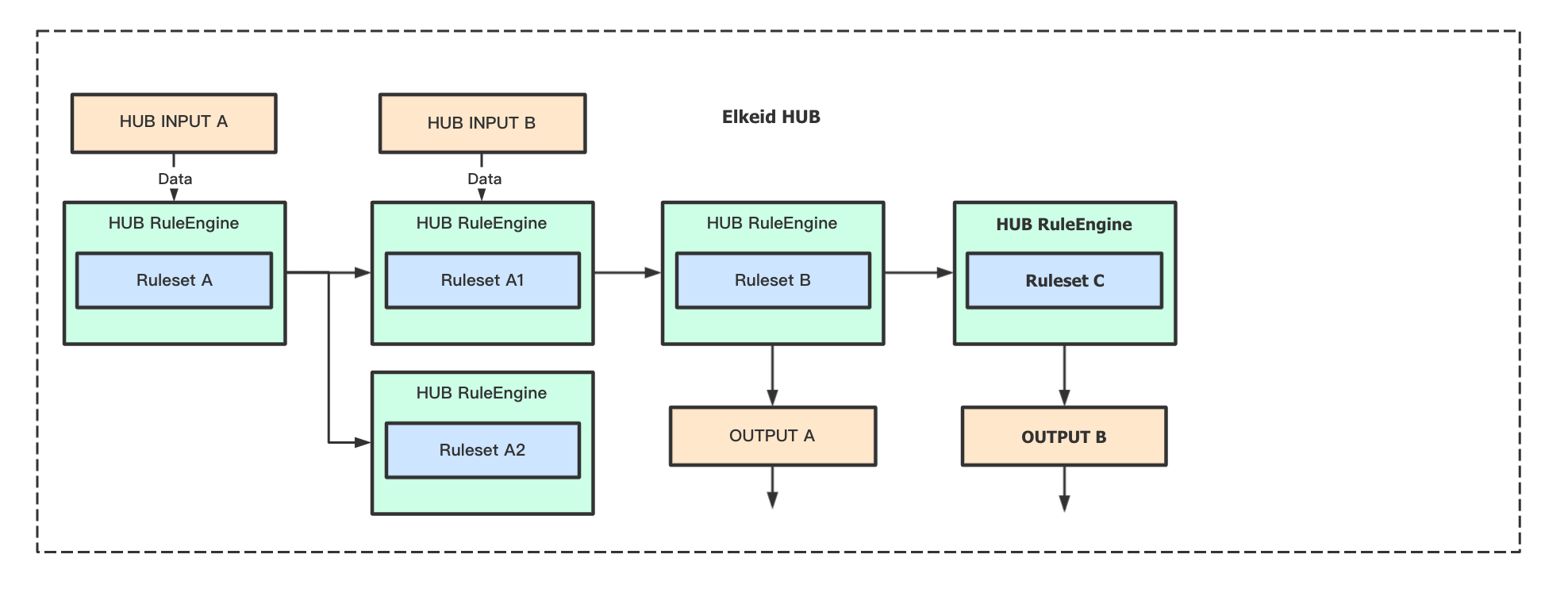

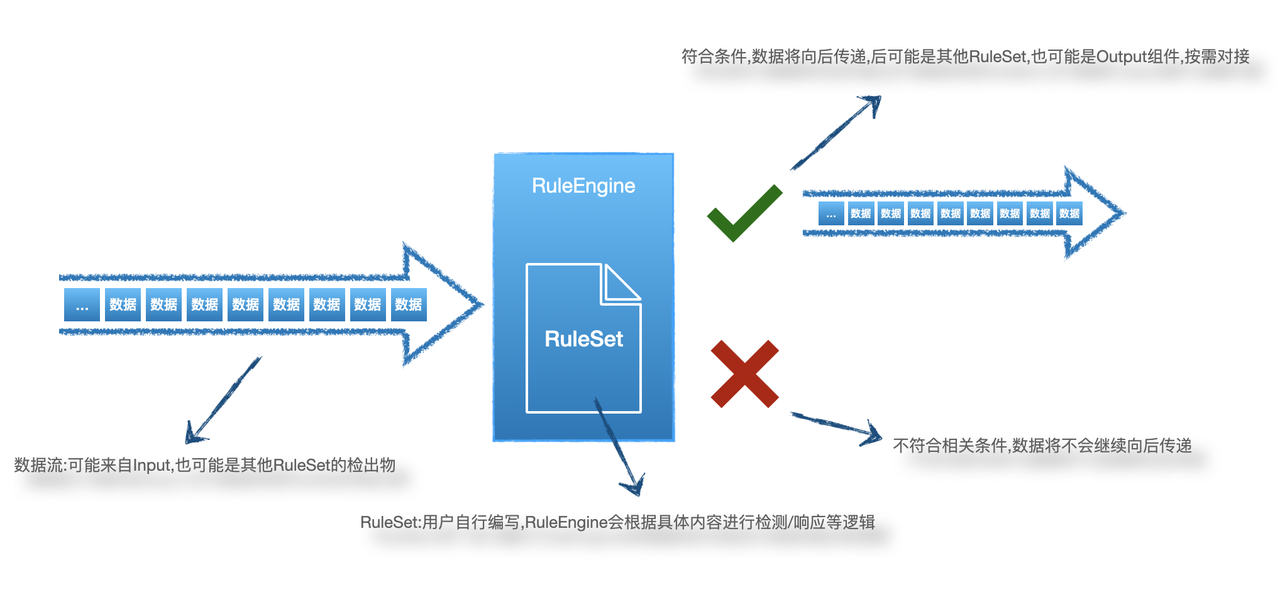

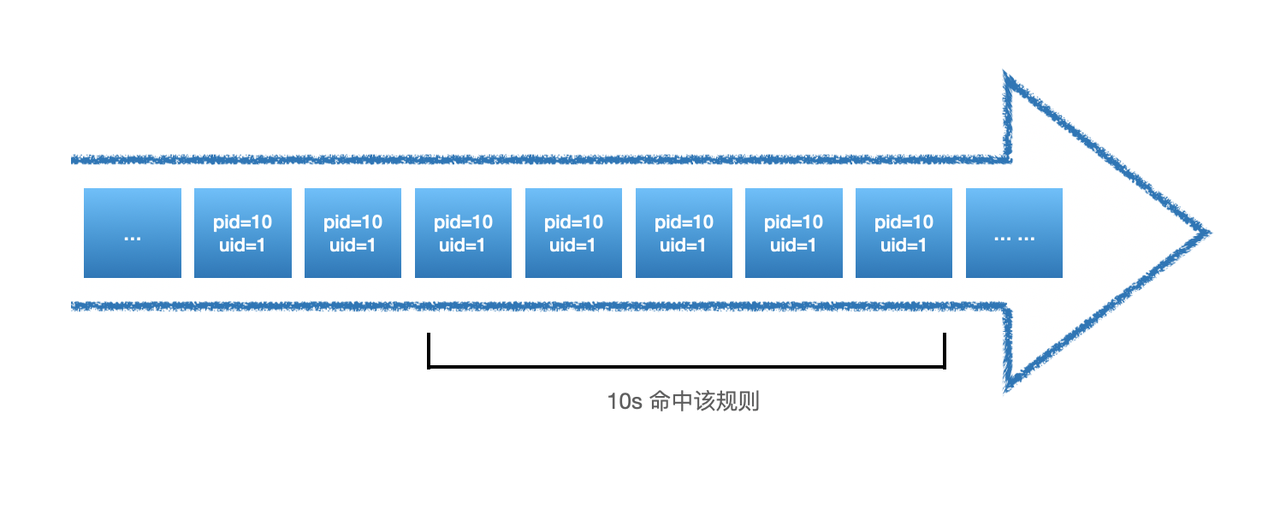

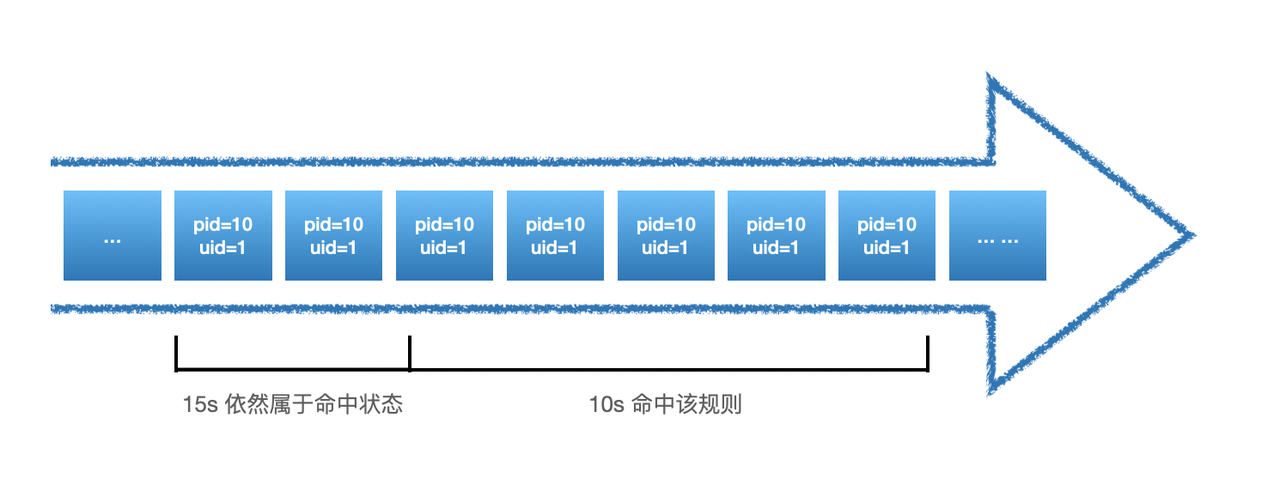

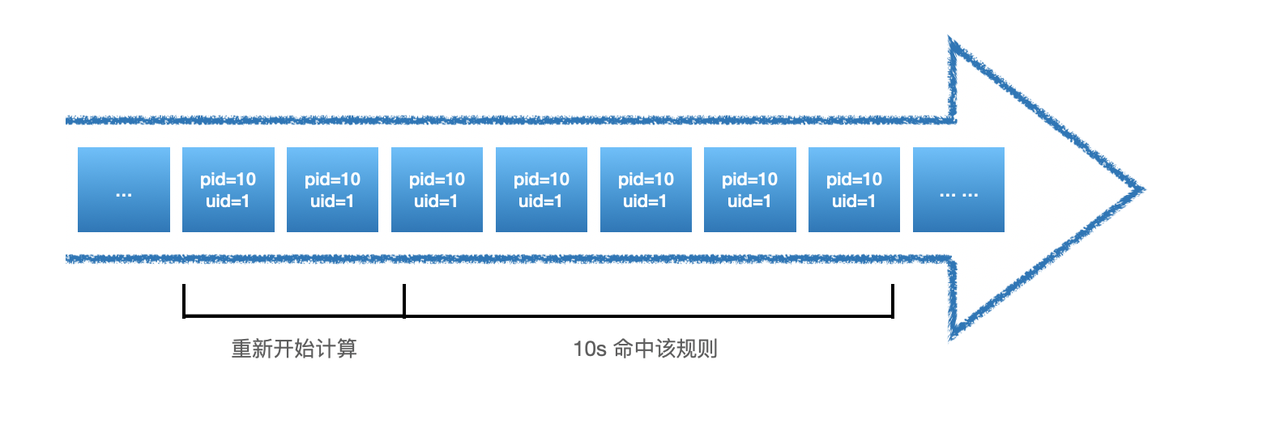

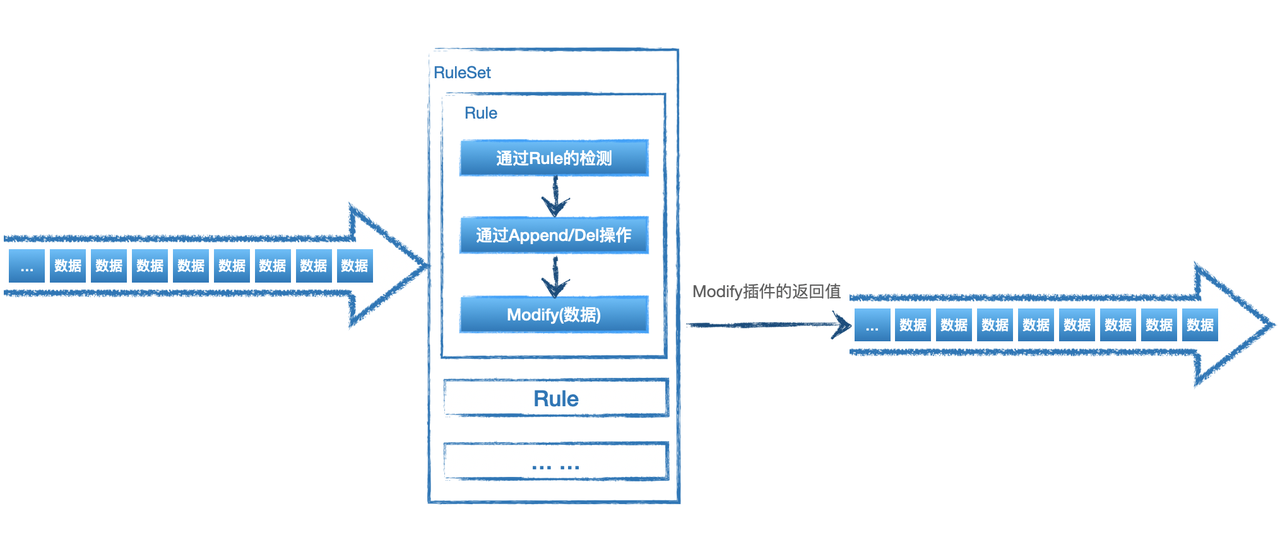

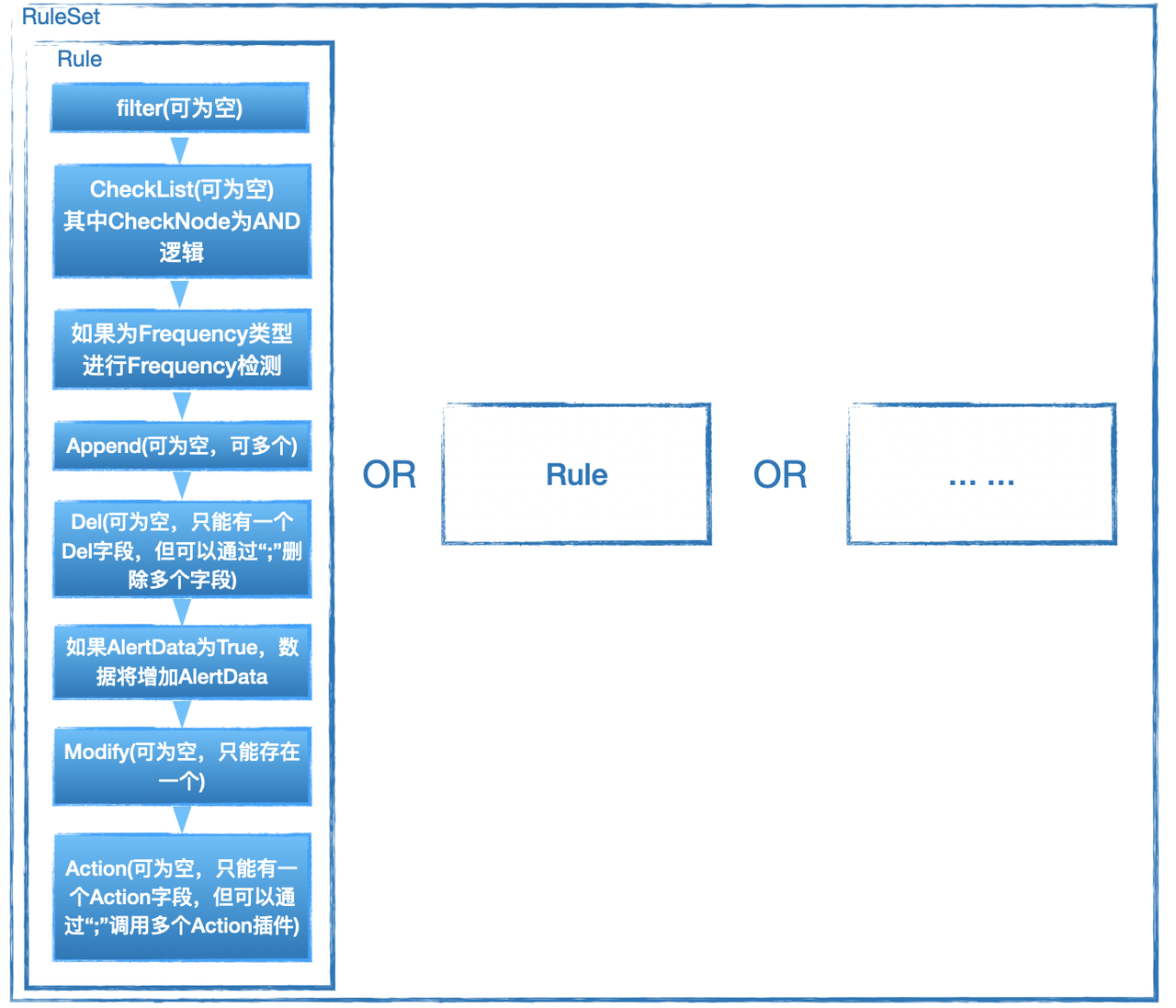

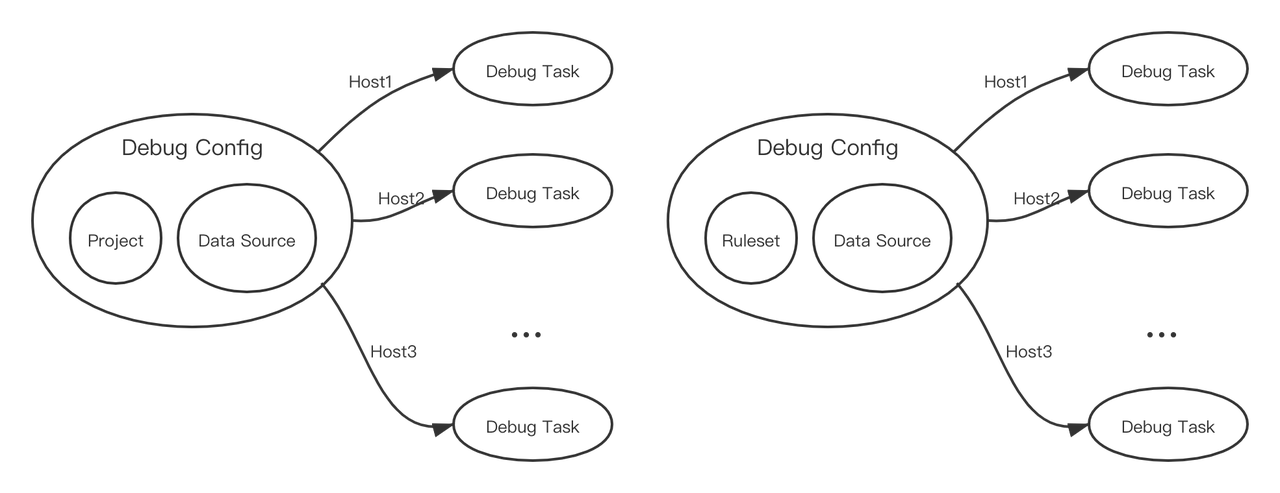

RuleSet是HUB实现检测/响应的核心部分,可以根据业务需要对输入的数据进行检测响应,配合插件还能实现报警的直接推送或对消息的进一步处理。因此如果有额外的业务需要可能需要自行编写部分规则。

RuleSet是通过XML格式来描述的规则集,RuleSet分为两种类型rule 和 whitelist。rule为如果检测到会继续向后传递,whitelist则为检测到不向后传递,向后传递相当于检出,因此whitelist一般用于白名单。

Ruleset里可以包含一条或多条rule,多个rule之间的关系是'或'的关系,即如果一条数据可以同时命中多条rule。

使用前端编写规则

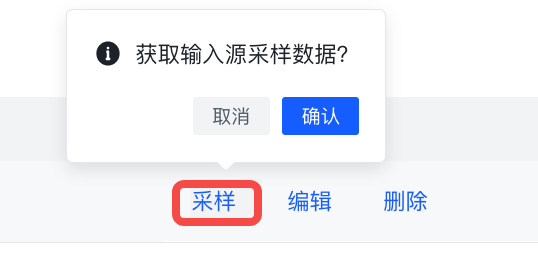

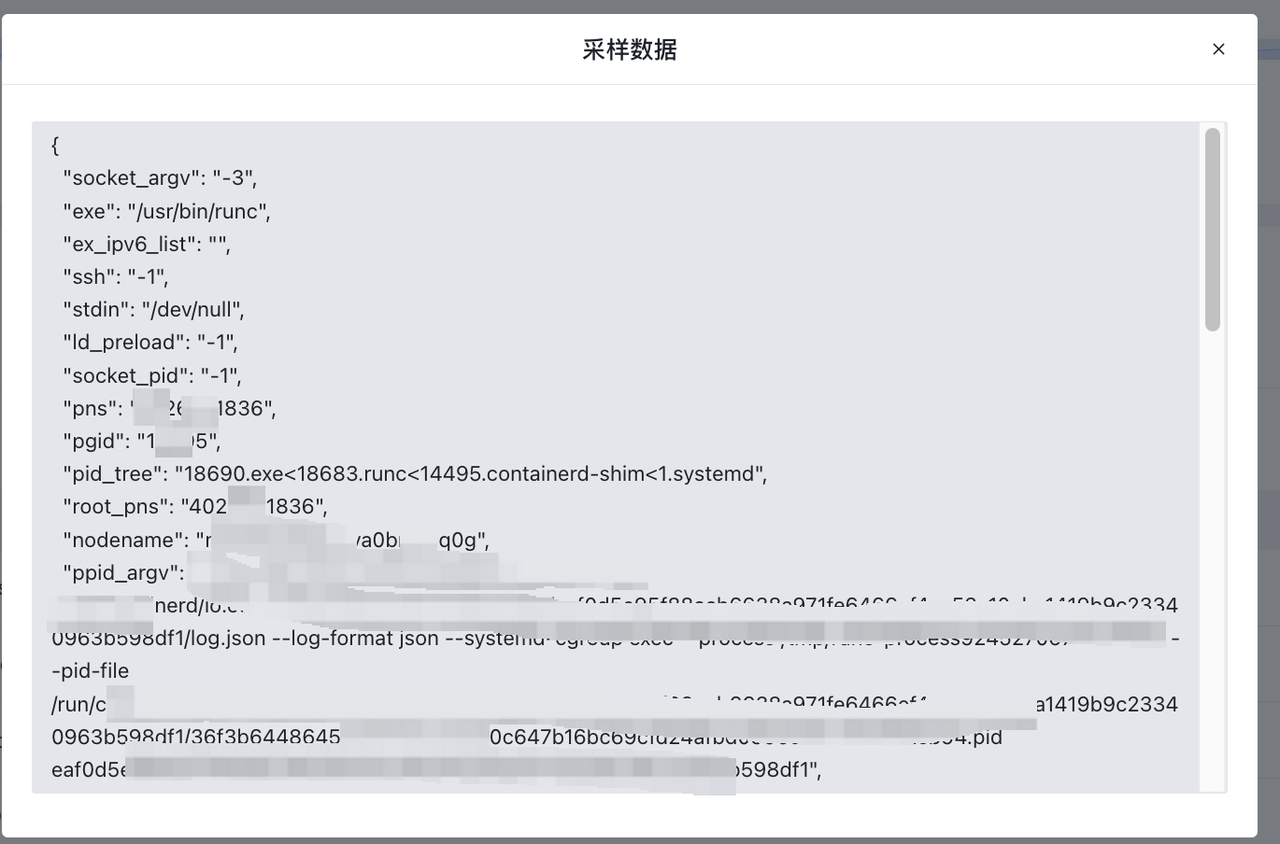

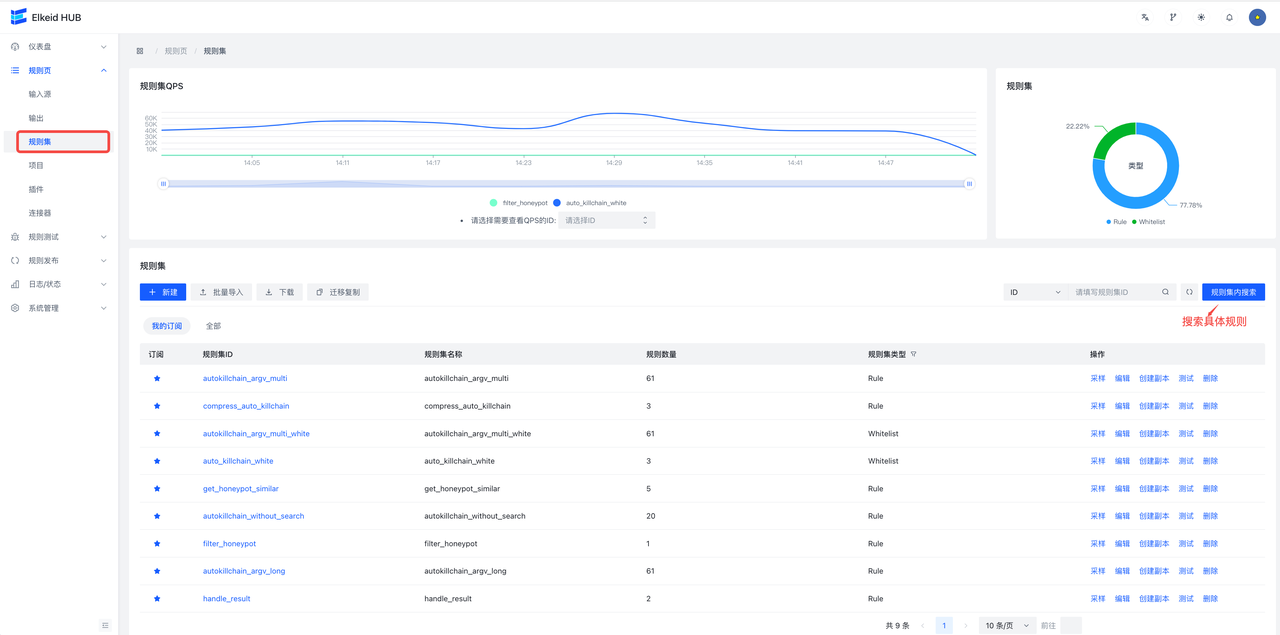

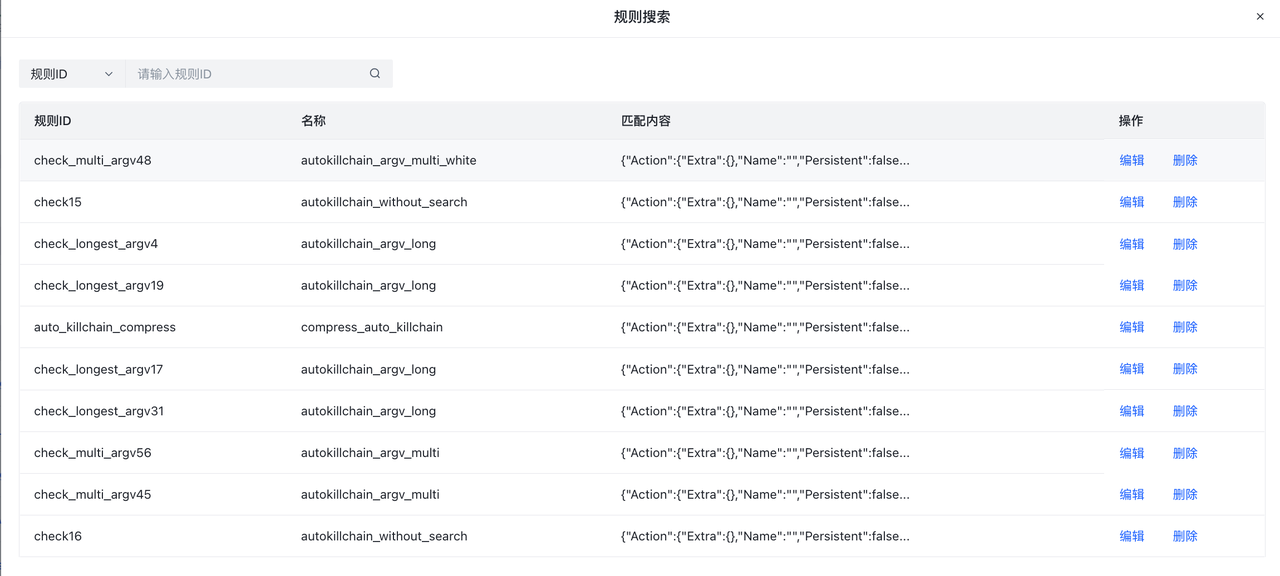

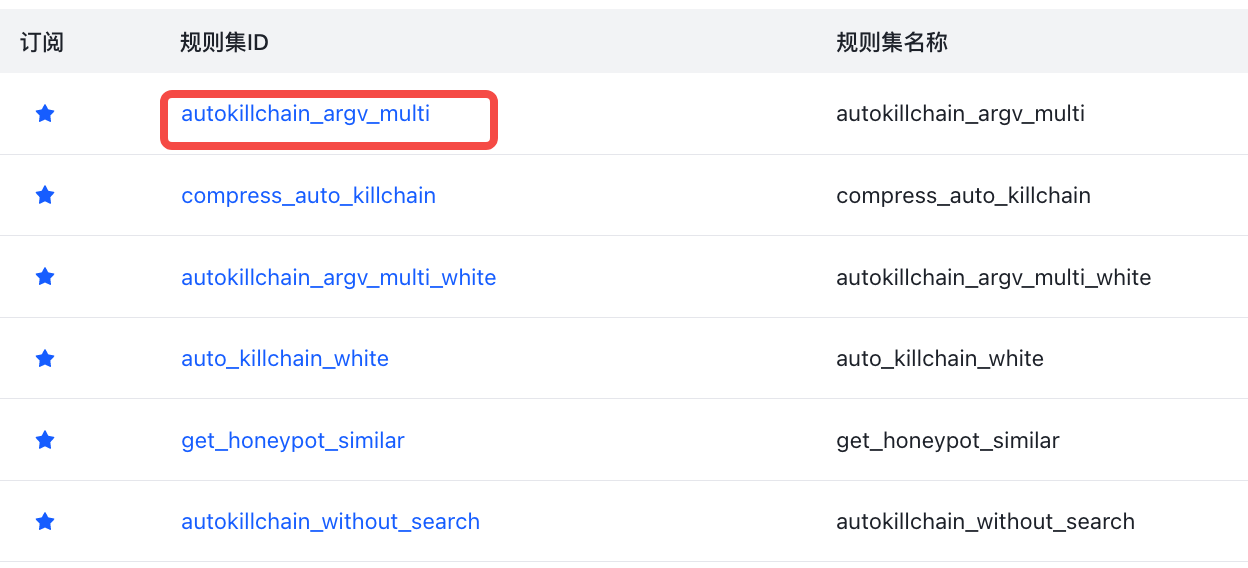

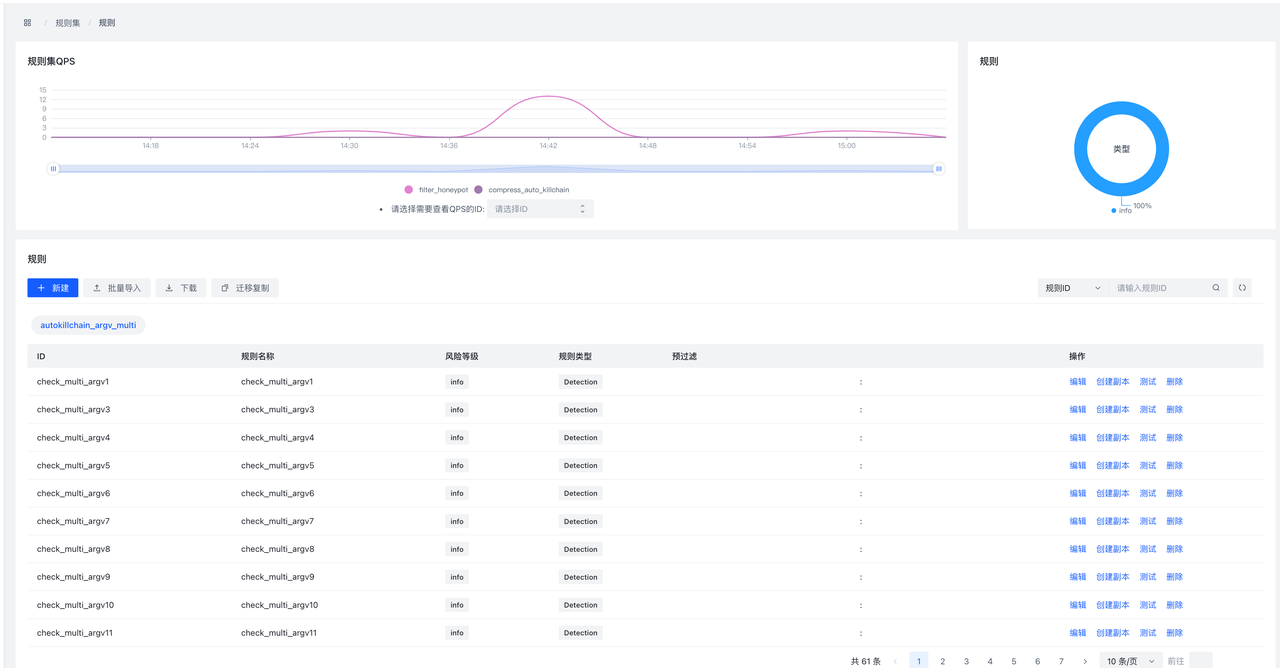

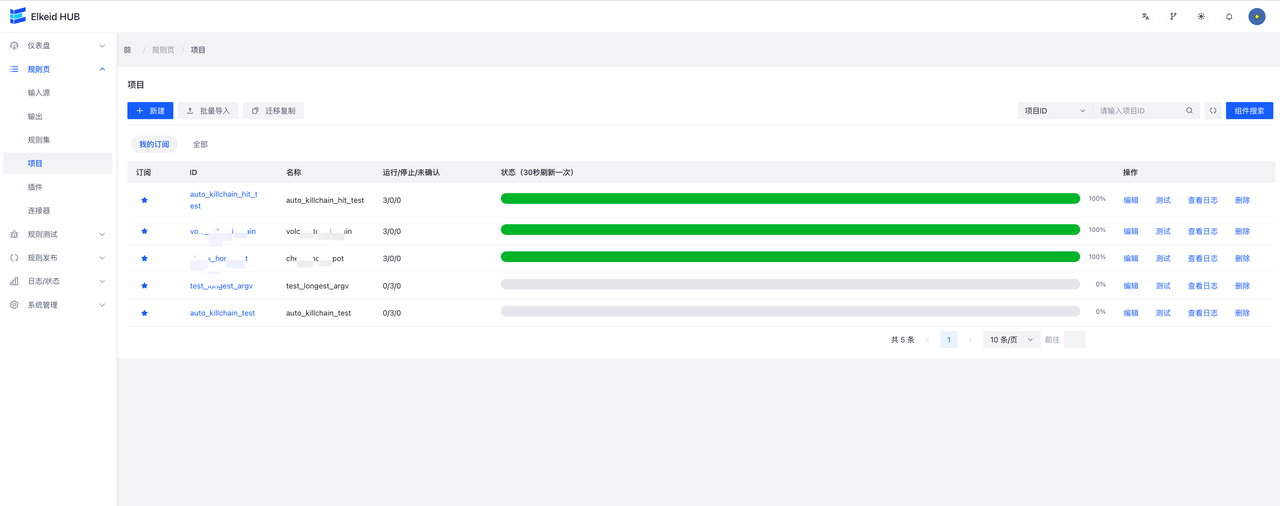

进入规则页->规则集页面,可以看到当前收藏的RuleSet和全部RuleSet。

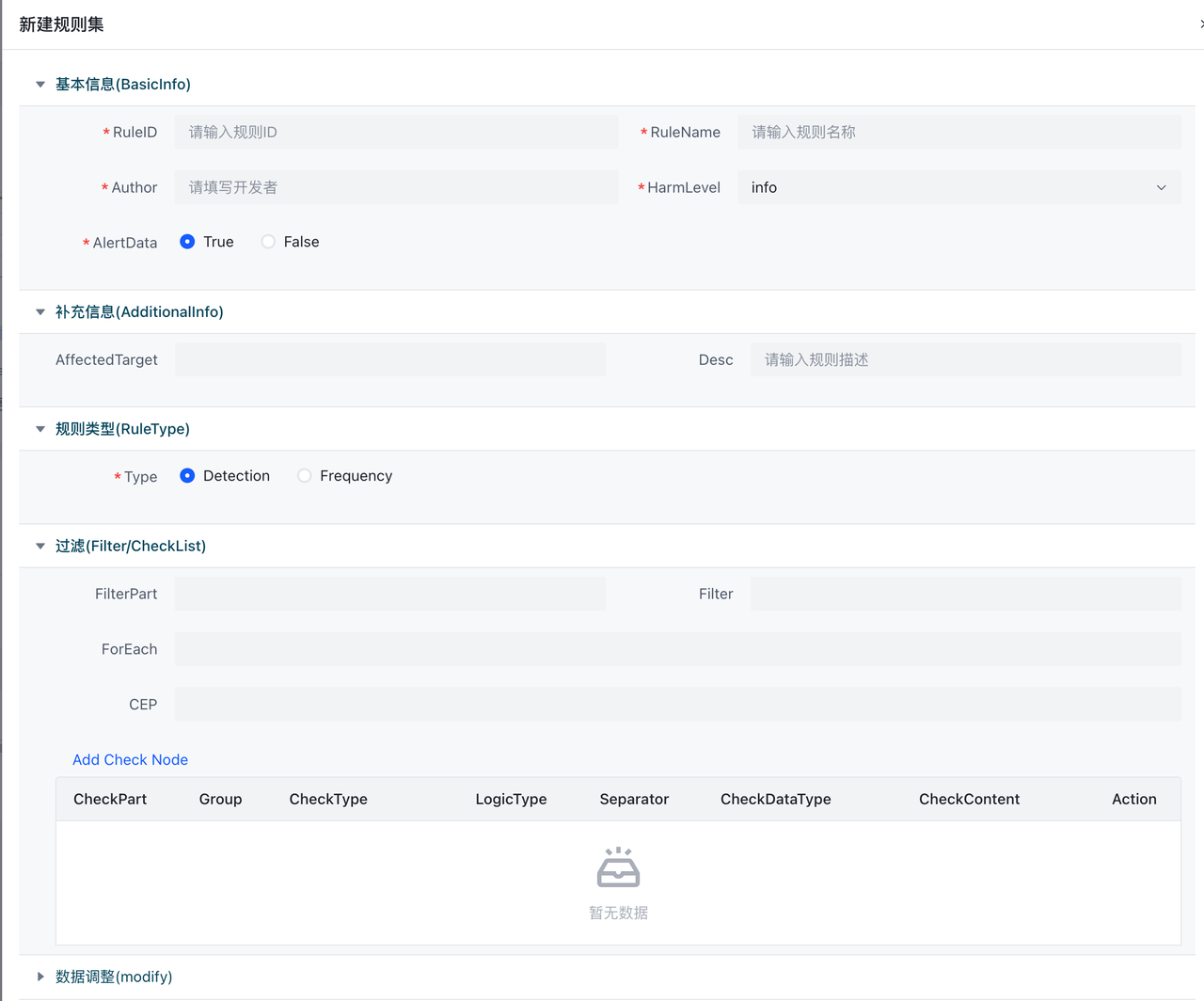

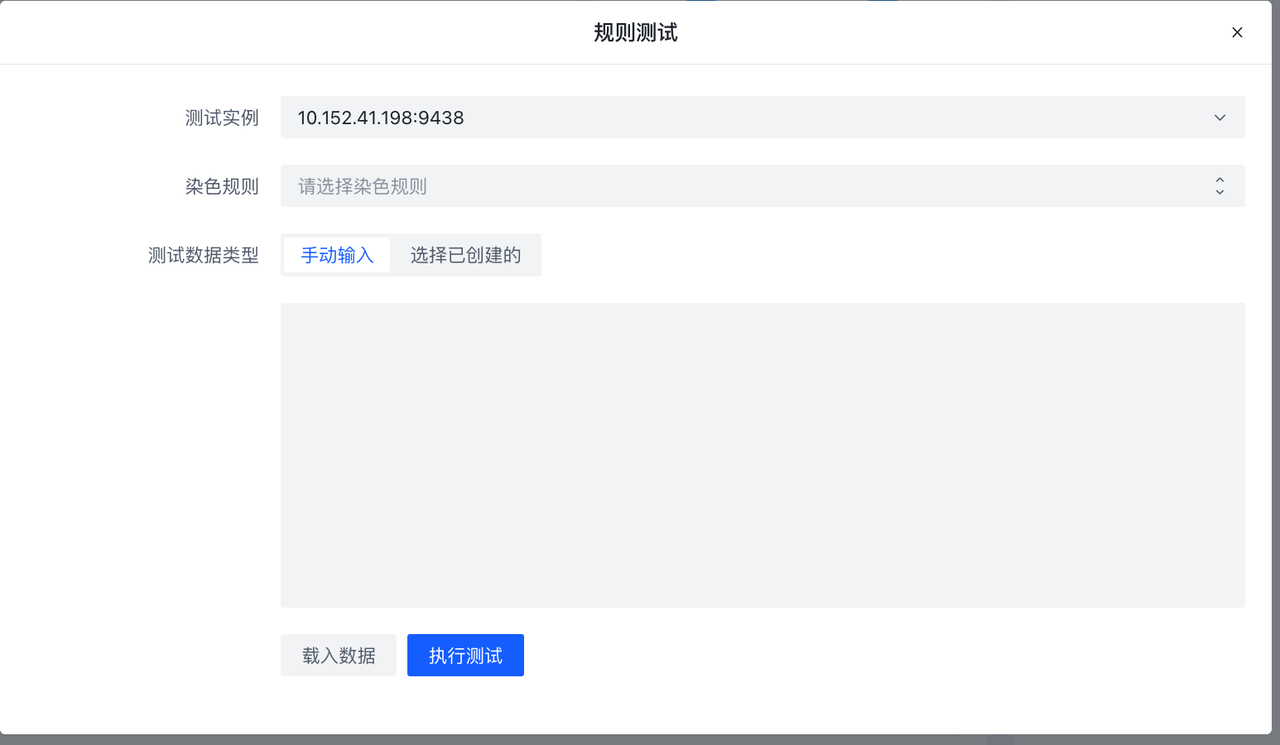

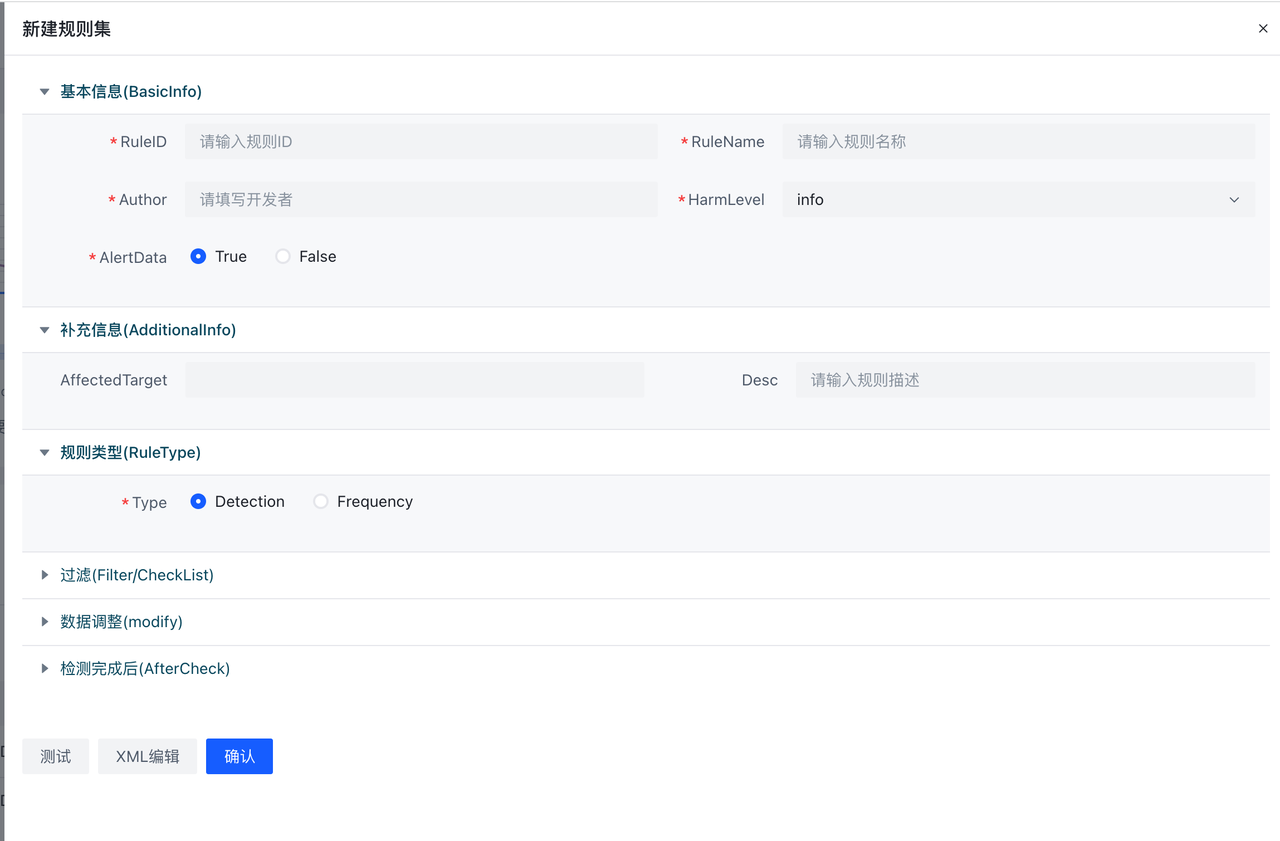

当Type为Rule时会出现未检测时丢弃字段,意味未检测到是否丢弃,默认是True即为未检测到即丢弃,不向下传递,在这里我们设为True。创建完成后,在创建好的条目上点击规则按钮,进入该Ruleset详情。在RuleSet详情中点击新建会弹出表单编辑器。

HUB已经默认开放了数十条规则,可以查看已经编写的规则,进行相关策略编写

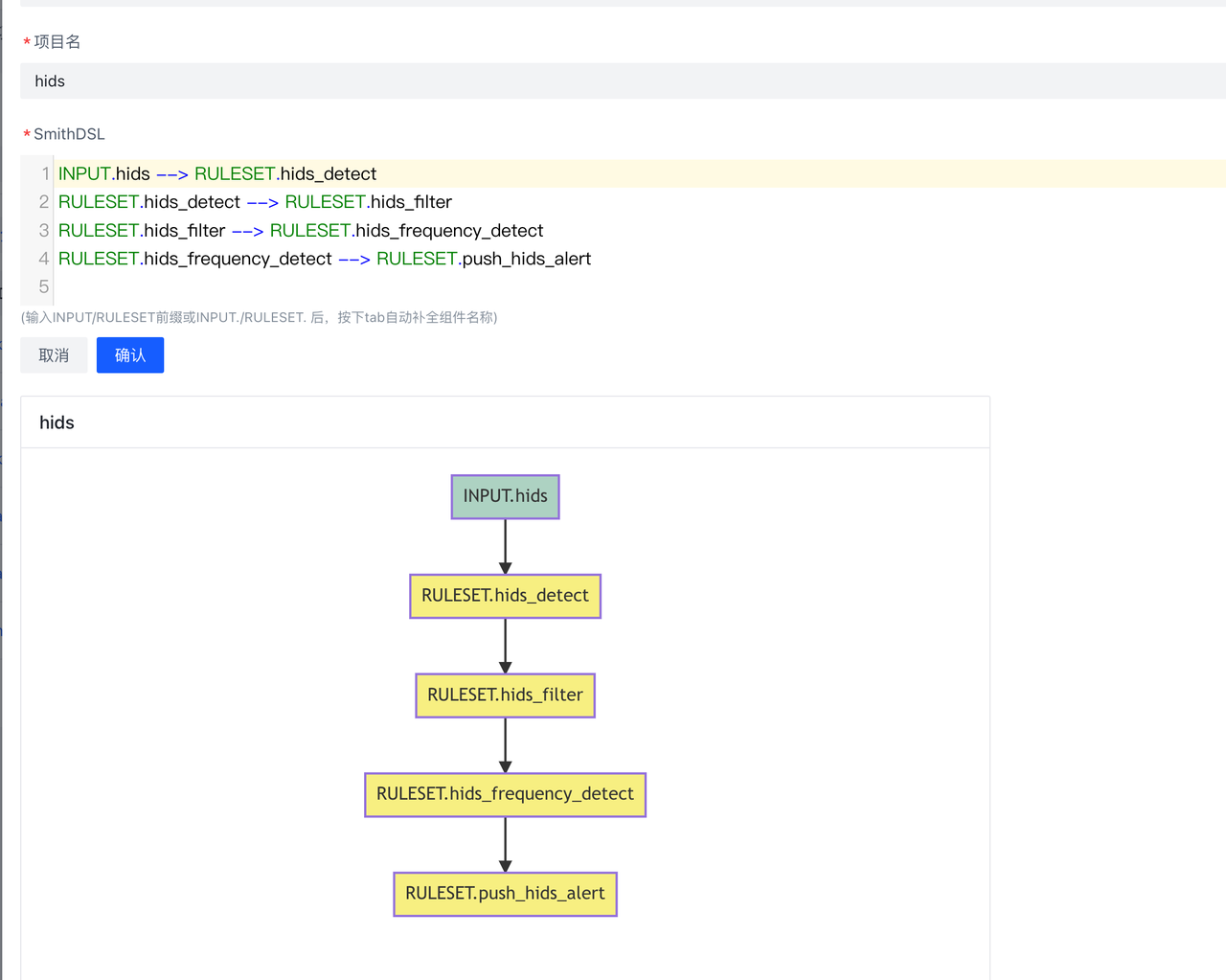

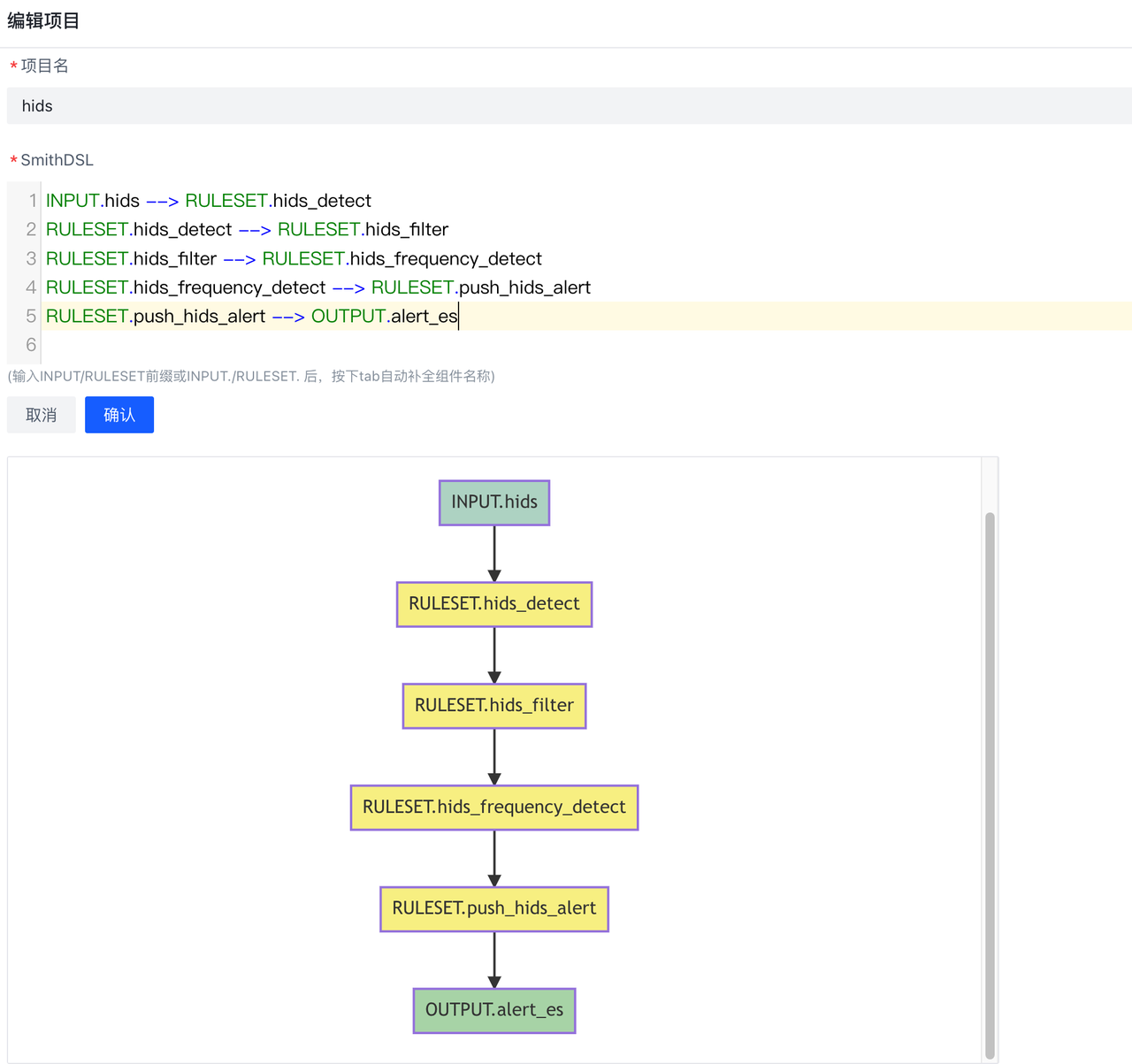

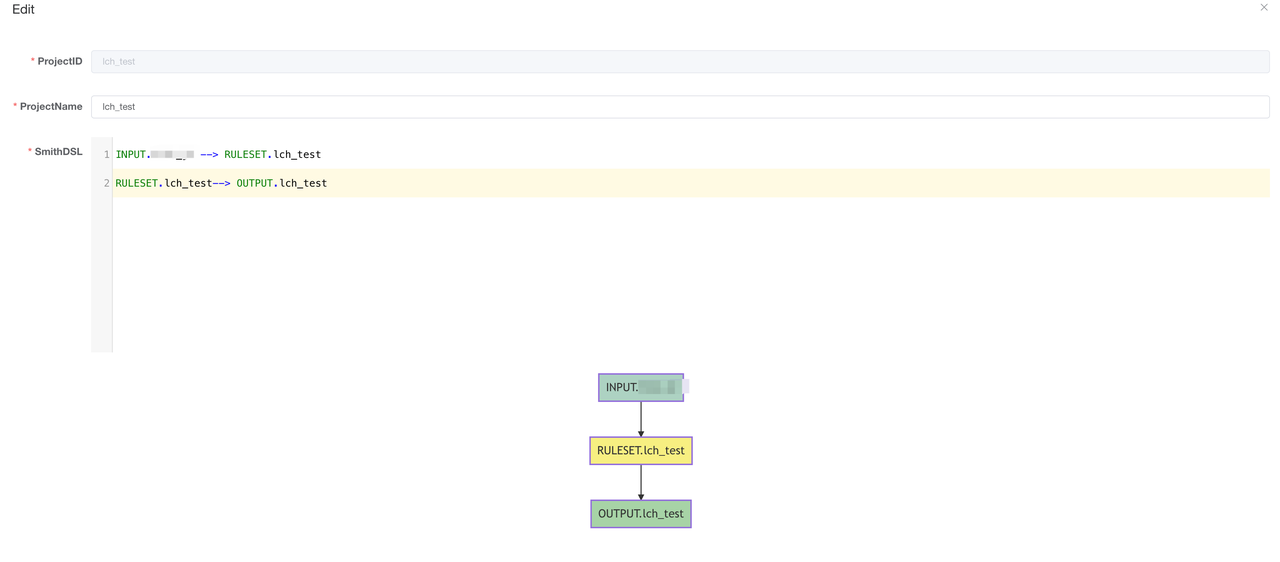

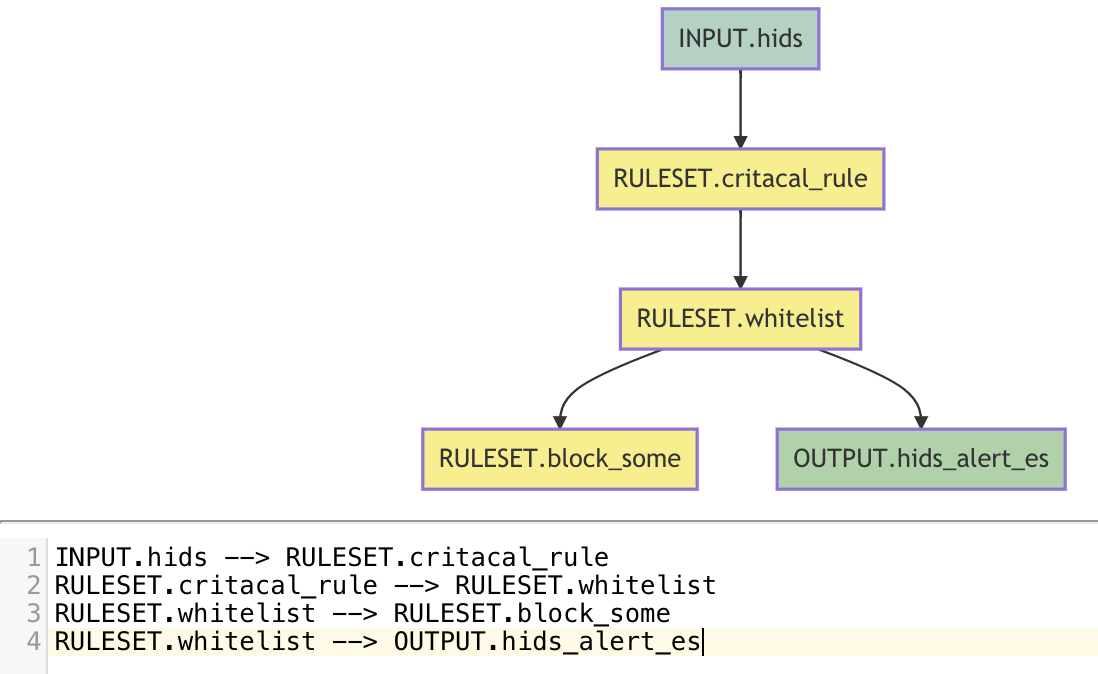

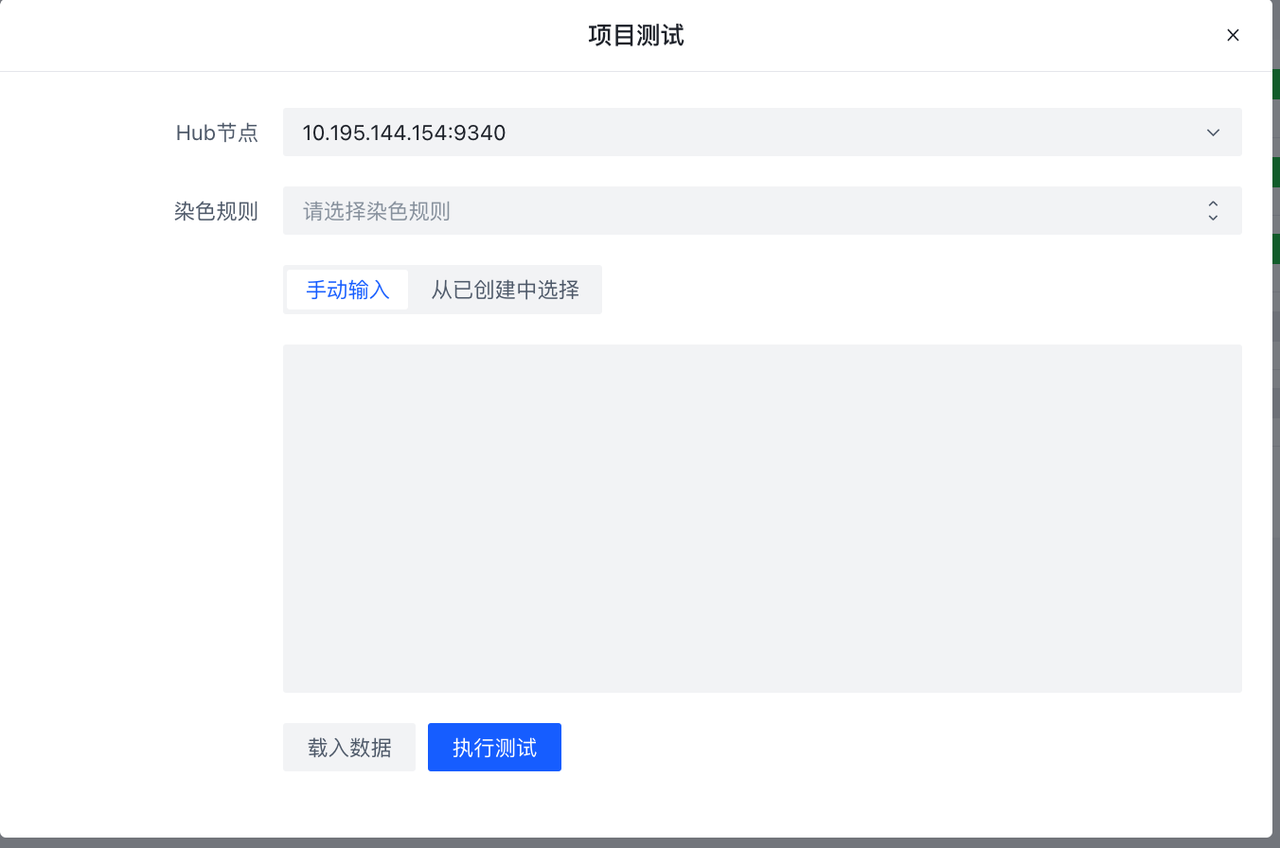

也可以根据Elkeid HUB 社区版使用手册 进行编写.编写完成后,可以在项目页新建project,将编写好的规则与输入输出进行组合.

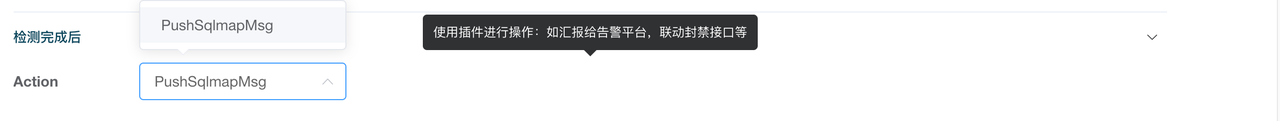

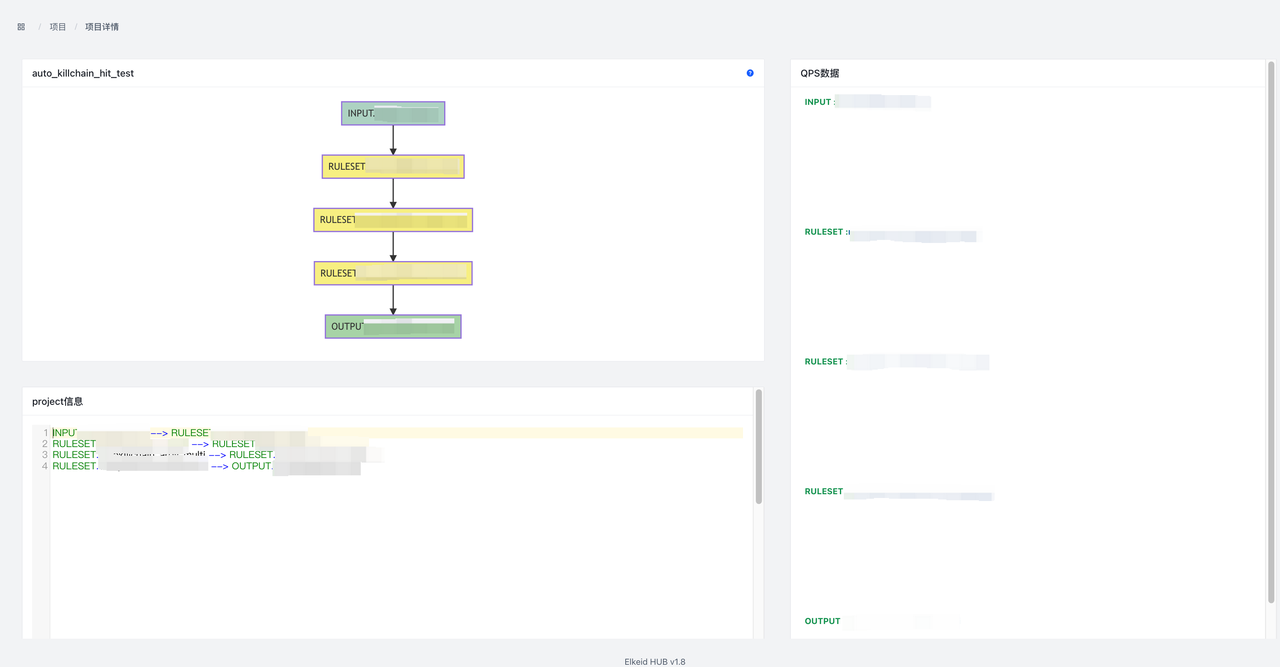

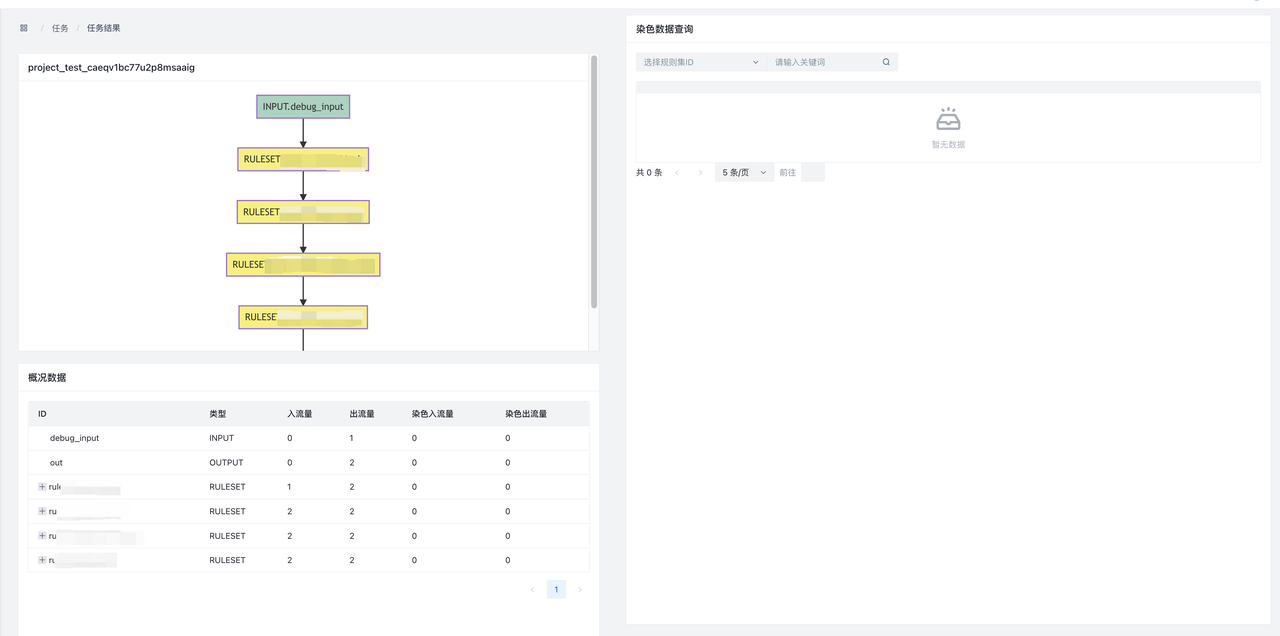

下图即为hids告警处理的过程:数据按照dsl的顺序,依次经过RULESET.hids_detect、RULESET.hids_filter等规则进行处理,最后再通过RULESET.push_hids_alert推送到CWPP console.

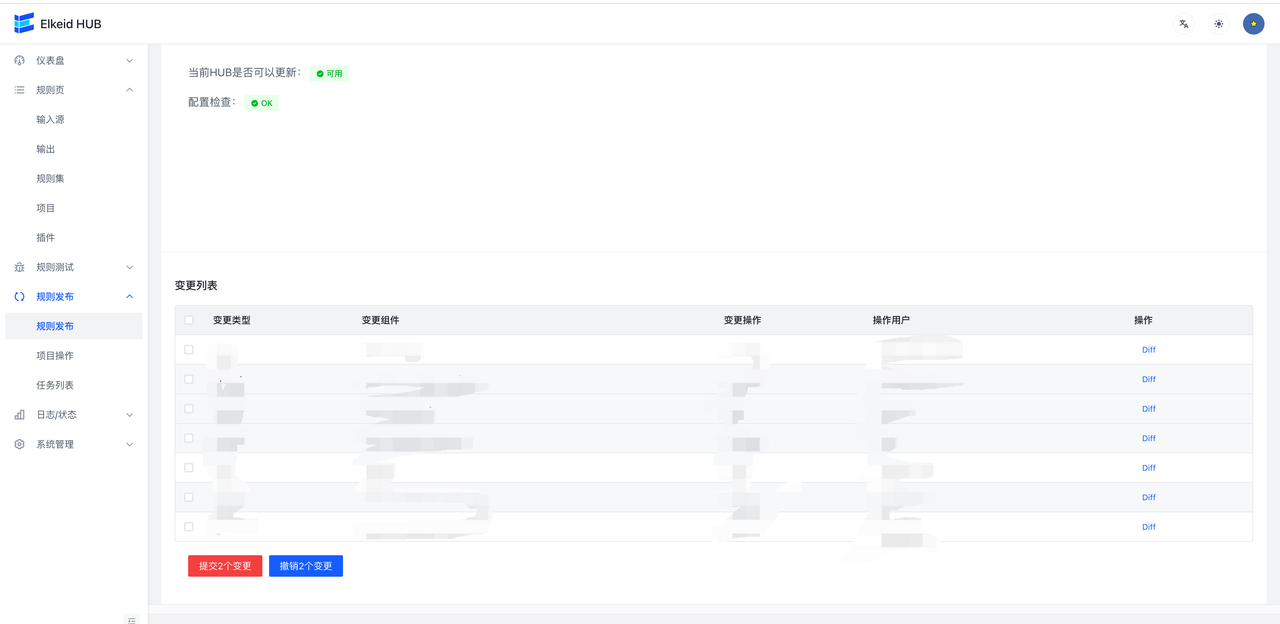

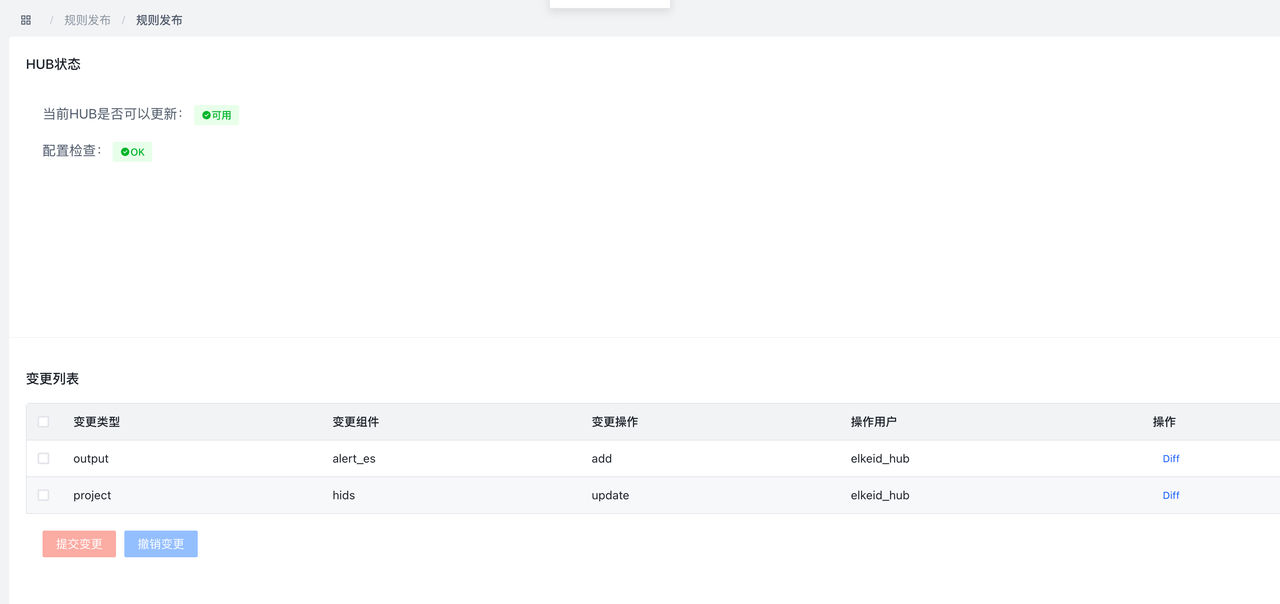

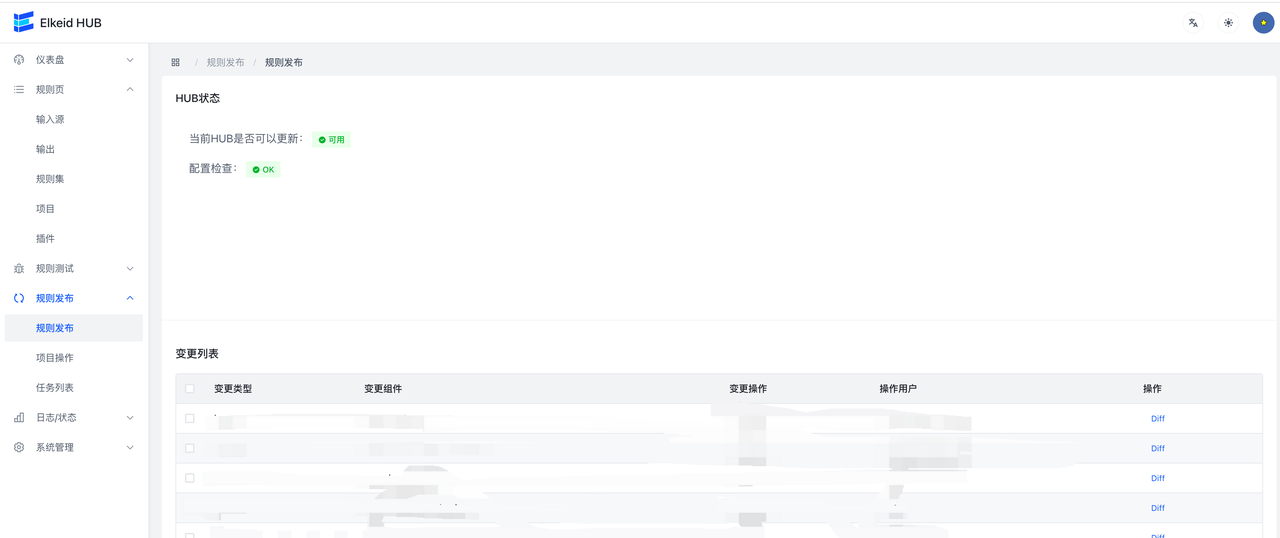

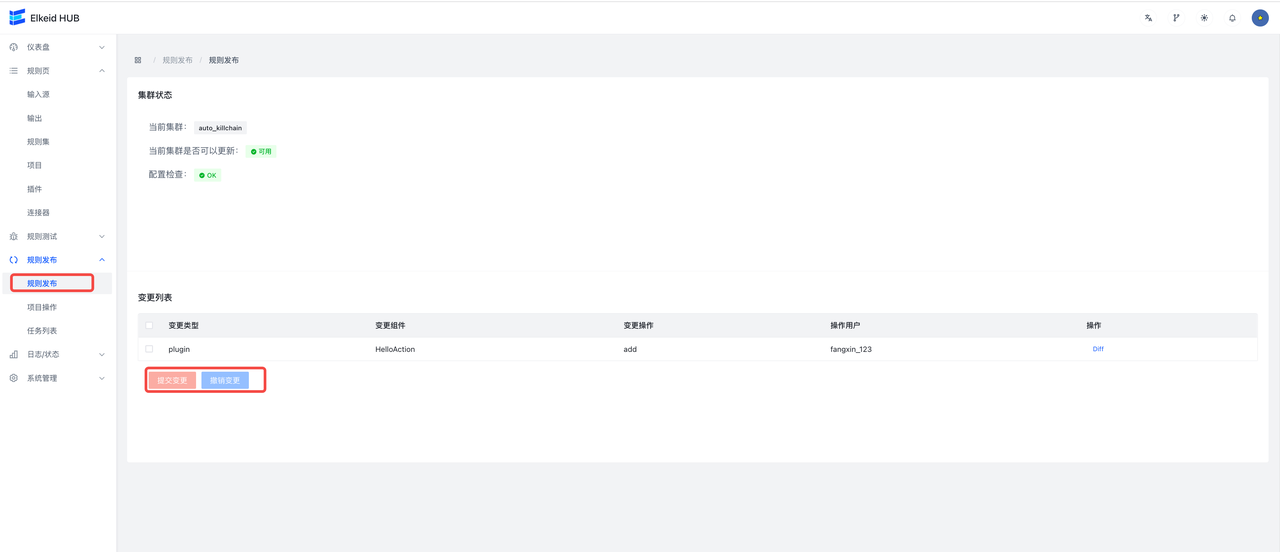

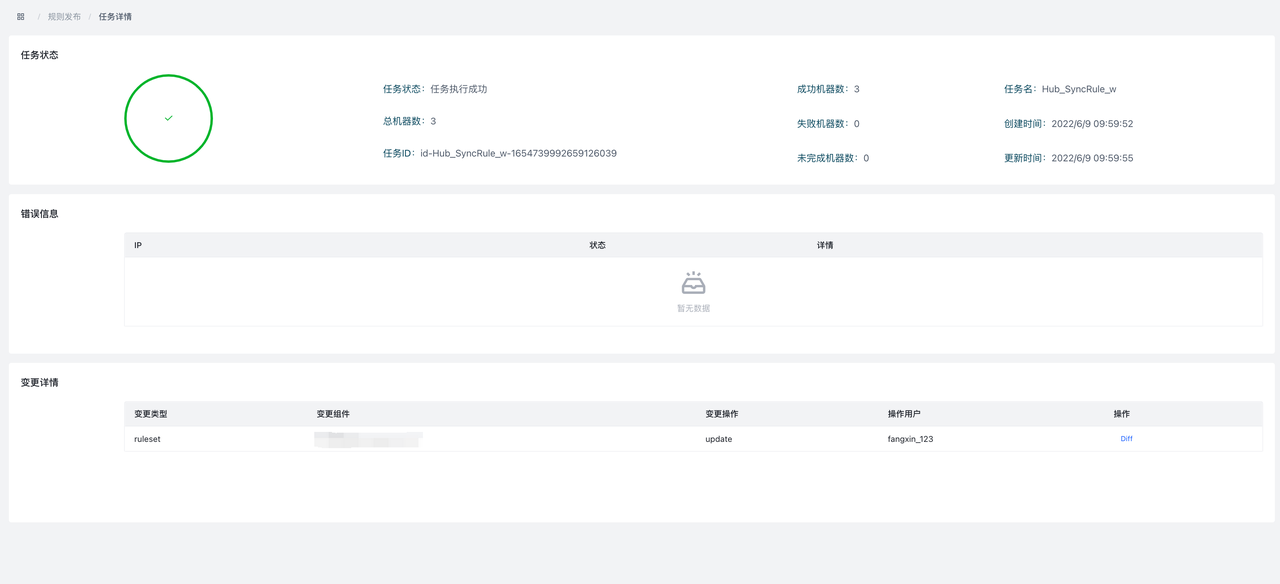

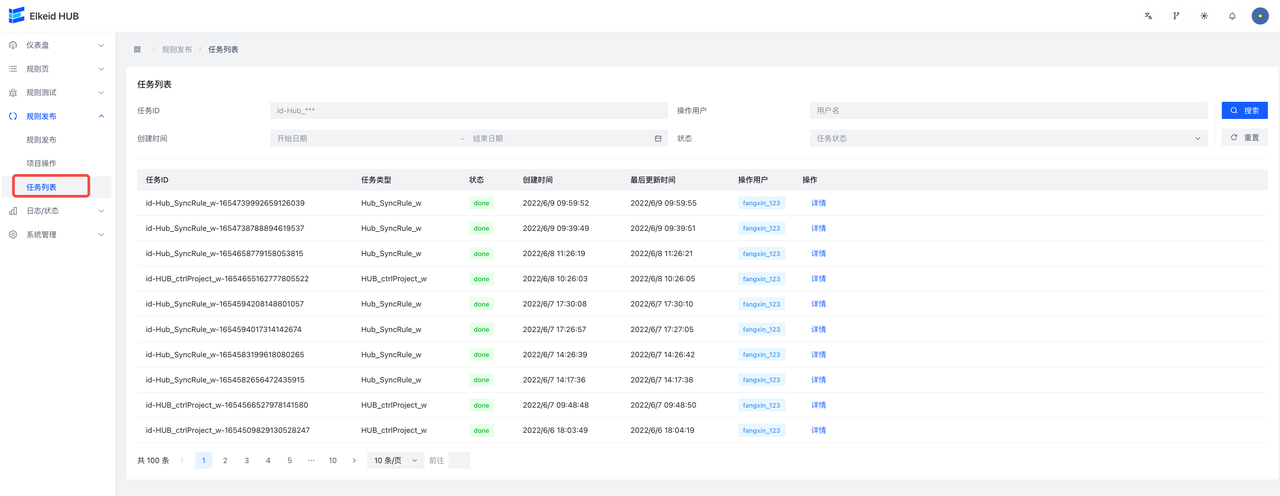

完成以上步骤后,进入规则发布页面,会显示出刚才修改的全部内容,每一个条目对应着一个组件修改,点击 Diff 可以查看修改详情。检查无误后,点击提交,将变更下发到HUB集群。

任务提交后,会自动跳转到任务详情页面,显示当前任务执行进度。

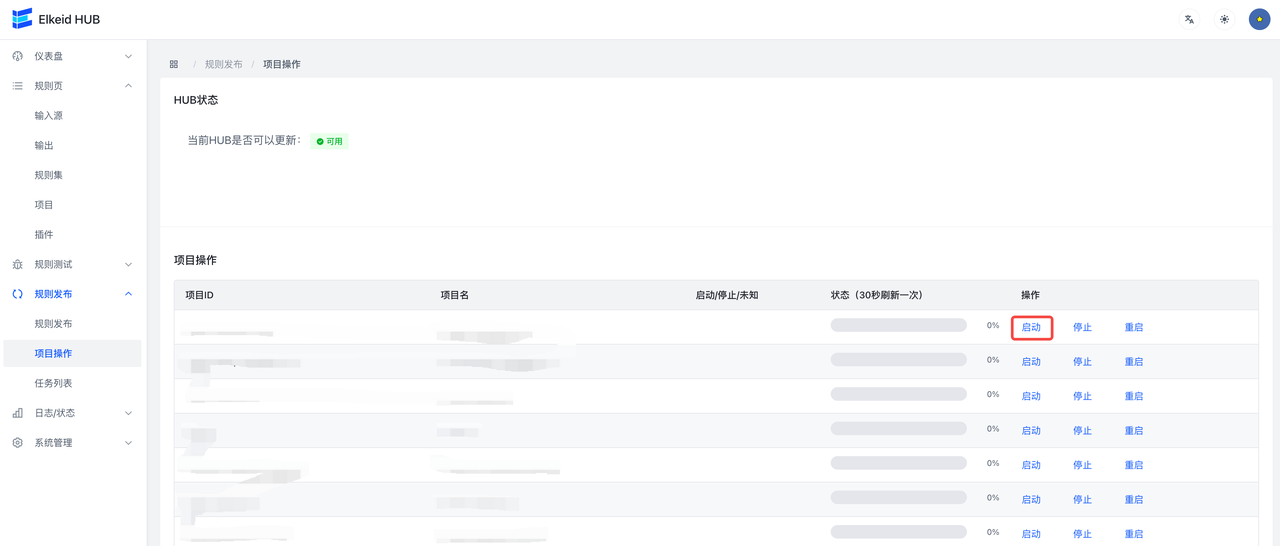

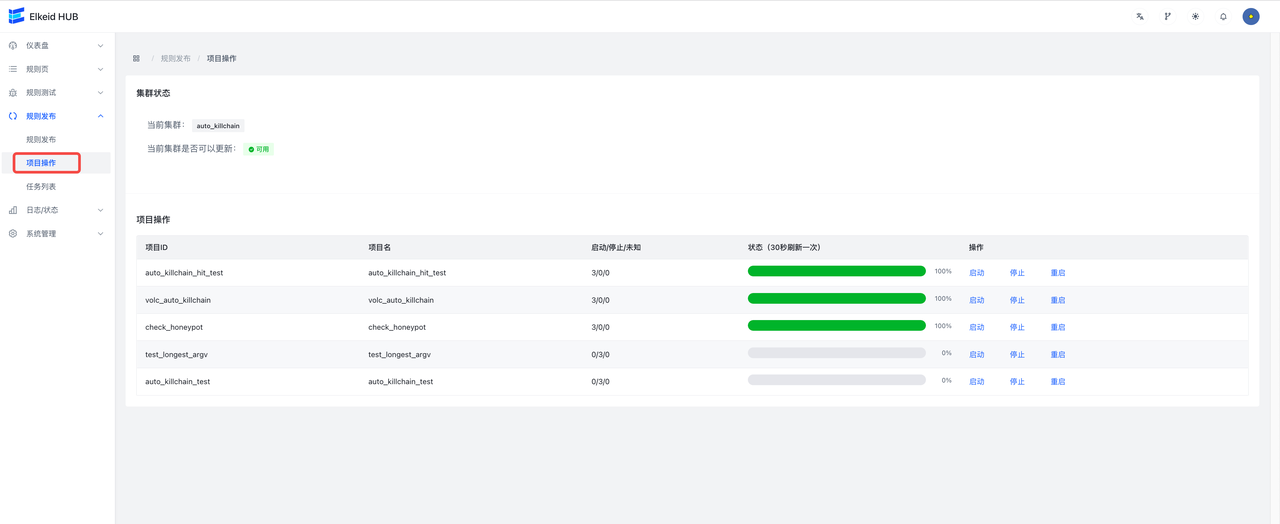

配置下发完成后,需要启动刚才新建的两个项目,进入规则发布->项目操作页面,分别启动全部已有的 项目。

进阶操作

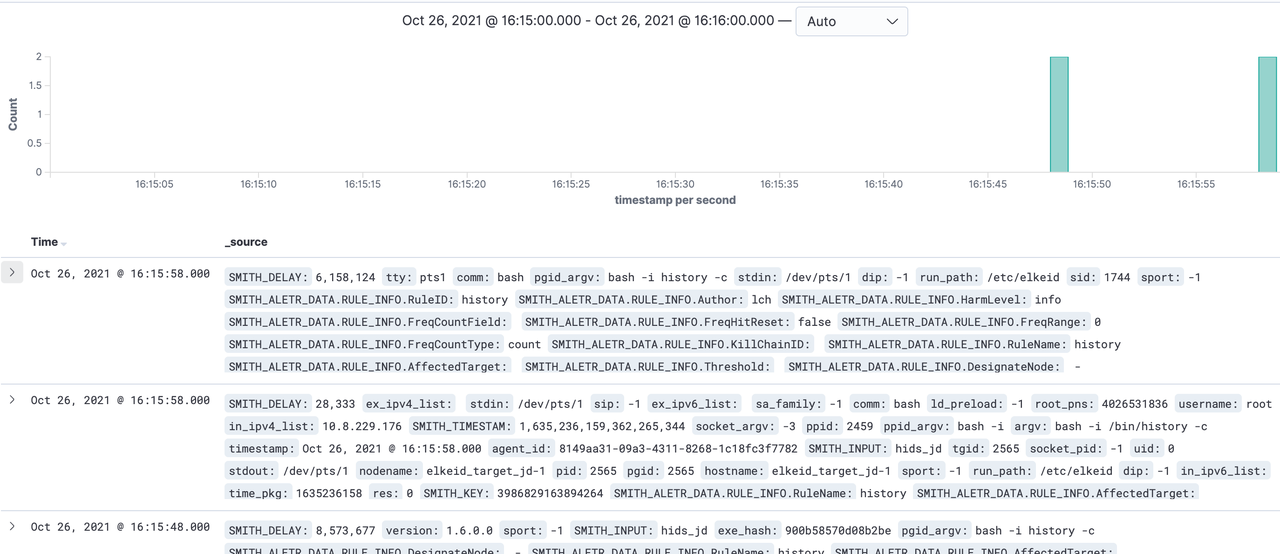

配置ES Index查看报警

此步骤适用于OutputType使用ES的用户,Kafka用户可以自行配置。

| 建议先使用反弹shell等恶意行为触发一下告警流,让至少一条数据先打入ES,从而在Kibana上可以配置Index Pattern。 |

|---|

- 在输出页配置es类型的输出,可开启AddTimestamp,方便在kibana页面配置相关索引

- 编辑hids项目,加入刚编些好的es输出

- 提交变更

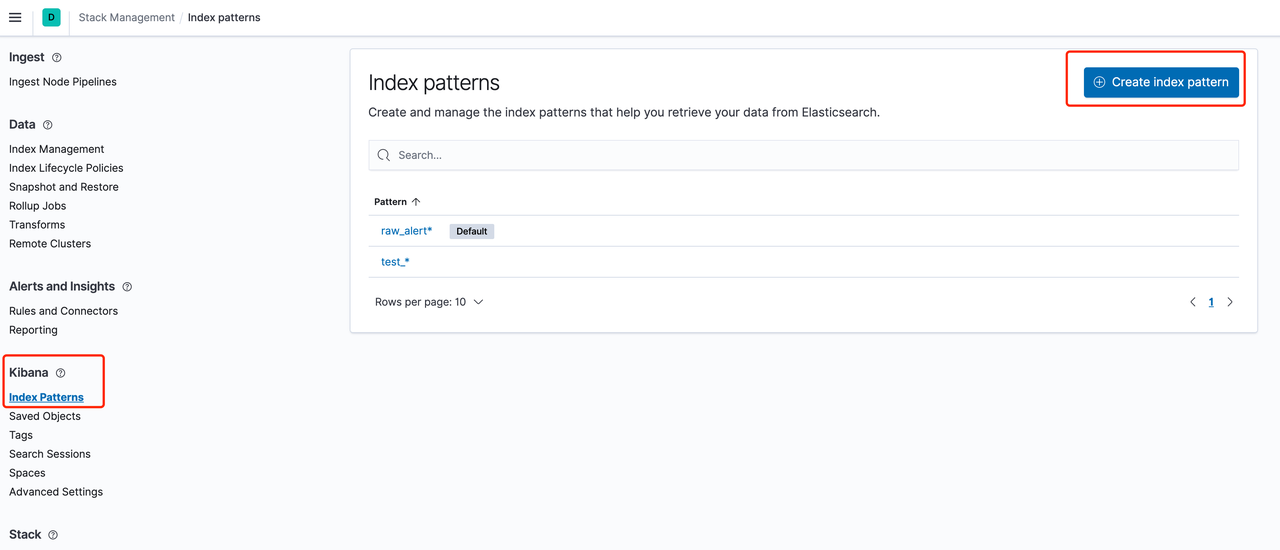

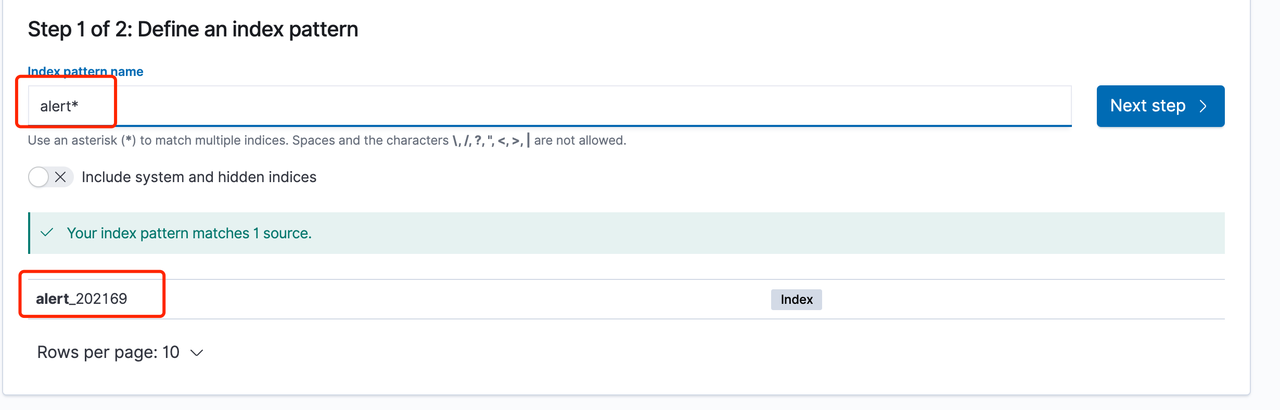

- 首先进入ES 的 stack management,选择kibana 的index patterns,点击 create index patten

- 输入之前填入的ES output index name,以星号 * 作为后缀,这里以默认推荐优先,分别为alert 或者 raw_alert

- 如果这时index中存在数据(即已经触发过告警流),那么应能正确匹配到alert或者 raw_alert index

- 配置时间字段

- 如果这时index中存在数据(即已经触发过告警流),那么应能正确匹配到timestamp字段,否则此处无下拉选择框

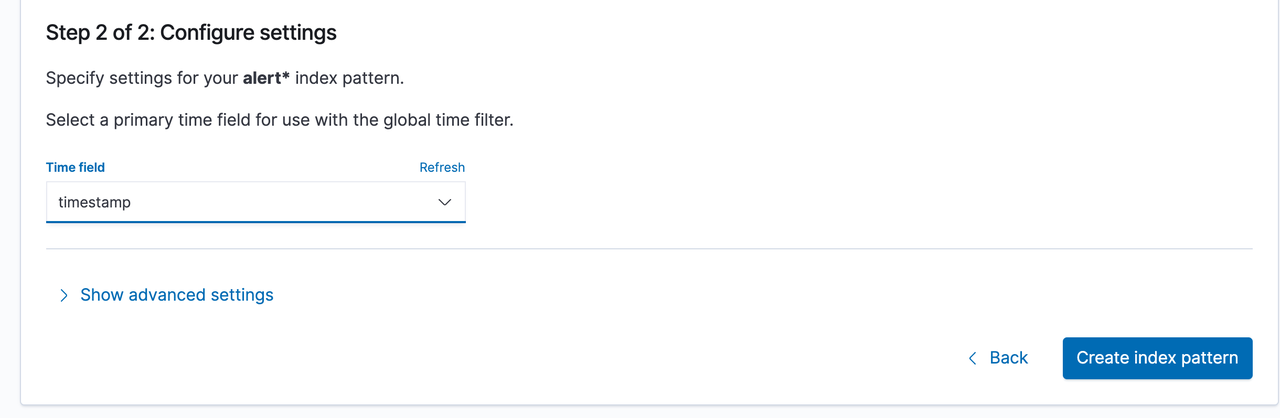

- 去浏览数据

- 进入discover 看板,选择刚才创建的 alert* 看板,调整右侧时间,即可看到告警

示例

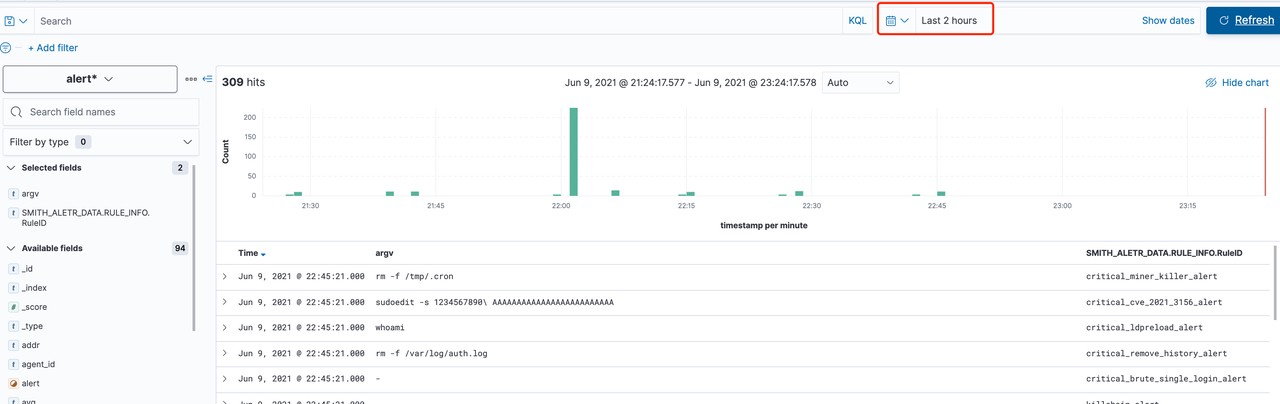

sqlmap检测规则编写

在本教程中,会尝试在前端中编写一条规则,为检查执行sqlmap命令的规则.

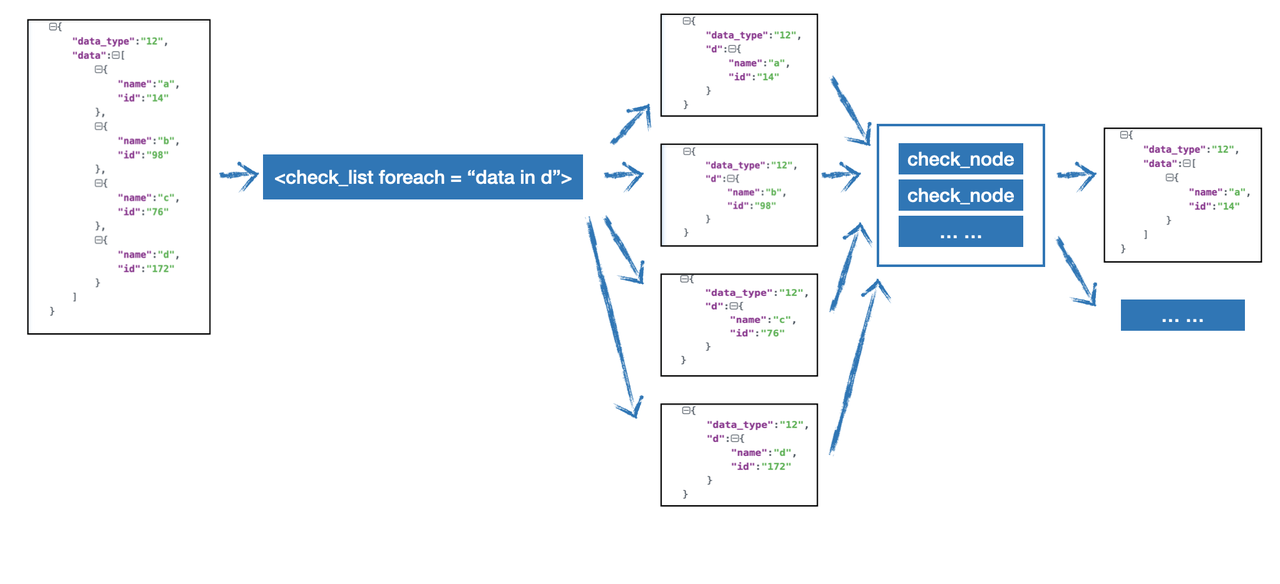

在该检测场景中,我们只需要关注Execve相关的信息,因此我添加了data_type为59的过滤字段,因此该规则只会对data_type为59的数据进行处理。之后我添加了一个CheckNode,检查数据中argv字段中是否包含'sqlmap',编写完的效果如下:

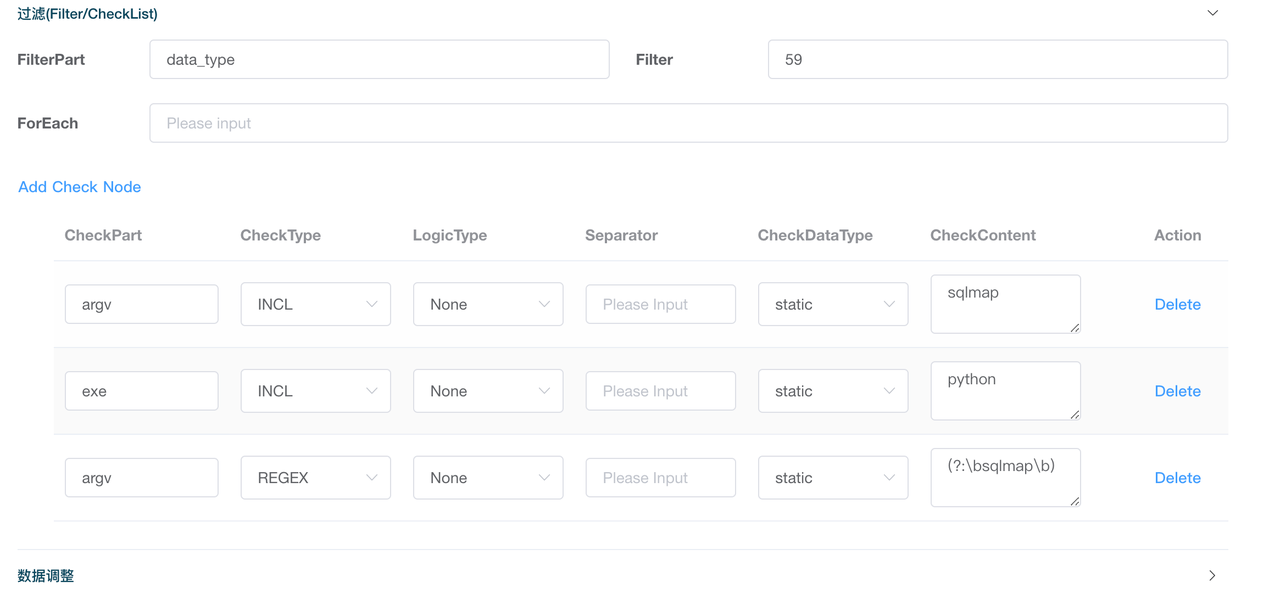

可以看到分别设置了三个CheckNode来进行检测,一是直接检测argv中是否包含sqlmap,二是检测exe字段是否包含python,三是使用正则来进行匹配是否为单独的word,当这三个同时满足,就会触发报警,编写好后,点击保存。

我们单独为该测试规则建立一个Output和Project,如下图所示:

进入测试环境执行sqlmap相关指令,在kibana中添加对应的index pattern,稍微等待一会就可以找到对应的报警结果。

可以看到出现了报警。

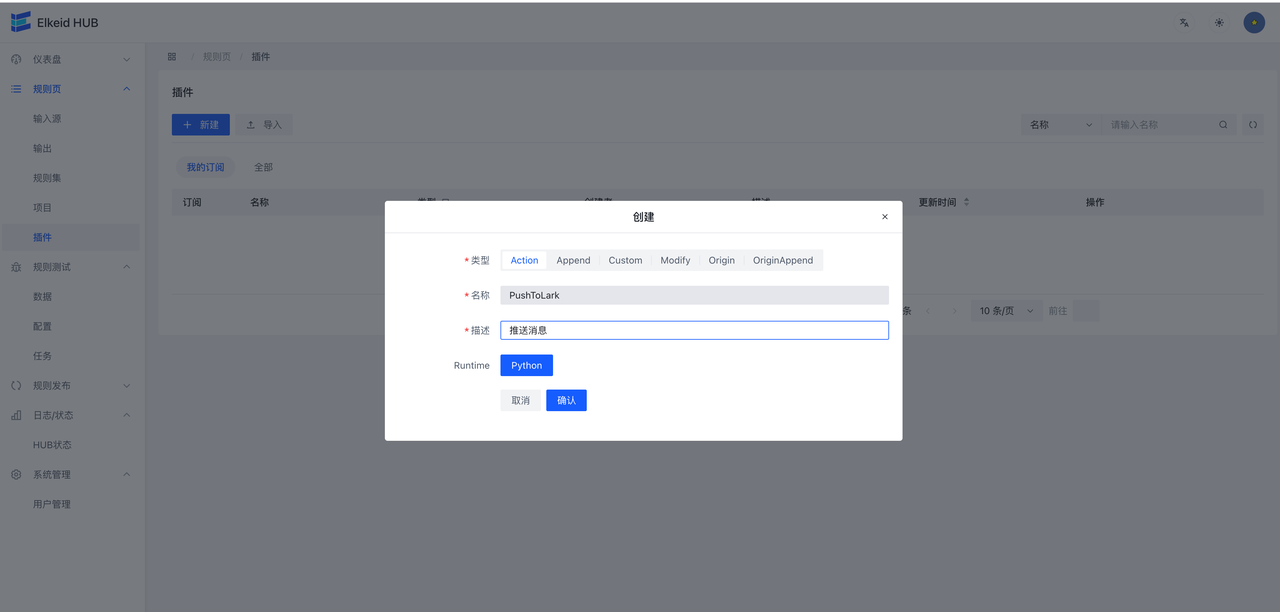

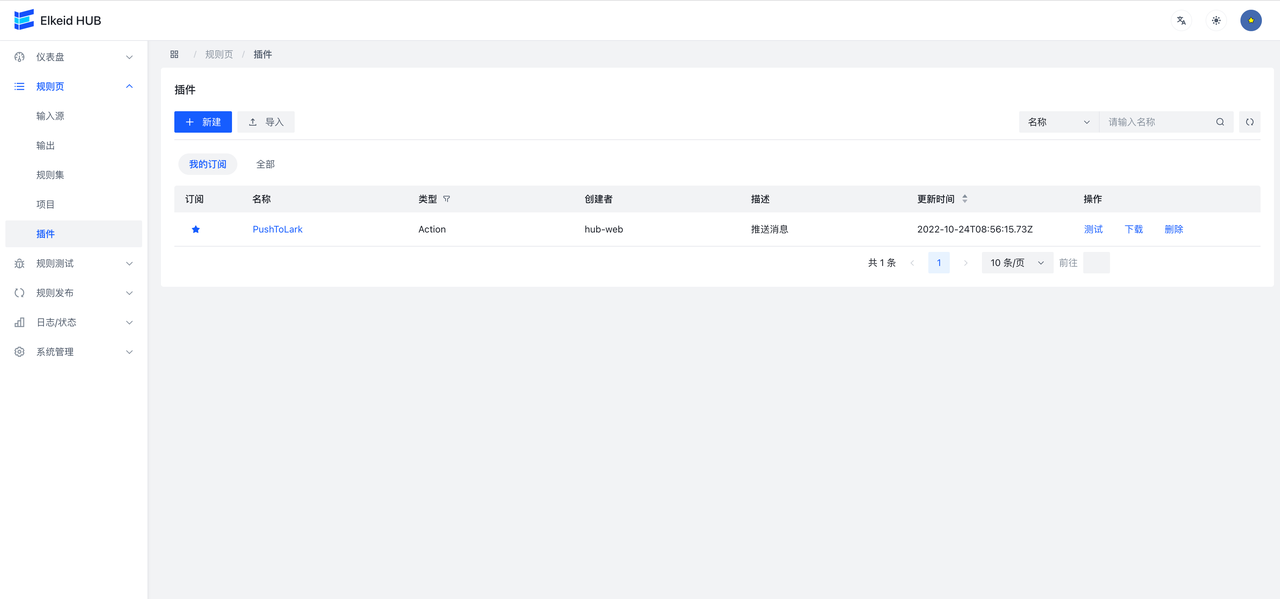

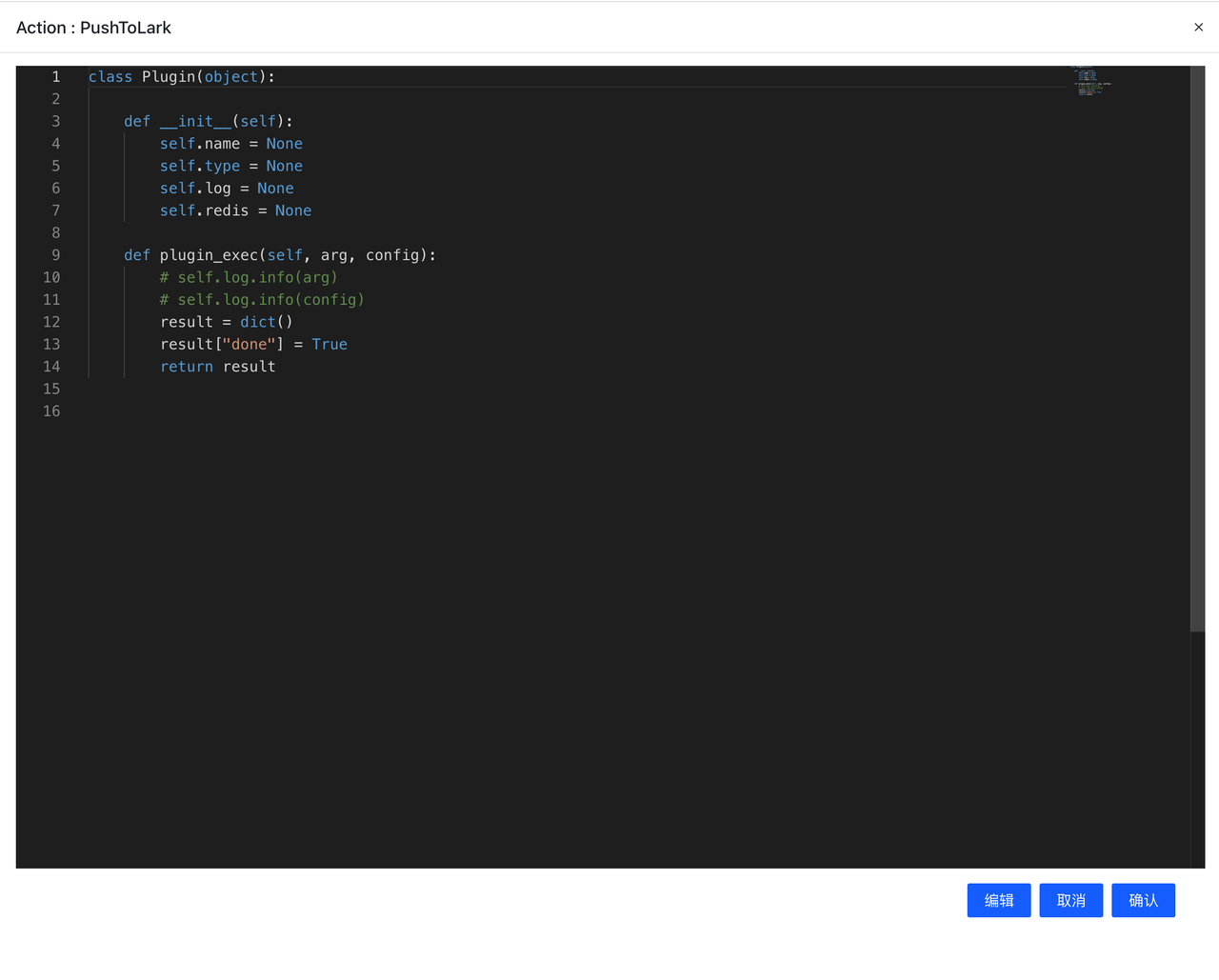

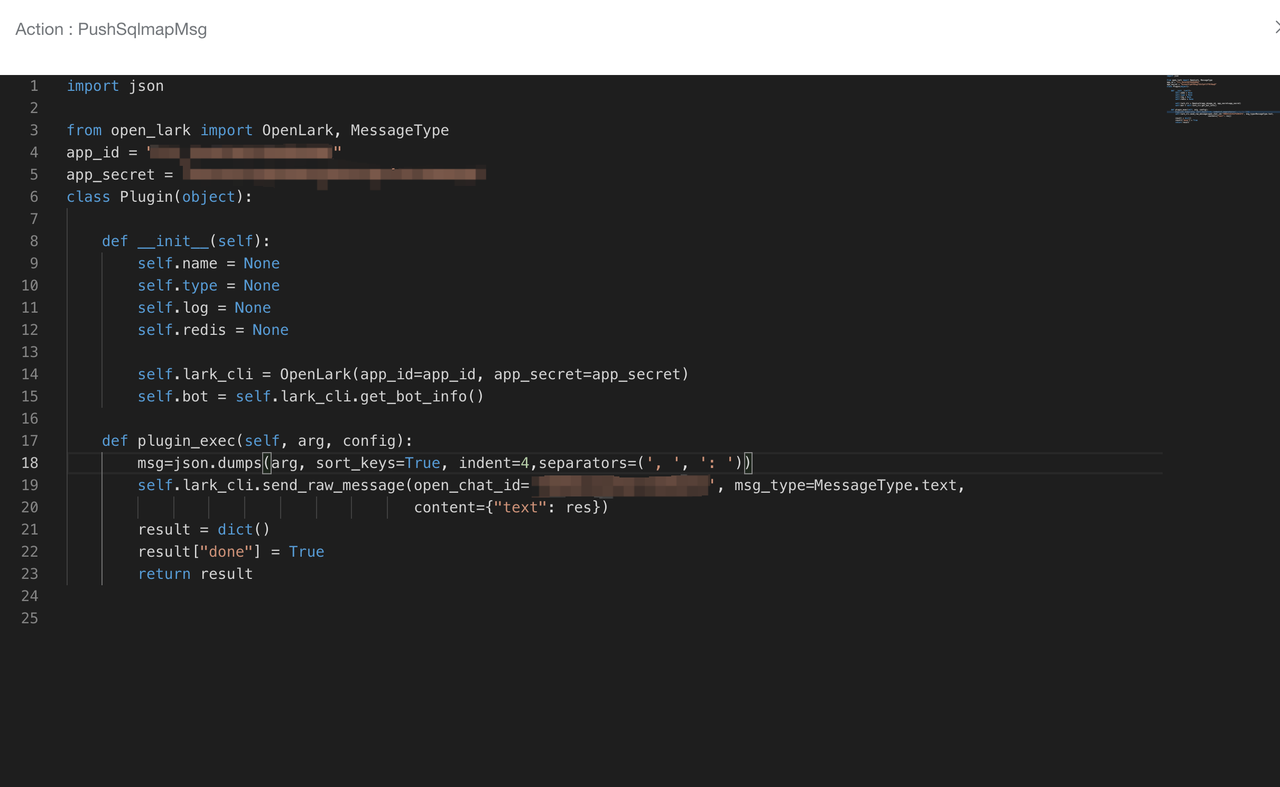

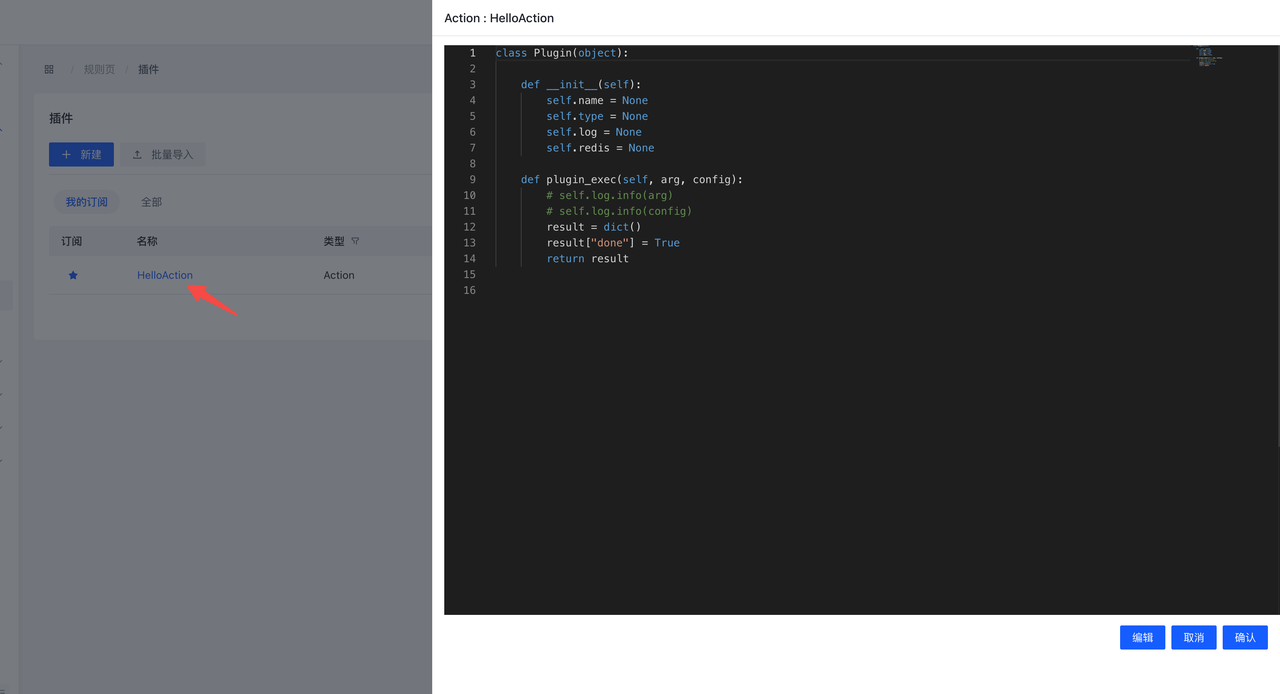

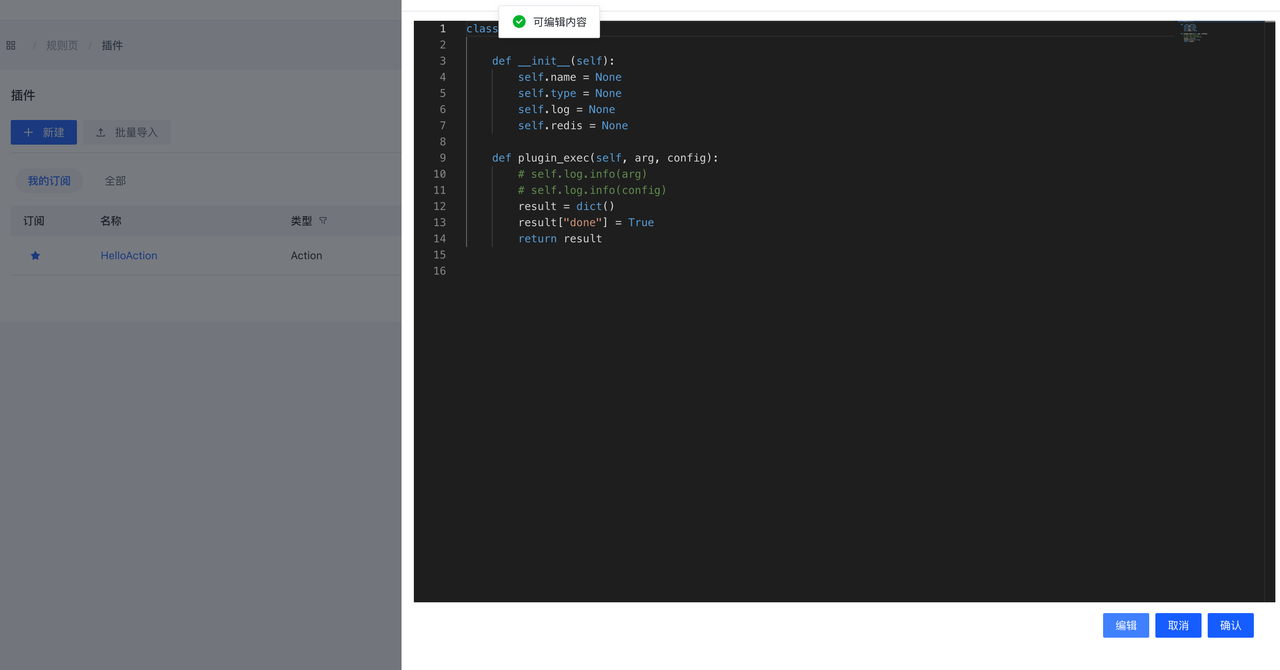

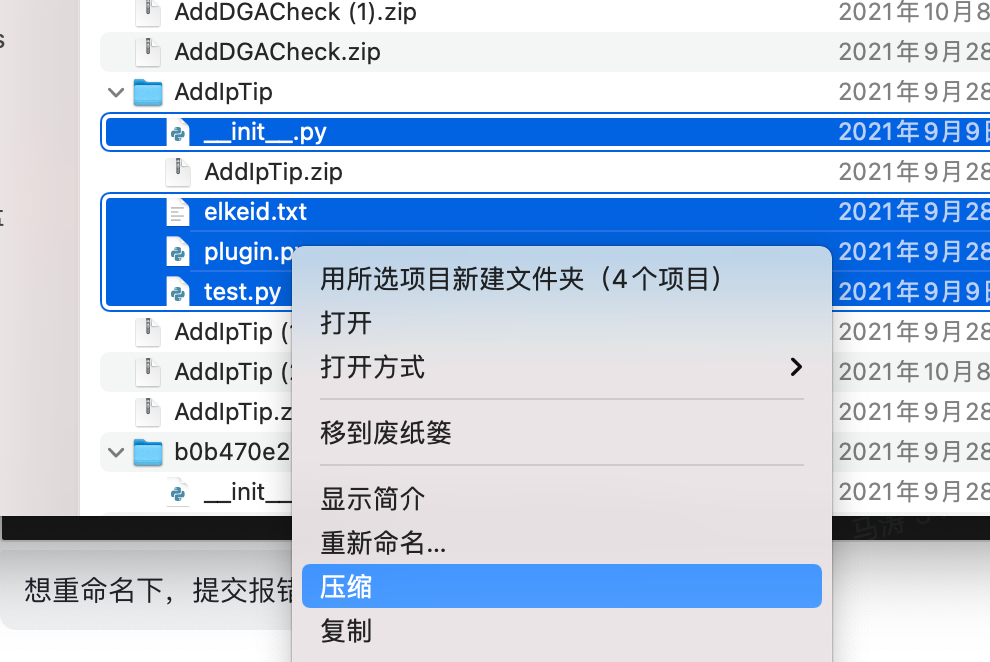

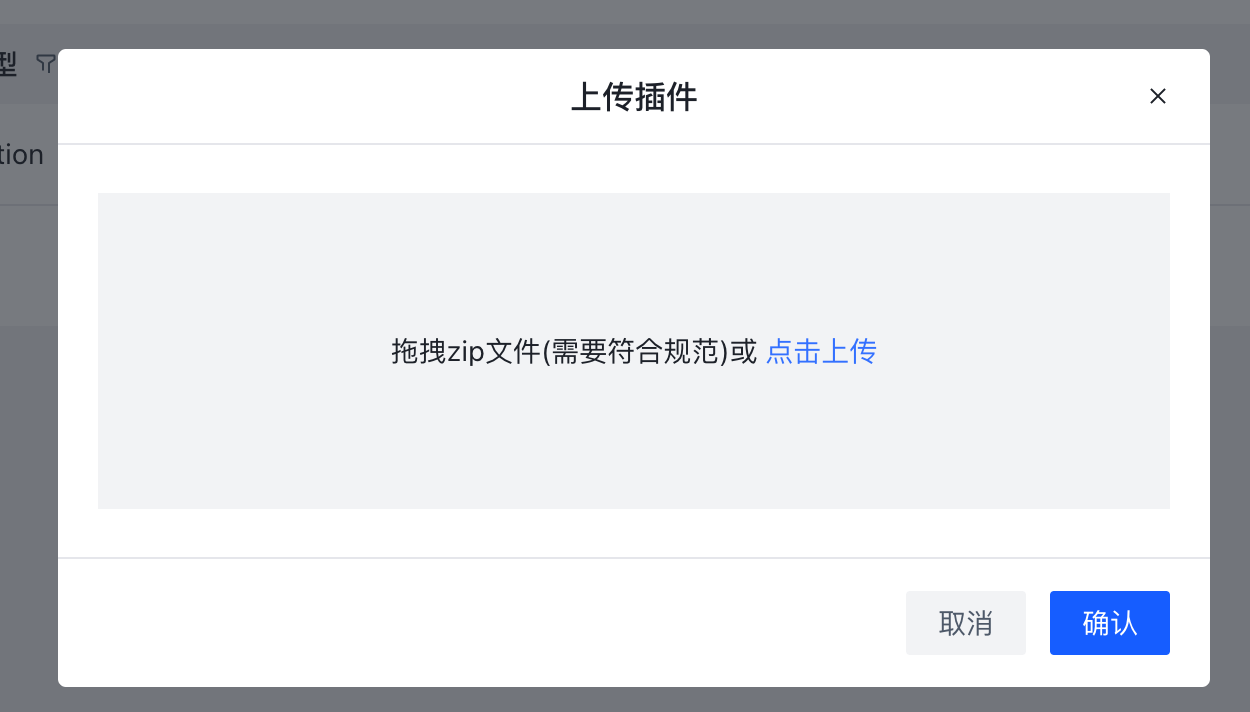

推送飞书插件编写

规则写完了,如果我想在发生该事件的时候飞书提醒我该如何实现呢?RuleSet并不支持这项功能,此时可以通过编写插件来实现。

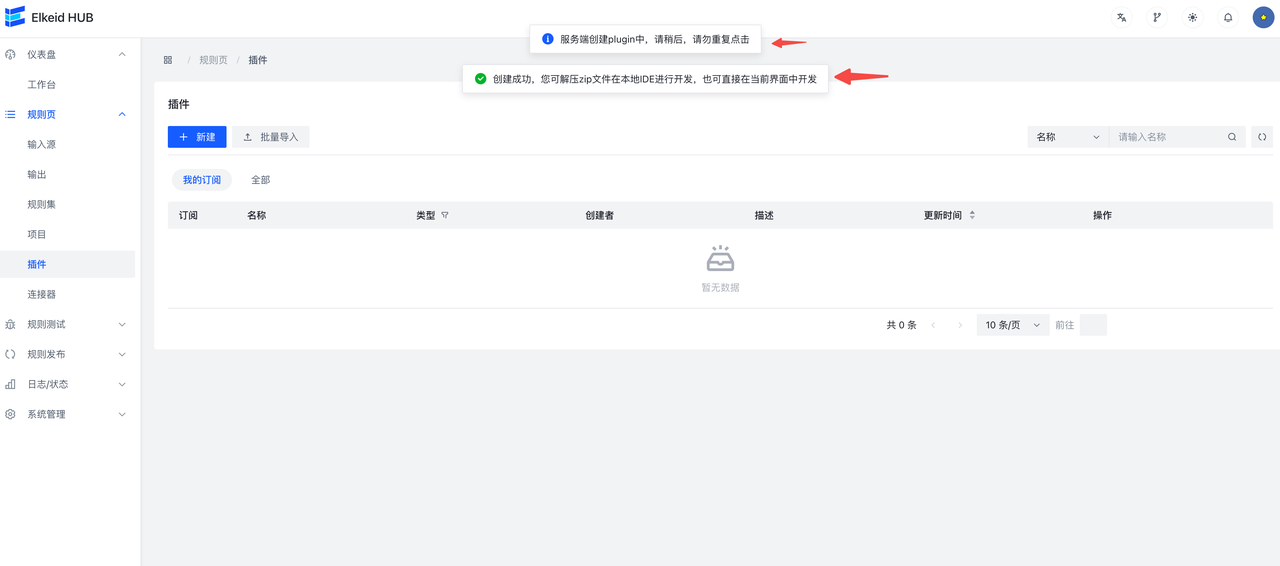

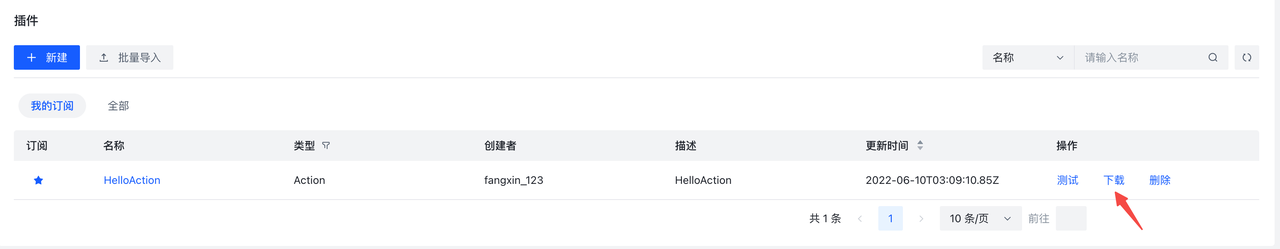

创建并使用Python 插件的步骤如下:

- 点击创建按钮

- 按照需求,填写信息

- 点击确认,完成创建

- 编辑插件

默认为只读状态,需要点击编辑才能进行编辑

编辑后点击保存

- 在Rule中添加action

- 同策略发布相同,在策略发布界面发布策略

这样每当这个rule的条件被触发,就会调用这个插件进行报警。

Elkeid CWPP 应用运行时防护 (RASP) 使用指南

本指南涵盖以下功能:

- 通过 CWPP 对 应用运行时 组件进行运维。

- 控制 RASP 植入探针到目标进程中,完成运行时行为采集。

- 植入配置

- 阻断/过滤 配置

- 查看 CWPP 的告警事件。

安装/更新 RASP 组件

- 确保组件列表中包含 rasp 组件。

如果没有 rasp 组件,需要新建组件,组件名为 rasp。

注意!由于 Agent 机制,插件名称与插件二进制名称应该一致。

发布版本,上传 tar.gz 格式的压缩包。

请使用 1.9.1.* 版本的插件。

压缩包地址:bytedance/Elkeid: releases

-

确保组件策略中包含 rasp 组件

-

同步策略到机器。

运行状态

部署 RASP 组件后,RASP 将会自动分析机器进程,对符合植入探针条件的进程信息将会上报到 运行状态。

右侧详情链接支持查看进程其他信息

右侧详情链接支持查看进程其他信息

配置

配置哪些进程将会开启 RASP 保护

点击新建配置

每条配置的各表单项目间为与的关系

每条配置间为或的关系

每条配置的各表单项目间为与的关系

每条配置间为或的关系

| 表单项目 | 是否必选 | 含义解释 | 备注 |

|---|---|---|---|

| 主机标签 | 否 | 划定本条配置的适用的主机标签范围 | 主机标签与资产管理中的标签一致 |

| IP | 否 | 对机器IP进行匹配 | |

| 进程命令行 | 否 | 对进程命令行进行正则匹配 | |

| 环境变量 | 否 | 对进程的环境变量进行匹配 | 可多个环境变量 多个间为与的关系 |

| 运行时类型 | 是 | 本条配置适用于哪种运行时 | 可多选 |

| 是否开启注入 | 是 | 本条配置筛选的进程是否开启 RASP 防护 | 默认为否 |

每条配置还可以配置阻断与过滤

- 阻断:对某个Hook函数的某个参数进行正则表达式匹配

- 正则表达式匹配到时,函数抛出异常阻断该函数运行。

- 正则表达式没有匹配到时,函数正常运行。

- 过滤:对某个Hook函数的参数进行正则表达式匹配

- 包含:只上报匹配到的参数数据

- 不包含:只上报匹配到以外的参数数据

入侵检测

RASP 探针植入目标进程后,将会持续上报应用行为,发现异常行为后将会产生事件与告警。

- 右侧告警数据可以检查参数详情与调用栈

社区版与企业版能力差异

Elkeid Console社区版v1.9.1和企业版能力对比

| 功能 | Elkeid Community Edition | Elkeid Enterprise Edition |

| Linux 数据采集能力 | ✅ | ✅ |

| RASP 探针能力 | ✅ | ✅ |

| K8s Audit Log 采集能力 | ✅ | ✅ |

| Agent 控制面 | ✅ | ✅ |

| 主机状态与详情 | ✅ | ✅ |

| 勒索诱饵 | 🙅♂️ | ✅ |

| 资产采集 | ✅ | ✅ |

| 高级资产采集 | 🙅♂️ | ✅ |

| 容器集群资产采集 | ✅ | ✅ |

| 暴露面与脆弱性分析 | 🙅♂️ | ✅ |

| 主机/容器 基础入侵检测 | 少量样例 | ✅ |

| 主机/容器 行为序列入侵检测 | 🙅♂️ | ✅ |

| RASP 基础入侵检测 | 少量样例 | ✅ |

| RASP 行为序列入侵检测 | 🙅♂️ | ✅ |

| K8S 基础入侵检测 | 少量样例 | ✅ |

| K8S 行为序列入侵检测 | 🙅♂️ | ✅ |

| K8S 威胁分析 | 🙅♂️ | ✅ |

| 告警溯源(行为溯源) | 🙅♂️ | ✅ |

| 告警溯源(驻留溯源) | 🙅♂️ | ✅ |

| 告警白名单 | ✅ | ✅ |

| 多告警聚合能力 | 🙅♂️ | ✅ |

| 威胁处置(进程) | 🙅♂️ | ✅ |

| 威胁处置(网络) | 🙅♂️ | ✅ |

| 威胁处置(文件) | 🙅♂️ | ✅ |

| 文件隔离箱 | 🙅♂️ | ✅ |

| 漏洞检测 | 少量情报 | ✅ |

| 漏洞情报热更新 | 🙅♂️ | ✅ |

| 基线检查 | 少量基线 | ✅ |

| RASP 热补丁 | 🙅♂️ | ✅ |

| 病毒扫描 | ✅ | ✅ |

| 用户行为日志分析 | 🙅♂️ | ✅ |

| 插件管理 | ✅ | ✅ |

| 系统监控 | ✅ | ✅ |

| 系统管理 | ✅ | ✅ |

| Windows 支持 | 🙅♂️ | ✅ |

| 蜜罐 | 🙅♂️ | 🚘 |

| 主动防御 | 🙅♂️ | 🚘 |

| 云查杀 | 🙅♂️ | 🚘 |

| 防篡改 | 🙅♂️ | 🚘 |

Elkeid HUB 社区版和企业版能力对比

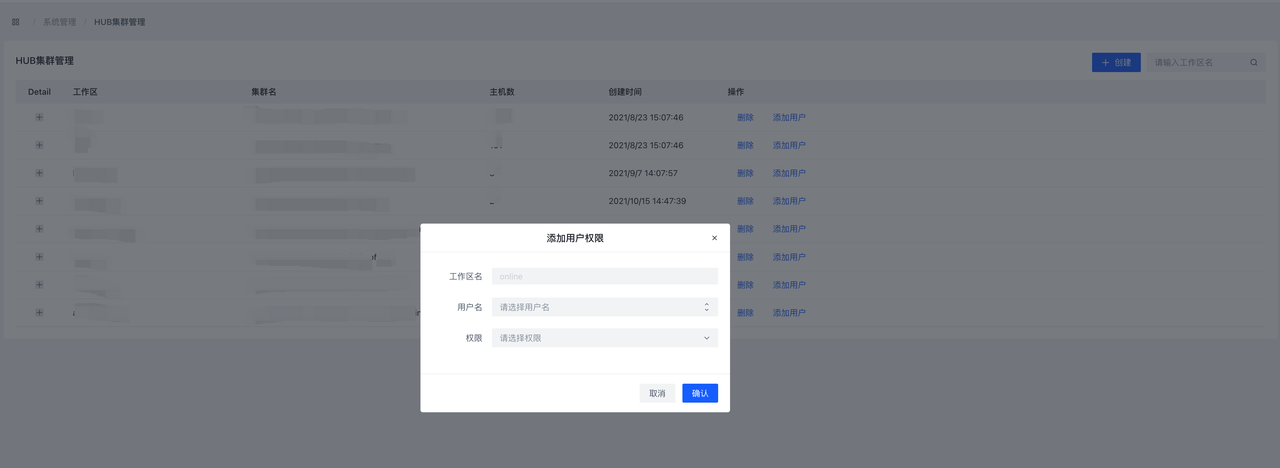

| 功能 | Elkeid HUB Community Edition | Elkeid HUB Enterprise Edition |

| 完全规则编写能力(详见Elkedi HUB社区版使用指南): 基础检测(等于/包含/以……开头/正则等) 阈值/频率/GROUP BY检测 多关键词检测 数组/复杂结构检测 CEP 节点检测能力 字段添加/修改/删除 插件联动能力 |

✅ |

✅ |

| 系统/用户管理能力 | ✅ | ✅ |

| 集群部署能力 | ❌ | ✅ |

| 多工作空间 | ❌ | ✅ |

| 输入/输出/规则集/项目组建操作能力 | ✅ | ✅ |

| 负载、规则监控能力 | ✅ | ✅ |

| 组件数据抽样能力 | ✅ | ✅ |

| 规则测试能力 | ✅ | ✅ |

| 数据表(MYSQL/REDIS/ClickHouse/Mongodb/ES)消费/规则关联能力 | ❌ | ✅ |

| 自定义插件能力 | ✅ | ✅ |

| 插件供外部调用能力 | ❌ | ✅ |

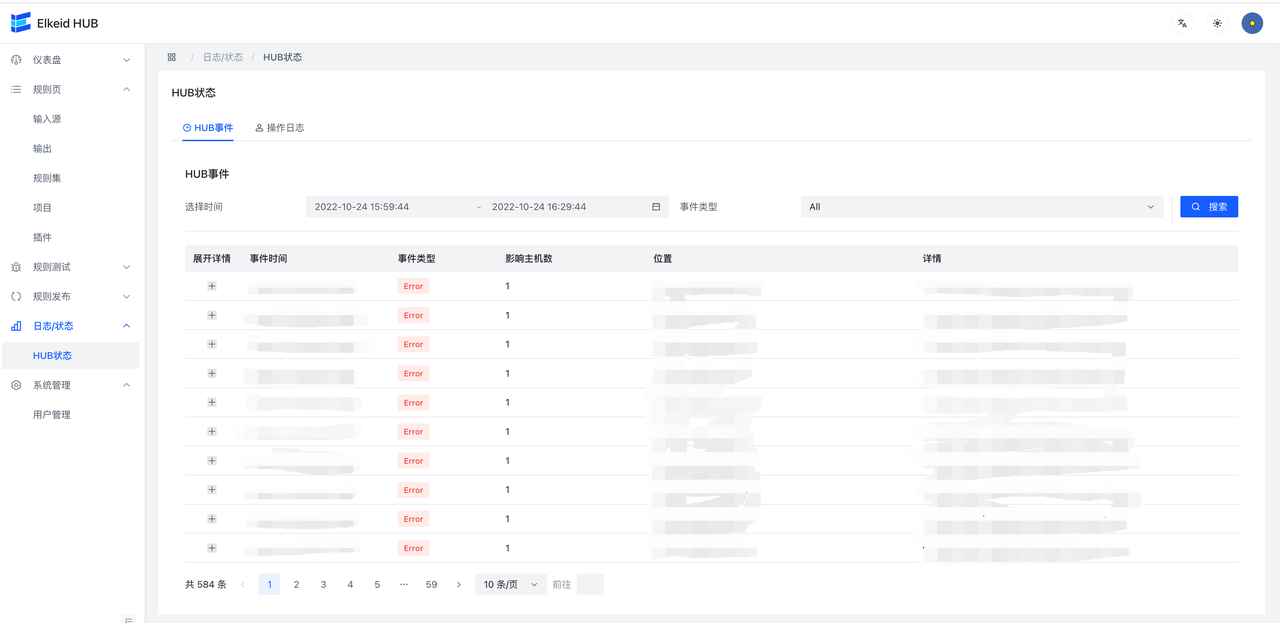

| 日志/事件监控能力 | ✅ | ✅ |

| 溯源/持久化能力 | ❌ | ✅ |

开源策略说明

HIDS开源策略列表

| 告警ID | 告警名 | 描述 | 告警类型 | 数据类型 | 等级 |

|---|---|---|---|---|---|

| hidden_module_detect | Hidden kernel module | Hidden Kernel Module Detected | 后门驻留 | Hooks | critical |

| bruteforce_single_source_detect | Bruteforce from single-source | Bruteforce from single source address | 暴力破解 | Log Monitor | medium |

| bruteforce_multi_source_detect | Bruteforce from multi-sources | Bruteforce from multiple source addresses | 暴力破解 | Log Monitor | medium |

| bruteforce_success_detect | Bruteforce success | Bruteforce login attempt ended with succesful password login | 暴力破解 | Log Monitor | critical |

| binary_file_hijack_detect1 | Binary file hijack | Common binary file hijacking, file creation detection | 变形木马 | execve | medium |

| binary_file_hijack_detect2 | Binary file hijack | Common binary file Hijacking, file renaming detection | 变形木马 | execve | critical |

| binary_file_hijack_detect3 | Binary file hijack | Common binary file hijacking, file linkage detection | 变形木马 | execve | critical |

| user_credential_escalation_detect | User credential escalation | Non-root user escalate to root privilege | 提权攻击 | Log Monitor | medium |

| privilege_escalation_suid_sgid_detect_1 | User credential escalation | Non-root user escalete privilege with suid/sgid | 提权攻击 | Log Monitor | medium |

| privilege_escalation_suid_sgid_detect_2 | User credential escalation | Non-root user escalete privilege with suid/sgid | 提权攻击 | execve | medium |

| reverse_shell_detect_basic | Reverse shell | Reverse Shell With Connection | 代码执行 | execve | critical |

| reverse_shell_detect_argv | Reverse shell | Reverse-shell-like argv during execution | 代码执行 | execve | high |

| reverse_shell_detect_exec | Reverse shell | Reverse shell with exec | 代码执行 | execve | high |

| reverse_shell_detect_pipe | Reverse shell | Reverse shell with pipe | 代码执行 | execve | high |

| reverse_shell_detect_perl | Reverse shell | Reverse shell with Perl | 代码执行 | execve | high |

| reverse_shell_detect_python | Reverse shell | Reverse shell with Python | 代码执行 | execve | high |

| bind_shell_awk_detect | Bind shell with awk | Suspecious bind shell with awk | 代码执行 | execve | high |

| pipe_shell_detect | Double-piped reverse shell | Double-piped reverse shell | 代码执行 | execve | high |

| suspicious_rce_from_consul_service_detect | Suspecious RCE like behavior | Suspecious RCE like behaviors from Consul service | 试探入侵 | execve | high |

| suspicious_rce_from_mysql_service_detect | Suspecious RCE like behavior | Suspecious RCE like behaviors from mysql service | 试探入侵 | execve | high |

| dnslog_detect1 | Suspecious query to dnslog | Suspecious dnslog like query on hosts | 试探入侵 | execve | high |

| dnslog_detect2 | Suspecious query to dnslog | Suspecious dnslog like query on hosts | 试探入侵 | execve | high |

| container_escape_mount_drive_detect | Container escape with mounted drive | Unnecessary behavior inside contianer, mount drive | 提权攻击 | execve | high |

| container_escape_usermode_helper_detect | Container escape with usermodehelper | Suspecious contianer escape with usermode helper | 提权攻击 | execve | high |

| signature_scan_maliciou_files_detect | Malicious files | Detected abnormal files with maliciou singnature | 静态扫描 | execve | high |

K8S开源策略列表

k8s 开源策略列表

| 策略一级类别 | 策略二级类别 | 策略三级类别 / 告警名称(风险名称) | 告警描述 | 告警类型 | 严重等级 | ATT&CK ID | 风险说明 | 处置建议(含关注字段) |

|---|---|---|---|---|---|---|---|---|

| 异常行为 | 认证/授权失败 | 匿名访问 | 匿名用户访问 | 试探入侵 | high | T1133 | 检测到匿名用户访问集群,可能有人对集群进行探测攻击。 | 1. 通过 UserAgent,操作,请求 URI 等字段判断该操作是否是敏感操作,如果是则可能是有人对集群进行攻击,请通过源 IP 字段以及该 IP 关联的资产信息等来定位发起者身份,进一步排查。 2. 如果不是,则可以考虑对其进行加白处理(注意:建议结合多个字段进行加白,避免导致漏报) 关注字段:UserAgent,账户/模拟账户,动作,资源 |

| 认证失败 | 枚举/获取 secrets,认证失败 | 试探入侵 | low | T1133 | 枚举、获取集群保密字典(Secret)时出现认证失败。攻击者可能会尝试获取集群 secrets 用于后续攻击。 | 1. 请先结合客户端的 UserAgent、账户/模拟账户等字段初步判断是否为业务、研发/运维的行为 2. 如果是重复出现的预期行为,且经排查后判断安全风险可控,可以考虑对其进行加白(注意:建议结合多个字段进行加白,避免导致漏报) 3. 如果是非预期行为,请通过源 IP 字段以及该 IP 关联的资产信息等来定位发起者身份,进一步排查 关注字段:UserAgent, 账户/模拟账户,动作,资源名字 |

||

| 授权失败 | 枚举/获取 secrets,授权失败 | 试探入侵 | medium | T1133 | 枚举、获取集群保密字典(Secret)时出现授权失败。攻击者可能会尝试获取 secrets 用于后续攻击。 | 1. 请先结合客户端的 UserAgent、账户/模拟账户等字段初步判断是否为业务、研发/运维的行为 2. 如果是重复出现的预期行为,且经排查后判断安全风险可控,可以考虑对其进行加白(注意:建议结合多个字段进行加白,避免导致漏报) 3. 如果是非预期行为,请通过源 IP 字段以及该 IP 关联的资产信息等来定位发起者身份,进一步排查 关注字段:UserAgent, 账户/模拟账户,动作,资源名字 |

||

| 凭据滥用 | 凭据滥用 | 利用 kubectl 滥用 ServiceAccount | 试探入侵 | critical | T1078, T1133 | 通过 kubectl 客户端工具以 SA 账户身份访问 k8s API Server。攻击者窃取到某个 SA token 后,然后通过 kubectl 工具,附带窃取的 token 向 API Server 发起请求来进行攻击。 | 1. 请先通过UserAgent、账户/模拟账户、动作、资源等字段确认是否为预期业务行为 2. 如果是重复出现的预期行为,且经排查后判断安全风险可控,可以考虑对其进行加白(注意:建议结合多个字段进行加白,避免导致漏报) 3. 如果是非预期行为,请通过源 IP 字段以及该 IP 关联的资产信息等来定位发起者身份,进一步排查 关注字段:UserAgent,账户/模拟账户,动作,资源 |

|

| 外部代码执行 | 外部代码执行 | 与 API Server 交互,在 pods 内执行命令 | 代码执行 | medium | T1609 | 通过 pods/exec (即 kubectl exec 对应的子资源)在容器内执行任意命令(创建交互式 bash、执行其他命令)。攻击者可能会通过创建 pods/exec 子资源在容器中执行任意命令,从而实现横向移动攻击、凭据窃取等。本策略记录所有的 pods/exec 行为。 | 1. 请先通过UserAgent、账户/模拟账户、执行命令等字段确认是否为预期业务行为 2. 如果是重复出现的预期行为,且经排查后判断安全风险可控,可以考虑对其进行加白(注意:建议结合多个字段进行加白,避免导致漏报) 3. 如果是非预期行为,请通过源 IP 字段以及该 IP 关联的资产信息等来定位发起者身份,进一步排查 关注字段:UserAgent,账户/模拟账户,执行命令 |

|

| 威胁资源 | Workloads 部署 | 特权容器 | 创建具有特权容器的工作负载 | 提权攻击 | critical | T1611, T1610 | 监测到有特权容器创建。攻击者可能会通过创建特权容器来横向移动并获取宿主机的控制权。业务在部署服务时,也可能会创建特权容器,如果容器被攻击,则可以轻易实现逃逸,因此非必要不创建。 | 1. 请先通过容器所属的业务等字段确认是否为预期业务行为 2. 如果是重复出现的预期行为,且经排查后判断安全风险可控,可以考虑对其进行加白(注意:建议结合多个字段进行加白,避免导致漏报) 3. 如果是非预期行为,请通过源 IP 字段以及该 IP 关联的资产信息等来定位发起者身份,进一步排查 关注字段:容器所属的业务,UserAgent, 账户/模拟账户 |

| 挂载宿主机敏感文件 | 创建挂载宿主机敏感文件的工作负载 | 提权攻击 | critical | T1611, T1610 | 创建的容器挂载了宿主机上的敏感目录或文件,比如根目录目录,/proc目录等。 攻击者可能会创建挂载宿主机敏感目录、文件的容器来提升权限,获取宿主机的控制权并躲避检测。当合法的业务创建挂载宿主机敏感目录、文件的容器时,也会给容器环境带来安全隐患。 针对前者需要进一步排查异常,针对后者需联系业务进行持续的安全合规整改。 |

1. 请先通过容器所属的业务等字段确认是否为预期业务行为 2. 如果是重复出现的预期行为,且经排查后判断安全风险可控,可以考虑对其进行加白(注意:建议结合多个字段进行加白,避免导致漏报) 3. 如果是非预期行为,请通过源 IP 字段以及该 IP 关联的资产信息等来定位发起者身份,进一步排查 关注字段:容器所属的业务,UserAgent,账户/模拟账户,镜像 |

||

| RoleBinding、ClusterRoleBinding 创建 | 创建不安全的 ClusterRole | 创建绑定大权限 ClusterRole 的 ClusterRoleBinding | 后门驻留 | high | T1078 | 创建的 ClusterRoleBinding 绑定了敏感的 ClusterRole,即将某个用户、用户组或服务账户赋予敏感的 ClusterRole 的权限。攻击者可能会为持久化、隐蔽性而创建绑定大权限 ClusterRole 的 ClusterRoleBinding。集群管理员或运维人员也可能会因安全意识不足而创建绑定大权限 ClusterRole 的 ClusterRoleBinding。根据权限最小化原则和 k8s 安全攻防实践,此类 ClusterRoleBinding 会给集群引入较大的安全风险,因此应该极力避免。 | 1. 请先结合客户端的 UserAgent、账户/模拟账户等字段初步判断是否为业务、研发/运维的行为 2. 如果是运维人员在进行角色绑定,则可以将告警设置为已处理。 3. 如果是重复出现的预期行为,且经排查后判断安全风险可控,可以考虑对其进行加白(注意:建议结合多个字段进行加白,避免导致漏报) 4. 如果是非预期行为,请通过源 IP 字段以及该 IP 关联的资产信息等来定位发起者身份,进一步排查 关注字段:UserAgent, 账户/模拟账户,主体名字,角色名字 |

|

| 漏洞利用行为 | N/A | 疑似 CVE-2020-8554 | 疑似存在通过创建、更新 Service 的 externalIPs 来利用 CVE-2020-8554 的利用行为 | 信息搜集 | high | T1557 | 检测到 CVE-2020-8554 的利用特征——创建、更新 Service 并设置 externalIPs。此漏洞的利用途径之一为 创建、更新 Service 时设置了恶意 spec.externalIPs 从而实现中间人攻击。根据实践,Service 的 ExternalIP 属性很少被使用。因此当发生这种行为时,需要运营人员进一步核实 ExternalIP 是否为合法的 IP 地址。 | 1. 请先通过UserAgent、账户/模拟账户等字段以及原始日志中的 requestObject.spec.externalIPs 的值确认是否为预期业务行为 2. 如果是重复出现的预期行为,且经排查后判断安全风险可控,可以考虑对其进行加白(注意:建议结合多个字段进行加白,避免导致漏报) 3. 如果是非预期行为,请通过源 IP 字段以及该 IP 关联的资产信息等来定位发起者身份,进一步排查 关注字段:UserAgent, 账户/模拟账户, requestObject.spec.externalIPs |

K8S开源策略编写说明

数据源

K8S策略基于K8S Audit Logs数据,具体的Audit Policy可以在平台中下载。在Console中配置好后,数据会经Agent Center上开启的Webhook写入到Kafka的k8stopic。也可以直接使用HUB中自带的k8s INPUT作为数据源。

开源策略说明

Project

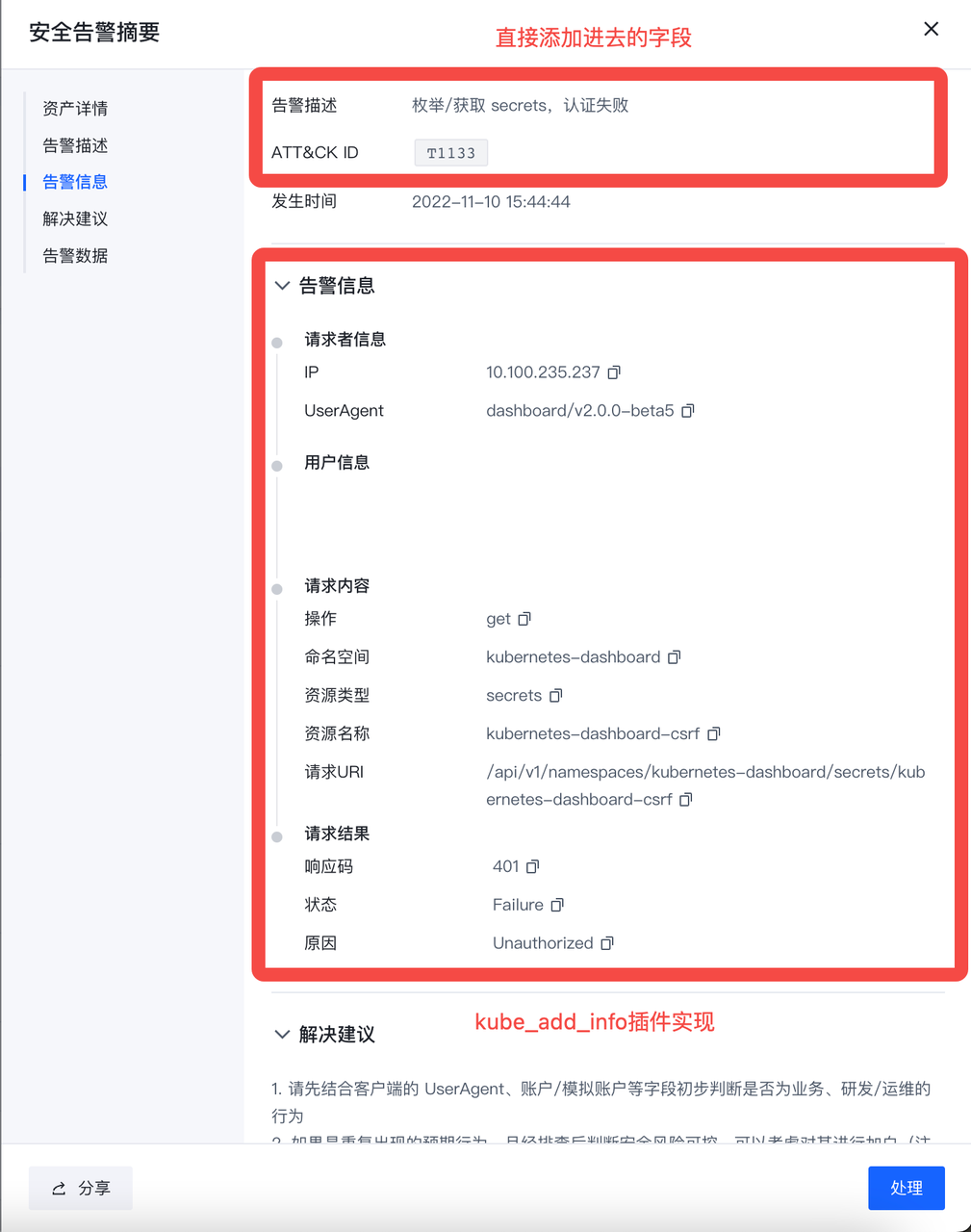

在v1.9.1社区版中,我们编写了一部分示例策略用于开源,对应的HUB Project为kube_example和kube_workload。kube_example存放的策略为基础策略,kube_workload存放的为需要对数据进行处理后再进行检测的策略。

- kube_example

INPUT.k8s --> RULESET.kube_detect

RULESET.kube_detect --> RULESET.kube_alert_info

RULESET.kube_alert_info --> RULESET.kube_add_cluster_info

RULESET.kube_add_cluster_info --> RULESET.kube_push_alert

- kube_workload

INPUT.k8s --> RULESET.kube_workloads

RULESET.kube_workloads --> RULESET.kube_filter_workloads

RULESET.kube_filter_workloads --> RULESET.kube_handle_workloads

RULESET.kube_handle_workloads --> RULESET.kube_detect_workloads

RULESET.kube_detect_workloads --> RULESET.kube_alert_info

RULESET.kube_alert_info --> RULESET.kube_add_cluster_info

RULESET.kube_add_cluster_info --> RULESET.kube_push_alert

Ruleset

下面为一些调用HUB内置插件的规则集进行补充说明,其余规则可以直接在HUB前端进行查看。

kube_alert_info规则集对检出的告警添加告警数据字段,同时调用Kube_add_info插件添加告警的基础信息。该插件为HUB内置Modify插件,因此可以按需调用。

kube_add_cluster_info规则集调用Manager接口通过集群id获取集群信息,该流程通过调用KubeAddClusterInfo插件实现。该插件为HUB内置Modify插件。

kube_push_alert规则集调用Manager接口推送告警,该流程通过调用KubePushMsgToLeader插件实现。该插件为HUB内置Action插件。

下图为告警内容说明:

workload相关检测策略通过Python Plugin进行实现,该插件于kube_handle_workloads中调用。

workload相关检测策略通过Python Plugin进行实现,该插件于kube_handle_workloads中调用。

编写建议

在编写其余告警策略时,需要分别调用kube_alert_info、kube_add_cluster_info、kube_push_alert进行告警的信息填充,集群信息添加,告警的推送。如果新增告警类型,需要在kube_alert_info中进行添加,补充相关字段。

Elkeid - Bytedance Cloud Workload Protection Platform

Elkeid 是一款可以满足 主机,容器与容器集群,Serverless 等多种工作负载安全需求的开源解决方案,源于字节跳动内部最佳实践。

随着企业的业务发展,多云、云原生、多种工作负载共存的情况愈发凸显,我们希望可以有一套方案可以满足不同工作负载下的安全需求,因此 Elkeid 诞生了。

Introduction

Elkeid 具备以下主要能力:

-

Elkeid 不仅具备传统的 HIDS(Host Intrusion Detection System) 的对于主机层入侵检测和恶意文件识别的能力,且对容器内的恶意行为也可以很好的识别,部署在宿主机即可以满足宿主机与其上容器内的反入侵安全需求,并且 Elkeid 底层强大的内核态数据采集能力可以满足大部分安全运营人员对于主机层数据的渴望。

-

对于运行的业务 Elkeid 具备 RASP 能力可以注入到业务进程内进行反入侵保护,不仅运维人员不需要再安装一个 Agent,业务也无需重启。

-

对于 K8s 本身 Elkeid 支持接入K8s Audit Log 对 K8s 系统进行入侵检测和风险识别。

-

Elkeid 的规则引擎 Elkeid HUB 也可以很好的和外部多系统进行联动对接。

Ekeid 将这些能力都很好的融合在一个平台内,满足不同工作负载的复杂安全需求的同时,还能实现多组件能力关联,更难得的是每个组件均经过字节跳动海量数据和多年的实战检验。

Elkeid Community Edition Description

需要注意的是 Elkeid 开源版本 和完整版本存在差异,目前已开源的能力主要包括:

- 全部端上能力,即端上数据/资产/部分采集能力,内核态数据采集能力,RASP 探针部分等,并与字节跳动内部版本一致;

- 全部接入层能力,即 Agent Center,服务发现等,并与字节跳动内部版本一致;

- 提供社区版规则引擎即 Elkeid HUB,并配套少量策略作为示例使用;

- 提供社区版 Elkeid Console 与部分配套能力。

因此需要具备完整的反入侵与风险感知能力,还需要自行基于 Elkeid HUB 进行策略构建和对 Elkeid 采集的数据进行二次加工等工作。

Elkeid Architecture

Elkeid Host Ability

- Elkeid Agent 用户态 Agent,负责管理各个端上能力组件并与 Elkeid Agent Center 通信

- Elkeid Driver 负责 Linux Kernel 层采集数据,兼容容器,并能够检测常见 Rootkit

- Elkeid RASP 支持 CPython、Golang、JVM、NodeJS、PHP 的运行时数据采集探针,支持动态注入到运行时

- Elkeid Agent Plugin List

- Driver Plugin: 负责与 Elkeid Driver 通信,处理其传递的数据等

- Collector Plugin: 负责端上的资产/关键信息采集工作,如用户,定时任务,包信息等

- Journal Watcher: 负责监测systemd日志的插件,目前支持ssh相关日志采集与上报

- Scanner Plugin: 负责在端上进行静态检测恶意文件的插件,支持 Yara

- RASP Plugin: 分析系统进程运行时,上报运行时信息,处理下发的 Attach 指令,收集各个探针上报的数据

- Baseline Plugin: 负责在端上进行基线风险识别的插件

- Elkeid 数据说明

- Elkeid 数据接入

Elkeid Backend Ability

- Elkeid AgentCenter 负责与 Agent 进行通信并管理 Agent 如升级,配置修改,任务下发等

- Elkeid ServiceDiscovery 后台中的各组件都会向该组件定时注册、同步服务信息,从而保证各组件相互可见,便于直接通信

- Elkeid Manager 负责对整个后台进行管理,并提供相关的查询、管理接口

- Elkeid Console Elkeid 前端部分

- Elkeid HUB 策略引擎

Elkeid Function List

| 功能 | Elkeid Community Edition | Elkeid Enterprise Edition |

|---|---|---|

| Linux 数据采集能力 | :white_check_mark: | :white_check_mark: |

| RASP 探针能力 | :white_check_mark: | :white_check_mark: |

| K8s Audit Log 采集能力 | :white_check_mark: | :white_check_mark: |

| Agent 控制面 | :white_check_mark: | :white_check_mark: |

| 主机状态与详情 | :white_check_mark: | :white_check_mark: |

| 勒索诱饵 | :ng_man: | :white_check_mark: |

| 资产采集 | :white_check_mark: | :white_check_mark: |

| 高级资产采集 | :ng_man: | :white_check_mark: |

| 容器集群资产采集 | :white_check_mark: | :white_check_mark: |

| 暴露面与脆弱性分析 | :ng_man: | :white_check_mark: |

| 主机/容器 基础入侵检测 | 少量样例 | :white_check_mark: |

| 主机/容器 行为序列入侵检测 | :ng_man: | :white_check_mark: |

| RASP 基础入侵检测 | 少量样例 | :white_check_mark: |

| RASP 行为序列入侵检测 | :ng_man: | :white_check_mark: |

| K8S 基础入侵检测 | 少量样例 | :white_check_mark: |

| K8S 行为序列入侵检测 | :ng_man: | :white_check_mark: |

| K8S 威胁分析 | :ng_man: | :white_check_mark: |

| 告警溯源(行为溯源) | :ng_man: | :white_check_mark: |

| 告警溯源(驻留溯源) | :ng_man: | :white_check_mark: |

| 告警白名单 | :white_check_mark: | :white_check_mark: |

| 多告警聚合能力 | :ng_man: | :white_check_mark: |

| 威胁处置(进程) | :ng_man: | :white_check_mark: |

| 威胁处置(网络) | :ng_man: | :white_check_mark: |

| 威胁处置(文件) | :ng_man: | :white_check_mark: |

| 文件隔离箱 | :ng_man: | :white_check_mark: |

| 漏洞检测 | 少量情报 | :white_check_mark: |

| 漏洞情报热更新 | :ng_man: | :white_check_mark: |

| 基线检查 | 少量基线 | :white_check_mark: |

| RASP 热补丁 | :ng_man: | :white_check_mark: |

| 病毒扫描 | :white_check_mark: | :white_check_mark: |

| 用户行为日志分析 | :ng_man: | :white_check_mark: |

| 插件管理 | :white_check_mark: | :white_check_mark: |

| 系统监控 | :white_check_mark: | :white_check_mark: |

| 系统管理 | :white_check_mark: | :white_check_mark: |

| Windows 支持 | :ng_man: | :white_check_mark: |

| 蜜罐 | :ng_man: | :oncoming_automobile: |

| 主动防御 | :ng_man: | :oncoming_automobile: |

| 云查杀 | :ng_man: | :oncoming_automobile: |

| 防篡改 | :ng_man: | :oncoming_automobile: |

Front-end Display (Community Edition)

安全概览

容器集群安全告警

容器集群工作负载信息

主机概览

资产指纹

安全告警

漏洞信息

基线检查

病毒扫描

后端监控

后端服务监控

Console User Guide

Quick Start

Contact us && Cooperation

Lark Group

About Elkeid Enterprise Edition

Elkeid 企业版本支持单独策略售卖,也支持完全完整能力售卖。

如果对Elkeid企业版感兴趣请联系: elkeid@bytedance.com

Elkeid Docs

For more details and latest updates, see Elkeid docs.

License

- Elkeid Driver: GPLv2

- Elkeid RASP: Apache-2.0

- Elkeid Agent: Apache-2.0

- Elkeid Server: Apache-2.0

- Elkeid Console: Elkeid License

- Elkeid HUB: Elkeid License

404StarLink 2.0 - Galaxy

同时,Elkeid 也是 404Team 星链计划2.0中的一环,如果对星链计划感兴趣的小伙伴可以点击下方链接了解。 https://github.com/knownsec/404StarLink2.0-Galaxy

关于 Elkeid Agent

Agent提供端上组件的基本能力支撑,包括数据通信、资源监控、组件版本控制、文件传输、机器基础信息采集等。

Agent本身不提供安全能力,作为一个插件底座以系统服务的方式运行。各类功能插件的策略存放于服务器端的配置,Agent接收到相应的控制指令及配置后对自身及插件进行开启、关闭、升级等操作。

Agent与Server之间采用bi-stream gRPC进行通信,基于自签名证书开启双向TLS验证,保障信道安全。其中,Agent -> Server 方向信息流动称为数据流,Server -> Agent 方向信息流动一般为控制流,使用protobuf的不同message类型。Agent本身支持客户端侧服务发现,也支持跨Region级别的通信配置,实现一个Agent包在多个网络隔离的环境下进行安装,基于底层一个TCP连接,在上层实现了Transfer与FileOp两种数据传输服务,支撑了插件本身的数据上报与Host中的文件交互。

Plugins作为安全能力插件,与Agent的进程关系一般为“父——子”进程。以两个pipe作为跨进程通信方式,plugins lib提供了Go与Rust的两个插件库,负责插件端信息的编码与发送。值得一提的是,插件发送数据后,会被编码为Protobuf二进制数据,Agent接收到后无需二次解编码,再其外层拼接好Header特征数据,直接传输给Server,一般情况下Server也无需解码,直接传输至后续数据流中,使用时进行解码,一定程度上降低了数据传输中多次编解码造成的额外性能开销。

Agent采用Go实现,在Linux下,通过systemd作为守护方式,受cgroup限制控制资源使用,支持aarch64与x86-64架构,最终编译、打包为deb与rpm包分发,格式均符合systemd及Debian、RHEL规范,可以直接提供至对应的软件仓库中进行后续版本维护。在后续版本中,将会发布用于Windows平台下的Agent。

运行时要求

Agent及Plugin提供的大部分功能需要以root权限运行在宿主机(Host)层面,在权限受限的容器中,部分功能可能会存在异常。

快速开始

通过 elkeidup 的完整部署,可以直接得到用于Debian/RHEL系列发行版的安装包,并按照 Elkeid Console - 安装配置 界面的命令进行安装部署。

手动编译

环境要求

确认相关配置

- 需要确保

transport/connection目录下的ca.crt、client.key、client.crt三个文件与Agent Centerconf目录下的同名文件保持一致。 - 需要确保

transport/connection/product.go文件中的参数都配置妥当:- 如果是手动部署的Server:

serviceDiscoveryHost["default"]需被赋值为 ServiceDiscovery 服务或代理服务的内网监听地址与端口,例如:serviceDiscoveryHost["default"] = "192.168.0.1:8088"privateHost["default"]需被赋值为 AgentCenter 服务或代理服务的内网监听地址与端口,例如:privateHost["default"] = "192.168.0.1:6751"- 如有Server的公网接入点,

publicHost["default"]需被赋值为 AgentCenter 服务或代理服务的外网监听地址与端口,例如:publicHost["default"]="203.0.113.1:6751"

- 如果是通过 elkeidup 部署的Server,可以根据部署Server机器的

~/.elkeidup/elkeidup_config.yaml文件获得对应配置:- 在配置文件中找到 Nginx 服务的IP,具体的配置项为

nginx.sshhost[0].host - 在配置文件中找到 ServiceDiscovery 服务的IP,具体的配置项为

sd.sshhost[0].host serviceDiscoveryHost["default"]需被赋值为 ServiceDiscovery 服务的IP,并将端口号设置为8088,例如:serviceDiscoveryHost["default"] = "192.168.0.1:8088"privateHost["default"]需被赋值为 Nginx 服务的IP,并将端口号设置为8090,例如:privateHost["default"] = "192.168.0.1:8090"

- 在配置文件中找到 Nginx 服务的IP,具体的配置项为

- 如果是手动部署的Server:

编译

在Agent根目录,执行:

BUILD_VERSION=1.7.0.24 bash build.sh

在编译过程中,脚本会读取 BUILD_VERSION 环境变量设置版本信息,可根据实际需要进行修改。

编译成功后,在根目录的 output 目录下,应该可以看到2个deb与2个rpm文件,它们分别对应不同的系统架构。

版本升级

- 如果没有创建过客户端类型的组件,请在 Elkeid Console-组件管理 界面新建对应组件。

- 在 Elkeid Console - 组件管理 界面,找到“elkeid-agent”条目,点击右侧“发布版本”,填写版本信息并上传对应平台与架构的文件,点击确认。

- 在 Elkeid Console - 组件策略 界面,(如有)删除旧的“elkeid-agent”版本策略,点击“新建策略”,选中刚刚发布的版本,点击确认。后续新安装的Agent均会自升级到最新版本。

- 在 Elkeid Console - 任务管理 界面,点击“新建任务”,选择全部主机,点击下一步,选择“同步配置”任务类型,点击确认。随后,在此页面找到刚刚创建的任务,点击运行,即可对存量旧版本Agent进行升级。

License

Elkeid Agent is distributed under the Apache-2.0 license.

后台架构图

概述

Elkeid 后台大体包含5个模块:

- AgentCenter(AC),负责与Agent进行通信,采集Agent数据并简单处理后汇总到消息队列集群,同时也负责对Agent进行管理包括Agent的升级,配置修改,任务下发等。同时AC也对外提供HTTP接口,Manager通过这些HTTP接口实现对AC和Agent的管理和监控。

- ServiceDiscovery(SD),后台中的各个服务模块都需要向SD中心定时注册、同步服务信息,从而保证各个服务模块中的实例相互可见,便于直接通信。由于SD维护了各个注册服务的状态信息,所以当服务使用方在请求服务发现时,SD会进行负载均衡。比如Agent请求获取AC实例列表,SD直接返回负载压力最小的AC实例。

- Manager,负责对整个后台进行管理并提供相关的查询、管理接口。包括管理AC集群,监控AC状态,控制AC服务相关参数,并通过AC管理所有的Agent,收集Agent运行状态,往Agent下发任务,同时manager也管理实时和离线计算集群。

- Elkeid Console: Elkeid 前端部分。

- Elkeid HUB :Elkeid HIDS RuleEngine。

简单来说就是AgentCenter收集Agent数据,Elkeid HUB对这些数据进行分析和检测,Manager管理着AgentCenter和这些计算模块,ServiceDiscovery把这些所有的服务、节点都串联了起来,通过Elkeid Console可查看告警和资产数据等。

功能特点

- 百万级Agent的后台架构解决方案

- 分布式,去中心化,集群高可用

- 部署简单,依赖少,便于维护

完整部署文档

编译

- AgentCenter(AC): 在

Elkeid/server/agent_center目录执行./build.sh,将会在在output目录下生成产物bin.tar.gz。 - ServiceDiscovery(SD):在

Elkeid/server/service_discovery目录执行./build.sh将会在在output目录下生成产物bin.tar.gz。 - Manager:在

Elkeid/server/manager目录执行./build.sh,将会在在output目录下生成产物bin.tar.gz。

版本升级

参照从源码构建 Elkeid CWPP的后端部分,来部署或升级即可。

Console User Guide

License

Elkeid Server are distributed under the Apache-2.0 license.

About Elkeid(AgentSmith-HIDS) Driver

Elkeid Driver 主要是为信息安全需求而设计的。

Elkeid Driver 主要通过 Kprobe Hook Kernel Function 来提供丰富而准确的数据收集功能,包括内核级进程执行探测,特权升级监控,网络审计等等。 并且支持 Linux Namespace,因此对容器监控有着很好的实现。与传统的 User Space HIDS 相比,Elkeid 由于驱动的存在提供了更全面的信息,并提高了性能。

凭借其出色的数据收集能力,Elkeid Driver 还可以支持沙盒,蜜罐和审计等需求。

如果发现 Bug 欢迎提 Issue 或 加入飞书公开群参与讨论。

快速尝试

首先需要安装 Linux Headers,Linux Headers 的版本必须等于 uname -r

# clone and build

git clone https://github.com/bytedance/Elkeid.git

cd Elkeid/driver/LKM/

make clean && make

< CentOS only: run build script instead >

sh ./centos_build_ko.sh

# load and test (should run as root)

insmod hids_driver.ko

dmesg | tail -n 20

test/rst -q

< "CTRL + C" to quit >

# unload

rmmod hids_driver

我们提供部分预编译好的 Ko 文件

我们提供了一些预编译好的 Elkeid 内核模块,这些 Ko 文件包括了 Debian / CentOS / Ubuntu 等发行版的不同内核版本。

获取方式

如果所有链接都获取失败,则说明 预编译的 Ko 中,不包含当前系统的内核版本所需的 Ko 文件,需要自行编译。

wget "http://lf26-elkeid.bytetos.com/obj/elkeid-download/ko/hids_driver_1.7.0.10_$(uname -r)_amd64.ko"

内核模块的测试方法

可以通过 LTP 或者 KASAN 这两个方法对内核模块进行测试.

这里提供 LTP测试用例 文件

关于 Linux 发行版的兼容性

| 发行版 | 版本号 | x64 架构内核 | 内核后缀 |

|---|---|---|---|

| Debian | 8,9,10 | 3.16~5.4.X | - |

| Ubuntu | 14.04,16.04,18.04,20.04 | 3.12~5.4.X | generic |

| CentOS | 6.X,7.X,8.X | 2.6.32.0~5.4.X | el6,el7,el8 |

| Amazon | 2 | 4.9.X~4.14.X | amzn2 |

| AlibabaCloudLinux | 3 | 4.19.X~5.10.X | al7,al8 |

| EulerOS | V2.0 | 3.10.X | - |

关于 ARM64 (AArch64) 支持

- 支持

关于 Linux Kernel Version 兼容性

- Linux Kernel Version >= 2.6.32 && <= 6.3

关于容器兼容性

| Source | Nodename |

|---|---|

| Host | hostname |

| Docker | container name |

| K8s | pod name |

Hook List

| Hook | DataType | Note | Default |

|---|---|---|---|

| write | 1 | OFF | |

| open | 2 | OFF | |

| mprotect | 10 | only PROT_EXEC | OFF |

| nanosleep | 35 | OFF | |

| connect | 42 | ON | |

| accept | 43 | OFF | |

| bind | 49 | ON | |

| execve | 59 | ON | |

| process exit | 60 | OFF | |

| kill | 62 | OFF | |

| rename | 82 | ON | |

| link | 86 | ON | |

| ptrace | 101 | only PTRACE_POKETEXT or PTRACE_POKEDATA | ON |

| setsid | 112 | ON | |

| prctl | 157 | only PR_SET_NAME | ON |

| mount | 165 | ON | |

| tkill | 200 | OFF | |

| exit_group | 231 | OFF | |

| memfd_create | 356 | ON | |

| dns query | 601 | ON | |

| create_file | 602 | ON | |

| load_module | 603 | ON | |

| update_cred | 604 | only old uid ≠0 && new uid == 0 | ON |

| unlink | 605 | OFF | |

| rmdir | 606 | OFF | |

| call_usermodehelper_exec | 607 | ON | |

| file_write | 608 | OFF | |

| file_read | 609 | OFF | |

| usb_device_event | 610 | ON | |

| privilege_escalation | 611 | ON | |

| port-scan detection | 612 | tunable via module param: psad_switch | OFF |

Anti Rootkit List

| Rootkit | DataType | Default |

|---|---|---|

| interrupt table hook | 703 | ON |

| syscall table hook | 701 | ON |

| proc file hook | 700 | ON |

| hidden kernel module | 702 | ON |

关于驱动数据传输

驱动数据协议

上述 Hook 点每命中一次,均会生成一条日志记录,记录之间使用 '\x17' 作为间隔符。

每条记录包含多个数据项,数据项之间使用 '\x1e' 作为间隔符。

一条记录数据通常由公共数据和私有数据组合而成,而值得注意的是,Anti-rootkit 没有公共数据。

公共数据

-------------------------------------------------------------------------------

|1 |2 |3 |4 |5 |6 |7 |8 |9 |10 |11 |12 |13 |

-------------------------------------------------------------------------------

|data_type|uid|exe|pid|ppid|pgid|tgid|sid|comm|nodename|sessionid|pns|root_pns|

-------------------------------------------------------------------------------

Write Data (1)

-----------

|14 |15 |

-----------

|file||buf|

-----------

Open Data (2)

---------------------

|14 |15 |16 |

---------------------

|flags|mode|filename|

---------------------

Mprotect Data (10)

-----------------------------------------------------

|14 |15 |16 |17 |18 |

-----------------------------------------------------

|mprotect_prot|owner_pid|owner_file|vm_file|pid_tree|

-----------------------------------------------------

Nanosleep Data (35)

----------

|14 |15 |

----------

|sec|nsec|

----------

Connect Data (42)

-----------------------------------

|14 |15 |16 |17 |18 |19 |

-----------------------------------

|sa_family|dip|dport|sip|sport|res|

-----------------------------------

Accept Data (43)

-----------------------------------

|14 |15 |16 |17 |18 |19 |

-----------------------------------

|sa_family|dip|dport|sip|sport|res|

-----------------------------------

Bind Data (49)

-------------------------

|14 |15 |16 |17 |

-------------------------

|sa_family|sip|sport|res|

-------------------------

Execve Data (59)

-----------------------------------------------------------------------------------------------------

|14 |15 |16 |17 |18 |19 |20 |21 |22 |23 |24 |25 |26 |27 |28 |

-----------------------------------------------------------------------------------------------------

|argv|run_path|stdin|stdout|dip|dport|sip|sport|sa_family|pid_tree|tty|socket_pid|ssh|ld_preload|res|

-----------------------------------------------------------------------------------------------------

Note:

-

socket_exe/dip/dport/sip/sport/sa_family 来自于进程所持的 fd 信息

-

ssh/ld_preload 来自于进程的环境变量信息

Process Exit Data (60)

该数据没有私有数据,仅有公共数据

Kill Data (62)

----------------

|14 |15 |

----------------

|target_pid|sig|

----------------

Rename Data (82)

-------------------------

|14 |15 |16 |

-------------------------

|old_name|new_name|sb_id|

-------------------------

Link Data (86)

-------------------------

|14 |15 |16 |

-------------------------

|old_name|new_name|sb_id|

-------------------------

Ptrace Data (101)

----------------------------------------------

|14 |15 |16 |17 |18 |

----------------------------------------------

|ptrace_request|target_pid|addr|data|pid_tree|

----------------------------------------------

Setsid Data (112)

该数据没有私有数据,仅有公共数据

Prctl Data (157)

_________________

|14 |15 |

-----------------

|option|new_name|

-----------------

Mount Data (165)

_____________________________________

|14 |15 |16 |17 |18 |

-------------------------------------

|pid_tree|dev|file_path|fstype|flags|

-------------------------------------

Tkill Data (200)

----------------

|14 |15 |

----------------

|target_pid|sig|

----------------

Exit Group Data (231)

该数据没有私有数据,仅有公共数据

Memfd Create Data (356)

______________

|14 |15 |

--------------

|fdname|flags|

--------------

Dns Query Data (601)

--------------------------------------------------

|14 |15 |16 |17 |18 |19 |20 |21 |

--------------------------------------------------

|query|sa_family|dip|dport|sip|sport|opcode|rcode|

--------------------------------------------------

Create File data (602)

----------------------------------------------------------

|14 |15 |16 |17 |18 |19 |20 |21 |

----------------------------------------------------------

|file_path|dip|dport|sip|sport|sa_family|socket_pid|sb_id|

---------------------------------------------------------

Load Module Data (603)

---------------------------

|14 |15 |16 |

---------------------------

|ko_file|pid_tree|run_path|

---------------------------

Update Cred Data (604)

----------------------

|14 |15 |16 |

----------------------

|pid_tree|old_uid|res|

----------------------

Unlink Data (605)

------

|14 |

------

|file|

------

Rmdir Data (606)

------

|14 |

------

|file|

------

call_usermodehelper_exec Data (607)

-------------------------

|1 |2 |3 |4 |

-------------------------

|data_type|exe|argv|wait|

-------------------------

File Write Data (608)

------------

|14 |15 |

------------

|file|sb_id|

------------

需要通过 Diver Filter 加入待观察列表,详情见 "关于 Driver Filter" 部分

File Read Data (609)

------------

|14 |15 |

------------

|file|sb_id|

------------

需要通过 Diver Filter 加入待观察列表,详情见 "关于 Driver Filter" 部分

USB Device Event Data (610)

-----------------------------------------

|14 |15 |16 |17 |

-----------------------------------------

|product_info|manufacturer|serial|action|

-----------------------------------------

action = 1 is USB_DEVICE_ADD

action = 2 is USB_DEVICE_REMOVE

Privilege Escalation (611)

------------------------------

|14 |15 |16 |17 |

------------------------------

|p_pid|pid_tree|p_cred|c_cred|

------------------------------

p_cred = uid|euid|suid|fsuid|gid|egid|sgid|fsgid

c_cred = uid|euid|suid|fsuid|gid|egid|sgid|fsgid

Port-scan attack detection (612)

------------------------------------------

|1 |2 |3 |4 |5 |6 |7 |

------------------------------------------

|type|sa_family|sip|sport|dip|dport|flags|

------------------------------------------

Proc File Hook (700)

-----------------------

|1 |2 |

-----------------------

|data_type|module_name|

-----------------------

Syscall Table Hook Data (701)

--------------------------------------

|1 |2 |3 |

--------------------------------------

|data_type|module_name|syscall_number|

--------------------------------------

Hidden Kernel Module Data (702)

-----------------------

|1 |2 |

-----------------------

|data_type|module_name|

-----------------------

Interrupt Table Hook Data (703)

----------------------------------------

|1 |2 |3 |

----------------------------------------

|data_type|module_name|interrupt_number|

----------------------------------------

关于 Driver Filter

Elkeid 驱动程序支持白名单以过滤出不需要的数据。我们提供两种类型的白名单,'exe' 白名单和 'argv' 白名单。 'exe' 白名单作用于 execve/create file/dns query/connect hook,而 'argv' 白名单仅作用于 execve hook。 出于性能和稳定性方面的考虑,'exe' 和 'argv' 白名单容量为 64。

白名单的字符串驱动位于: /dev/hids_driver_allowlist

| Operations | Flag | Example |

|---|---|---|

| ADD_EXECVE_EXE_SHITELIST | Y(89) | echo Y/bin/ls > /dev/someone_allowlist |

| DEL_EXECVE_EXE_SHITELIST | F(70) | echo F/bin/ls > /dev/someone_allowlist |

| DEL_ALL_EXECVE_EXE_SHITELIST | w(119) | echo w/del_all > /dev/someone_allowlist |

| EXECVE_EXE_CHECK | y(121) | echo y/bin/ls > /dev/someone_allowlist && dmesg |

| ADD_EXECVE_ARGV_SHITELIST | m(109) | echo m/bin/ls -l > /dev/someone_allowlist |

| DEL_EXECVE_ARGV_SHITELIST | J(74) | echo J/bin/ls -l > /dev/someone_allowlist |

| DEL_ALL_EXECVE_ARGV_SHITELIST | u(117) | echo u/del_all > /dev/someone_allowlist |

| EXECVE_ARGV_CHECK | z(122) | echo z/bin/ls -l > /dev/someone_allowlist && dmesg |

| PRINT_ALL_ALLOWLIST | .(46) | echo ./print_all > /dev/someone_allowlist && dmesg |

| ADD_WRITE_NOTIFI | W(87) | echo W/etc/passwd > /dev/someone_allowlist or echo W/etc/ssh/ > /dev/someone_allowlist support dir |

| DEL_WRITE_NOTIFI | v(120) | echo v/etc/passwd > /dev/someone_allowlist |

| ADD_READ_NOTIFI | R(82) | echo R/etc/passwd > /dev/someone_allowlist or echo R/etc/ssh/ > /dev/someone_allowlist support dir |

| DEL_READ_NOTIFI | s(115) | echo s/etc/passwd > /dev/someone_allowlist |

| DEL_ALL_NOTIFI | A(65) | echo A/del_all_file_notift > /dev/someone_allowlist |

Filter define is:

#define ADD_EXECVE_EXE_SHITELIST 89 /* Y */

#define DEL_EXECVE_EXE_SHITELIST 70 /* F */

#define DEL_ALL_EXECVE_EXE_SHITELIST 119 /* w */

#define EXECVE_EXE_CHECK 121 /* y */

#define PRINT_ALL_ALLOWLIST 46 /* . */

#define ADD_EXECVE_ARGV_SHITELIST 109 /* m */

#define DEL_EXECVE_ARGV_SHITELIST 74 /* J */

#define DEL_ALL_EXECVE_ARGV_SHITELIST 117 /* u */

#define EXECVE_ARGV_CHECK 122 /* z */

#define ADD_WRITE_NOTIFI 87 /* W */

#define DEL_WRITE_NOTIFI 120 /* v */

#define ADD_READ_NOTIFI 82 /* R */

#define DEL_READ_NOTIFI 115 /* s */

#define DEL_ALL_NOTIFI 65 /* A */

关于 Elkeid Driver 性能

Testing Environment(VM):

| CPU | Intel(R) Xeon(R) Platinum 8260 CPU @ 2.40GHz 8 Core |

|---|---|

| RAM | 16GB |

| OS/Kernel | Debian9 / Kernel Version 4.14 |

Testing Load:

| syscall | ltp |

|---|---|

| connect | ./runltp -f syscalls -s connect -t 5m |

| bind | ./runltp -f syscalls -s bind -t 5m |

| execve | ./runltp -f syscalls -s execve -t 5m |

| security_inode_create | ./runltp -f syscalls -s open -t 5m |

| ptrace | ./runltp -f syscalls -s ptrace -t 5m |

Key kprobe Handler Testing Result(90s)

| hook function name | Average Delay(us) | TP99(us) | TP95(us) | TP90(us) |

|---|---|---|---|---|

| connect_syscall_handler | 0.7454 | 3.5017 | 1.904 | 1.43 |

| connect_syscall_entry_handler | 0.0675 | 0.3 | 0.163 | 0.1149 |

| udp_recvmsg_handler | 9.1290 | 68.7043 | 18.5357 | 15.9528 |

| udp_recvmsg_entry_handler | 0.5882 | 7.5631 | 0.7811 | 0.3665 |

| bind_handler | 2.2558 | 10.0525 | 8.1996 | 7.041 |

| bind_entry_handler | 0.4704 | 1.0180 | 0.8234 | 0.6739 |

| execve_entry_handler | 6.9262 | 12.2824 | 9.437 | 8.638 |

| execve_handler | 15.2102 | 36.0903 | 25.9272 | 23.068 |

| security_inode_create_pre_handler | 1.5523 | 7.9454 | 5.5806 | 3.1441 |

| ptrace_pre_handler | 0.2039 | 0.4648 | 0.254 | 0.228 |

udp_recvmsg_handler 仅工作在端口为 53 或 5353 的情况

测试原始数据: Benchmark Data

关于部署

可以使用 DKMS 或者提前编译好 ko 文件然后进行下发

- install driver:

insmod hids_driver.ko - remove driver: first you need kill userspace agent and

rmmod hids_driver.ko

已知问题

-

内核模块 hook 点初始化失败 : do_init_module

在一些老版本的 Ubuntu / CentOS 内核中出现,dmesg 会有如下输出:

do_init_module register_kprobe failed, returned -2.

内核模块仍然可以使用,但没有 do_init_module 数据 -

Description of Elkeid's Crash caused by fput in low version Kernel

License

Elkeid kernel module are distributed under the GNU GPLv2 license.

Elkeid RASP

Introduction

- Analyze the runtime used by the process.

- The following probes are supported for dynamic attach to process:

- CPython

- Golang

- JVM

- NodeJS

- PHP

- Compatible with Elkeid stack.

Install

- build manually: GUIDE

- CMake 3.17+

- GCC 8+

- MUSL toolcahin 1.2.2 (download via CDN: link)

- RUST toolchain 1.40+

- JDK 11+(for Java probe)

- Python2 + Python3 + pip + wheel + header files (for python probe)

- PHP header files

- make and install

git submodule update --recursive --init

make -j$(nproc) build \

STATIC=TRUE \

PY_PREBUILT=TRUE \

CC=/opt/x86_64-linux-musl-1.2.2/bin/x86_64-linux-musl-gcc \

CXX=/opt/x86_64-linux-musl-1.2.2/bin/x86_64-linux-musl-g++ \

LD=/opt/x86_64-linux-musl-1.2.2/bin/x86_64-linux-musl-ld \

CARGO_TARGET_X86_64_UNKNOWN_LINUX_MUSL_LINKER=/opt/x86_64-linux-musl-1.2.2/bin/x86_64-linux-musl-ld \

GNU_CC=/opt/gcc-10.4.0/bin/gcc \

GNU_CXX=/opt/gcc-10.4.0/bin/g++ \

PHP_HEADERS=/path/to/php-headers \

PYTHON2_INCLUDE=/path/to/include/python2.7 \

PYTHON3_INCLUDE=/path/to/include/python3 \

VERSION=0.0.0.1

sudo make install

- build with docker:

curl -fsSL https://lf3-static.bytednsdoc.com/obj/eden-cn/laahweh7uhwbps/php-headers.tar.gz | tar -xz -C rasp/php

docker run --rm -v $(pwd):/Elkeid \

-v /tmp/cache/gradle:/root/.gradle \

-v /tmp/cache/librasp:/Elkeid/rasp/librasp/target \

-v /tmp/cache/rasp_server:/Elkeid/rasp/rasp_server/target \

-v /tmp/cache/plugin:/Elkeid/rasp/plugin/target \

-e MAKEFLAGS="-j$(nproc)" hackerl/rasp-toolchain \

make -C /Elkeid/rasp build \

STATIC=TRUE \

PY_PREBUILT=TRUE \

CC=/opt/x86_64-linux-musl-1.2.2/bin/x86_64-linux-musl-gcc \

CXX=/opt/x86_64-linux-musl-1.2.2/bin/x86_64-linux-musl-g++ \

LD=/opt/x86_64-linux-musl-1.2.2/bin/x86_64-linux-musl-ld \

CARGO_TARGET_X86_64_UNKNOWN_LINUX_MUSL_LINKER=/opt/x86_64-linux-musl-1.2.2/bin/x86_64-linux-musl-ld \

GNU_CC=/opt/gcc-10.4.0/bin/gcc GNU_CXX=/opt/gcc-10.4.0/bin/g++ \

PHP_HEADERS=/Elkeid/rasp/php/php-headers \

PYTHON2_INCLUDE=/usr/local/include/python2.7 \

PYTHON3_INCLUDE=/usr/local/include/python3 \

VERSION=0.0.0.1

Run

- for single process inject

sudo env RUST_LOG=<loglevel> /etc/elkeid/plugin/RASP/elkeid_rasp -p <pid>

- with Elkied Agent (multi target)

Documentation is being written.

License

Elkeid RASP are distributed under the Apache-2.0 license.

关于 Elkeid Agent

Agent提供端上组件的基本能力支撑,包括数据通信、资源监控、组件版本控制、文件传输、机器基础信息采集等。

Agent本身不提供安全能力,作为一个插件底座以系统服务的方式运行。各类功能插件的策略存放于服务器端的配置,Agent接收到相应的控制指令及配置后对自身及插件进行开启、关闭、升级等操作。

Agent与Server之间采用bi-stream gRPC进行通信,基于自签名证书开启双向TLS验证,保障信道安全。其中,Agent -> Server 方向信息流动称为数据流,Server -> Agent 方向信息流动一般为控制流,使用protobuf的不同message类型。Agent本身支持客户端侧服务发现,也支持跨Region级别的通信配置,实现一个Agent包在多个网络隔离的环境下进行安装,基于底层一个TCP连接,在上层实现了Transfer与FileOp两种数据传输服务,支撑了插件本身的数据上报与Host中的文件交互。

Plugins作为安全能力插件,与Agent的进程关系一般为“父——子”进程。以两个pipe作为跨进程通信方式,plugins lib提供了Go与Rust的两个插件库,负责插件端信息的编码与发送。值得一提的是,插件发送数据后,会被编码为Protobuf二进制数据,Agent接收到后无需二次解编码,再其外层拼接好Header特征数据,直接传输给Server,一般情况下Server也无需解码,直接传输至后续数据流中,使用时进行解码,一定程度上降低了数据传输中多次编解码造成的额外性能开销。

Agent采用Go实现,在Linux下,通过systemd作为守护方式,受cgroup限制控制资源使用,支持aarch64与x86-64架构,最终编译、打包为deb与rpm包分发,格式均符合systemd及Debian、RHEL规范,可以直接提供至对应的软件仓库中进行后续版本维护。在后续版本中,将会发布用于Windows平台下的Agent。

运行时要求

Agent及Plugin提供的大部分功能需要以root权限运行在宿主机(Host)层面,在权限受限的容器中,部分功能可能会存在异常。

快速开始

通过 elkeidup 的完整部署,可以直接得到用于Debian/RHEL系列发行版的安装包,并按照 Elkeid Console - 安装配置 界面的命令进行安装部署。

手动编译

环境要求

确认相关配置

- 需要确保

transport/connection目录下的ca.crt、client.key、client.crt三个文件与Agent Centerconf目录下的同名文件保持一致。 - 需要确保

transport/connection/product.go文件中的参数都配置妥当:- 如果是手动部署的Server:

serviceDiscoveryHost["default"]需被赋值为 ServiceDiscovery 服务或代理服务的内网监听地址与端口,例如:serviceDiscoveryHost["default"] = "192.168.0.1:8088"privateHost["default"]需被赋值为 AgentCenter 服务或代理服务的内网监听地址与端口,例如:privateHost["default"] = "192.168.0.1:6751"- 如有Server的公网接入点,

publicHost["default"]需被赋值为 AgentCenter 服务或代理服务的外网监听地址与端口,例如:publicHost["default"]="203.0.113.1:6751"

- 如果是通过 elkeidup 部署的Server,可以根据部署Server机器的

~/.elkeidup/elkeidup_config.yaml文件获得对应配置:- 在配置文件中找到 Nginx 服务的IP,具体的配置项为

nginx.sshhost[0].host - 在配置文件中找到 ServiceDiscovery 服务的IP,具体的配置项为

sd.sshhost[0].host serviceDiscoveryHost["default"]需被赋值为 ServiceDiscovery 服务的IP,并将端口号设置为8088,例如:serviceDiscoveryHost["default"] = "192.168.0.1:8088"privateHost["default"]需被赋值为 Nginx 服务的IP,并将端口号设置为8090,例如:privateHost["default"] = "192.168.0.1:8090"

- 在配置文件中找到 Nginx 服务的IP,具体的配置项为

- 如果是手动部署的Server:

编译

在Agent根目录,执行:

BUILD_VERSION=1.7.0.24 bash build.sh

在编译过程中,脚本会读取 BUILD_VERSION 环境变量设置版本信息,可根据实际需要进行修改。

编译成功后,在根目录的 output 目录下,应该可以看到2个deb与2个rpm文件,它们分别对应不同的系统架构。

版本升级

- 如果没有创建过客户端类型的组件,请在 Elkeid Console-组件管理 界面新建对应组件。

- 在 Elkeid Console - 组件管理 界面,找到“elkeid-agent”条目,点击右侧“发布版本”,填写版本信息并上传对应平台与架构的文件,点击确认。

- 在 Elkeid Console - 组件策略 界面,(如有)删除旧的“elkeid-agent”版本策略,点击“新建策略”,选中刚刚发布的版本,点击确认。后续新安装的Agent均会自升级到最新版本。

- 在 Elkeid Console - 任务管理 界面,点击“新建任务”,选择全部主机,点击下一步,选择“同步配置”任务类型,点击确认。随后,在此页面找到刚刚创建的任务,点击运行,即可对存量旧版本Agent进行升级。

License

Elkeid Agent is distributed under the Apache-2.0 license.

Baseline

基线插件通过已有或自定义的基线策略对资产进行检测,来判断资产上的基线安全配置是否存在风险。基线插件每天定时扫描一次,同时也可以通过前端进行立即检查。

平台兼容性

- centos 6,7,8

- debian 8,9,10

- ubuntu 14.04-20.04

(其余版本以及发行版理论兼容)

需要的编译环境

- Go >= 1.18

编译

rm -rf output

mkdir output

# x86_64

go build -o baseline main.go

tar -zcvf baseline-linux-x86_64.tar.gz baseline config

mv baseline-linux-x86_64.tar.gz output/

# arch64

GOARCH=arm64 go build -o baseline main.go

tar -zcvf baseline-linux-x86_64.tar.gz baseline config

mv baseline-linux-x86_64.tar.gz output/

编译成功后,在根目录的 output 目录下,应该可以看到2个deb与2个rpm文件,它们分别对应不同的系统架构。

版本升级

- 如果没有创建过客户端类型的组件,请在 Elkeid Console-组件管理 界面新建对应组件。

- 在 Elkeid Console - 组件管理 界面,找到“collector”条目,点击右侧“发布版本”,填写版本信息并上传对应平台与架构的文件,点击确认。

- 在 Elkeid Console - 组件策略 界面,(如有)删除旧的“collector”版本策略,点击“新建策略”,选中刚刚发布的版本,点击确认。后续新安装的Agent的插件均会自升级到最新版本。

- 在 Elkeid Console - 任务管理 界面,点击“新建任务”,选择全部主机,点击下一步,选择“同步配置”任务类型,点击确认。随后,在此页面找到刚刚创建的任务,点击运行,即可对存量旧版本插件进行升级。

基线配置

常规配置

基线插件的规则通过yaml文件配置,其中主要包括以下字段(建议参照config文件下实际配置对比):

check_id: 检查项id(int)

type: "类型(英文)"

title: "标题(英文)"

description: "描述(英文)"

solution: "解决方案(英文)"

security: "安全等级(high/mid/low)"

type_cn: "类型"

title_cn: "标题"

description_cn: "描述"

solution_cn: "解决方案"

check: # 检查规则(详见自定义规则)

rules:

- type: "file_line_check"

param:

- "/etc/login.defs"

filter: '\s*\t*PASS_MAX_DAYS\s*\t*(\d+)'

result: '$(<=)90'

自定义规则

每个检查项配置中的"check.rules"字段即为匹配规则,下边对每个字段进行解释:

rules.type

检查方式,目前baseline插件适配的内置检测规则(src/check/rules.go)包括如下几种:

| 检测规则 | 含义 | 参数 | 返回值 |

| ---- | ---- | ---- | ---- |

| command_check | 运行命令行语句 | 1:命令行语句

2:特殊参数(如ignore_exit 认为当命令行报错时认为通过检测) | 命令运行结果

| file_line_check | 遍历文件,逐行匹配 | 1:文件绝对路径

2:该行的flag(用于快速筛选行,减轻正则匹配的压力)

3:该文件的注释符(默认为#) | true/false/正则筛选值

| file_permission | 检测文件权限是否符合安全配置 | 1: 文件绝对路径

2: 文件最小权限(基于8进制,如644) | true/false

| if_file_exist | 判断文件是否存在 | 1: 文件绝对路径 | true/false

| file_user_group | 判断文件用户组 | 1: 文件绝对路径

2: 用户组id | true/false

| file_md5_check | 判断文件MD5是否一致 | 1: 文件绝对路径

2: MD5 | true/false

| func_check | 通过特殊基线规则判断 | 1: 目标规则 | true/false

rules.param

规则参数数组

rules.require

规则前提条件:一些安全基线配置可能会存在检测前提条件,如果满足了先决条件后才会存在安全隐患,如:

rules:

- type: "file_line_check"

require: "allow_ssh_passwd"

param:

- "/etc/ssh/sshd_config"

filter: '^\s*MaxAuthTries\s*\t*(\d+)'

result: '$(<)5'

allow_ssh_passwd: 允许用户通过ssh密码登录

rules.result

检测结果,支持int,string,bool类型结果, 其中被*$()*为特殊检测语法,以下为部分语法示例: | 检测语法 | 说明 | 示例 | 示例含义 | | ---- | ---- | ---- | ---- | | $(&&) | 包含条件 | ok$(&&)success| 结果为ok或success | | $(<=) | 常见运算符 | $(<=)4| 结果小于等于4 | | $(not) | 结果取反 | $(not)error| 结果不为error |

复杂示例:

$(<)8$(&&)$(not)2 : 目标小于8且目标不为2

check.condition

由于规则的rule可能存在多个,因此可以通过condition字段定义规则之间的关系

all: 全部规则命中,则通过检测

any: 任一规则命中,则通过检测

none: 无规则命中,则通过检测

下发任务

任务下发

{

"baseline_id": 1200, // 基线id

"check_id_list":[1,2,3] // 扫描检查项列表(空列表为全部扫描)

}

结果回传

{

"baseline_id": 1200, // 基线id

"status": "success", // 检测状态success|error

"msg": "", // 错误原因

"check_list":[

"check_id": 1, // 检查项id

"type": "", // 类型(英文)

"title": "", // 检查项标题(英文)

"description": "", // 检查项描述(英文)

"solution": "", // 解决方案(英文)

"type_cn": "", // 类型

"title_cn": "", // 检查项标题

"description_cn": "", // 检查项描述

"solution_cn": "", // 解决方案

"result": "", // 检查结果

"msg": "", // 错误原因

]

}

检查结果:

SuccessCode = 1 // 成功

FailCode = 2 // 失败

ErrorCode = -1 // 其他错误

ErrorConfigWrite = -2 // 配置编写不规范

ErrorFile = -3 // 文件读写异常

关于collector插件

collector周期性采集主机上的各类资产信息,并进行关联分析,目前支持以下资产类型:

- 进程:支持对exe md5的哈希计算,后续可关联威胁情报分析,另外与容器信息进行关联,支撑后续数据溯源功能。(跨容器)

- 端口:支持tcp、udp监听端口的信息提取,以及与进程、容器信息的关联上报。另外基于sock状态及其关系,分析对外暴露服务,向上支撑主机暴露面分析功能。(跨容器)

- 账户:除了基本的账户字段外,基于弱口令字典进行端上hash碰撞检测弱口令,向上提供了Console的弱口令基线检测功能。另外,会关联分析sudoers配置,一同上报。

- 软件:支持系统软件包、pypi包、jar包,向上支撑漏洞扫描功能。(部分跨容器)

- 容器:支持docker、cri/containerd等多种运行时下的容器信息采集。

- 应用:支持数据库、消息队列、容器组件、Web服务、DevOps工具等类型的应用采集、目前支持30+中常见应用的版本、配置文件的匹配与提取。(跨容器)

- 硬件:支持网卡、磁盘等硬件信息的采集。

- 系统完整性校验:通过将软件包文件哈希与Host实际文件哈希进行对比,判断文件是否有被更改。

- 内核模块:采集基本字段,以及内存地址、依赖关系等额外字段。

- 系统服务、定时任务:兼容不同发行版下的服务及cron位置的定义,并对核心字段进行解析。

运行时要求

支持主流的Linux发行版,包括CentOS、RHEL、Debian、Ubuntu、RockyLinux、OpenSUSE等。支持x86-64与aarch64架构。

快速开始

通过 elkeidup 的完整部署,此插件默认开启。

手动编译

环境要求

- Go >= 1.18

编译

在Agent根目录,执行:

BUILD_VERSION=1.7.0.140 bash build.sh

在编译过程中,脚本会读取 BUILD_VERSION 环境变量设置版本信息,可根据实际需要进行修改。

编译成功后,在根目录的 output 目录下,应该可以看到2个deb与2个rpm文件,它们分别对应不同的系统架构。

版本升级

- 如果没有创建过客户端类型的组件,请在 Elkeid Console-组件管理 界面新建对应组件。

- 在 Elkeid Console - 组件管理 界面,找到“collector”条目,点击右侧“发布版本”,填写版本信息并上传对应平台与架构的文件,点击确认。

- 在 Elkeid Console - 组件策略 界面,(如有)删除旧的“collector”版本策略,点击“新建策略”,选中刚刚发布的版本,点击确认。后续新安装的Agent的插件均会自升级到最新版本。

- 在 Elkeid Console - 任务管理 界面,点击“新建任务”,选择全部主机,点击下一步,选择“同步配置”任务类型,点击确认。随后,在此页面找到刚刚创建的任务,点击运行,即可对存量旧版本插件进行升级。

License

collector is distributed under the Apache-2.0 license.

关于driver插件

driver 插件对 内核模块 进行管理,并利用用户态数据进行补充、过滤,最终生成不同的系统事件,支撑相关告警功能。

运行时要求

支持主流的Linux发行版,包括CentOS、RHEL、Debian、Ubuntu、RockyLinux、OpenSUSE等。支持x86-64与aarch64架构。

主机的内核版本需要在支持的的列表中,如果不在,需要单独编译并上传,详见 说明 。

快速开始

通过 elkeidup 的完整部署,此插件默认开启。

手动编译

环境要求

确认相关配置

- 需要确保

src/config.rs中DOWNLOAD_HOSTS变量已配置为实际部署的Nginx服务地址:- 如果是手动部署的Server:需要确保将其配置为Nginx文件服务的地址,例如:

pub const DOWNLOAD_HOSTS: &'static [&'static str] = &["http://192.168.0.1:8080"]; - 如果是通过 elkeidup 部署的Server,可以根据部署Server机器的

~/.elkeidup/elkeidup_config.yaml文件获得对应配置,具体配置项为nginx.sshhost[0].host,并将端口号设置为8080,例如:pub const DOWNLOAD_HOSTS: &'static [&'static str] = &["http://192.168.0.1:8080"];

- 如果是手动部署的Server:需要确保将其配置为Nginx文件服务的地址,例如:

编译

在根目录,执行:

BUILD_VERSION=1.0.0.15 bash build.sh

在编译过程中,脚本会读取 BUILD_VERSION 环境变量设置版本信息,可根据实际需要进行修改。

编译成功后,在根目录的 output 目录下,应该可以看到2个plg文件,它们分别对应不同的系统架构。

版本升级

- 如果没有创建过客户端类型的组件,请在 Elkeid Console-组件管理 界面新建对应组件。

- 在 Elkeid Console - 组件管理 界面,找到“collector”条目,点击右侧“发布版本”,填写版本信息并上传对应平台与架构的文件,点击确认。

- 在 Elkeid Console - 组件策略 界面,(如有)删除旧的“collector”版本策略,点击“新建策略”,选中刚刚发布的版本,点击确认。后续新安装的Agent的插件均会自升级到最新版本。

- 在 Elkeid Console - 任务管理 界面,点击“新建任务”,选择全部主机,点击下一步,选择“同步配置”任务类型,点击确认。随后,在此页面找到刚刚创建的任务,点击运行,即可对存量旧版本插件进行升级。

License

driver plugin is distributed under the Apache-2.0 license.

关于Journal Watcher插件

Journal Watcher 通过读取 sshd 的日志,并进行解析,生成sshd登陆、gssapi事件。

运行时要求

支持主流的Linux发行版,包括CentOS、RHEL、Debian、Ubuntu、RockyLinux、OpenSUSE等。支持x86-64与aarch64架构。

快速开始

通过 elkeidup 的完整部署,此插件默认开启。

手动编译

环境要求

编译

在根目录,执行:

BUILD_VERSION=1.7.0.23 bash build.sh

在编译过程中,脚本会读取 BUILD_VERSION 环境变量设置版本信息,可根据实际需要进行修改。

编译成功后,在根目录的 output 目录下,应该可以看到2个plg文件,它们分别对应不同的系统架构。

版本升级

- 如果没有创建过客户端类型的组件,请在 Elkeid Console-组件管理 界面新建对应组件。

- 在 Elkeid Console - 组件管理 界面,找到“collector”条目,点击右侧“发布版本”,填写版本信息并上传对应平台与架构的文件,点击确认。

- 在 Elkeid Console - 组件策略 界面,(如有)删除旧的“collector”版本策略,点击“新建策略”,选中刚刚发布的版本,点击确认。后续新安装的Agent的插件均会自升级到最新版本。

- 在 Elkeid Console - 任务管理 界面,点击“新建任务”,选择全部主机,点击下一步,选择“同步配置”任务类型,点击确认。随后,在此页面找到刚刚创建的任务,点击运行,即可对存量旧版本插件进行升级。

License

journal_watcher plugin is distributed under the Apache-2.0 license.

-

- 1.1. 平台兼容性

- 1.2. Agent/后端 兼容性

-

- 2.1. Docker 完整docker编译环境 & 编译产物

- 2.2. 编译

-

- 3.1. [ 检控扫描目录配置](#.srcconfig.rs)

- 3.2. [ 引擎配置](#.srcmodelengineclamavconfig.rs)

- 3.3. [可选 : 1. Clamav Database配置](#:1.ClamavDatabase.srcmodelengineclamavupdater.rs)

- 3.4. 可选 : 2. database 中的规则

Elkeid-Scanner

1. 关于 Scanner 插件

当前版本 1.9.X

Scanner 使用 clamav 引擎对系统进程和敏感目录进行周期扫描,以发现可疑静态文件(UPX/挖矿二进制/后门/木马/可疑脚本文件/...)。

1.1. 平台兼容性

与Elkeid Agent相同,目前预编译产物已支持 x86_64、Aarch64。

1.2. Agent/后端 兼容性